Quantum computing: dimostrato algoritmo con vantaggio esponenziale rispetto alla logica binaria

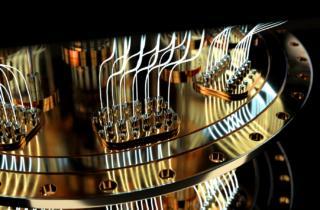

Per anni, il mondo del quantum computing ha rincorso un obiettivo ritenuto quasi mitologico: dimostrare in modo concreto e inconfutabile che un computer quantistico può risolvere un problema esponenzialmente più velocemente rispetto al miglior computer classico esistente. Ora, questo traguardo è stato finalmente raggiunto da un team di ricercatori delle università di USC e Johns Hopkins utilizzando due processori IBM Eagle da 127 qubit. Il loro lavoro, pubblicato su Physical Review X, segna una svolta storica, visto che per la prima volta, è stato ottenuto un vantaggio quantistico esponenziale incondizionato.

L’esperimento si è basato su una variante del cosiddetto Simon’s Problem, un rompicapo matematico spesso utilizzato come benchmark teorico per testare le capacità degli algoritmi quantistici. In termini semplici, si tratta di individuare una “regola nascosta” all’interno di una funzione: un gioco in cui un partecipante deve indovinare un numero segreto confrontando le risposte fornite da un oracolo. Se due domande diverse ricevono la stessa risposta, è possibile dedurre il numero segreto. Un computer quantistico può risolvere questo problema molto più rapidamente di uno classico e proprio su questo principio si basa l’esperimento.

Finora, però, tutti i tentativi di dimostrare un’accelerazione esponenziale concreta erano basati su ipotesi non verificate, come l’assenza di algoritmi classici più efficienti ancora da scoprire. Stavolta, invece, la dimostrazione è incondizionata, cioè non si fonda su nessuna supposizione non dimostrata. “È la forma più forte di vantaggio che ci si possa aspettare da un computer quantistico” spiega Daniel Lidar, professore di ingegneria alla USC e uno dei massimi esperti mondiali in correzione degli errori quantistici.

Come è stato possibile? Quattro tecniche chiave

Per riuscire in questa impresa, i ricercatori hanno dovuto spremere ogni goccia di performance possibile dall’hardware quantistico, affrontando il nemico numero uno di questi sistemi rappresentato dal rumore quantistico, ossia la somma di piccoli errori che si accumulano durante l’elaborazione e rendono i risultati instabili o inaffidabili.

Il team ha adottato quattro strategie principali:

- Riduzione della complessità del problema: hanno limitato il numero di variabili segrete da individuare, il che ha permesso di eseguire circuiti più brevi e quindi più resistenti agli errori

- Transpilazione ottimizzata: grazie a tecniche avanzate di “transpilazione” (traduzione ottimale degli algoritmi nei linguaggi comprensibili dall’hardware), hanno ridotto al minimo il numero di operazioni logiche richieste

- Decoupling dinamico: questa tecnica consiste nell’applicare impulsi calibrati in modo estremamente preciso per isolare i qubit dall’ambiente esterno e ridurre il decadimento della coerenza quantistica. È stata la mossa più determinante per il successo dell’esperimento

- Mitigazione degli errori di misura: hanno corretto gli errori residui legati all’imprecisione nelle letture finali dello stato dei qubit, migliorando ulteriormente l’affidabilità dei risultati.

Un divario che cresce con ogni variabile

L’aspetto davvero rivoluzionario del risultato non è tanto nella velocità assoluta quanto nella scalabilità del vantaggio. Lidar chiarisce che un’accelerazione esponenziale significa che, per ogni nuova variabile aggiunta al problema, il divario tra prestazioni quantistiche e classiche raddoppia. Questo vantaggio, destinato a crescere all’aumentare della complessità del problema, è stato ottenuto senza presupporre limiti nascosti alla capacità dei computer classici. In passato, alcuni risultati simili erano stati messi in dubbio proprio per l’assenza di garanzie su questo punto. Ora, invece, il vantaggio quantistico “non è più reversibile”, dice Lidar.

È bene chiarire che questa scoperta, per quanto storica, non ha ancora ricadute pratiche immediate. Il problema risolto, seppur importante, è infatti astratto e non rappresenta una situazione reale nel mondo industriale o scientifico. Inoltre, lo scenario di calcolo utilizzava un oracolo (cioè una funzione che conosce già la risposta), il che non è realistico per la maggior parte delle applicazioni pratiche.

Tuttavia, è un passo fondamentale, dal momento che per la prima volta un vantaggio quantistico teorico è stato trasformato in un risultato misurabile e inconfutabile. Dimostra inoltre che l’hardware odierno, se ben gestito e ottimizzato, può superare i limiti che fino a ieri sembravano insormontabili. La sfida ora sarà replicare questo vantaggio in scenari più complessi, con problemi “naturali”, senza oracoli, e con architetture hardware ancora più affidabili e stabili.