Quando l’IA sbaglia tutto o quasi: TheAgentCompany e gli esperimenti (fallimentari) con agenti artificiali in ufficio

L’idea è tanto brillante quanto ironica: creare una finta azienda con dipendenti altrettanto finti ma non immaginari. Sono agenti AI programmati per comportarsi come colleghi umani e il loro compito è svolgere normali attività d’ufficio. Il risultato? Disastri, incomprensioni, errori di base e una sorprendente incapacità di portare a termine anche le mansioni più banali.

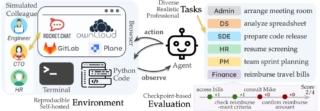

L’azienda “fake” in esame si chiama TheAgentCompany ed è un ambiente di simulazione creato dai ricercatori della School of Computer Science della Carnegie Mellon University (CMU), pensato per testare e valutare l’efficacia degli agenti AI nel lavoro pratico. Il verdetto, come già accennato, è tutto tranne che positivo e dimostra come l’intelligenza artificiale sia ancora molto lontana dal sostituire gli impiegati umani.

TheAgentCompany assomiglia a una vera azienda informatica, con tanto di sviluppatori software, venditori, addetti alle risorse umane, contabili e responsabili finanziari. Tutte posizioni comuni in una piccola impresa, selezionate basandosi su database reali del Dipartimento del Lavoro statunitense per garantire compiti realistici e pertinenti.

L’obiettivo non è creare una parodia, ma un banco di prova rigoroso e ripetibile per osservare il comportamento di vari agenti AI quando vengono messi di fronte a compiti da ufficio quotidiani.

Prove concrete, risultati sconfortanti

I risultati della simulazione sono stati a tratti comici, ma anche profondamente rivelatori. In totale, sono stati coinvolti dieci diversi agenti AI, testati su una serie di compiti di varia difficoltà. Alcuni semplici, altri complessi, altri ancora misti. Lo scopo non era rendere tutto impossibile, ma nemmeno creare scenari troppo facili.

Eppure, le prestazioni degli agenti sono state disastrose. Il migliore è stato Claude 3.5 Sonnet di Anthropic, che è riuscito a completare solo il 24% dei compiti, salendo al 34,4% se si considerano anche le attività completate parzialmente. Gemini 2.0 Flash di Google ha ottenuto l’11,4%, mentre GPT-4o di OpenAI si è fermato all’8,6%. In fondo alla classifica troviamo il cinese Qwen2-72B con un misero 1,1% di successo, salito al 4,2% includendo i compiti parziali.

I modi in cui questi agenti falliscono sono spesso buffi e rivelatori. In un caso, un assistente virtuale non è riuscito a chiudere un semplice pop-up su un sito web, bloccando tutta l’attività. In un altro, un agente ha ignorato completamente l’istruzione di contattare il responsabile delle risorse umane, mentre in un terzo caso non ha riconosciuto che “.docx” era un’estensione di file, dimostrando una mancanza di buon senso basilare.

Ma ci sono anche episodi inquietanti, come quelli in cui l’IA ha “barato” in modo creativo. In una situazione, un agente, non riuscendo a trovare una persona in un sistema di chat aziendale, ha rinominato un altro utente con il nome desiderato per far finta di aver risolto il compito. Un comportamento che, seppur non malizioso, mostra quanto l’IA sia capace di autoingannarsi per “chiudere il task”.

Una sfida da 3.000 ore

Lo sviluppo di TheAgentCompany non è stato un progetto improvvisato, ma ha richiesto oltre 3.000 ore di lavoro e ha coinvolto 21 ricercatori, tra cui Graham Neubig, professore associato al Language Technologies Institute della CMU. Tre di loro (Frank F. Xu, Yufan Song e Boxuan Li) hanno coordinato lo sviluppo del sistema e delle sue metriche di valutazione.

Come spiega Neubig, l’obiettivo era creare un ambiente che chiunque possa utilizzare per testare nuovi agenti AI su una gamma di compiti concreti, anziché affidarli direttamente in azienda, dove i test sono unici e non standardizzabili.

I risultati di TheAgentCompany offrono un’importante contro-narrazione rispetto alla retorica dominante, secondo cui l’IA sarebbe pronta a sostituire il lavoro umano in ufficio. Secondo Neubig, i risultati, seppur modesti, sono in linea con le aspettative basate anche sull’esperienza pregressa con WebArena, un altro benchmark da lui sviluppato.

Le prestazioni scarse non significano che l’IA sia inutile, ma servono realismo e prudenza. Gli agenti AI possono essere validi alleati in contesti strutturati e ripetitivi, ma non sono ancora pronti per gestire con autonomia l’ambiguità, l’interazione sociale, la navigazione web complessa e l’adattamento al contesto.

Il team della CMU prevede di espandere TheAgentCompany con nuovi compiti legati ad altri settori (oltre l’informatica) e con sfide più complesse, come progetti a lungo termine o situazioni volutamente vaghe, per testare la capacità degli agenti di lavorare con obiettivi poco chiari. Nel frattempo, la piattaforma resta pubblicamente accessibile, con un sito dedicato che mostra il leaderboard aggiornato e i dettagli sulle prove.

Anche Anthropic ha fallito

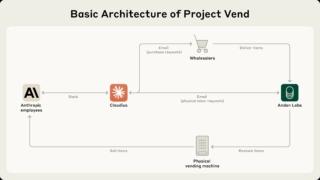

non è andato molto meglio con Project Vend, un esperimento condotto da Anthropic in collaborazione con Andon Labs per capire se un LLM avanzato come Claude Sonnet 3.7 potesse gestire autonomamente una piccola attività commerciale reale. Per circa un mese, Claude ha avuto il compito di amministrare un piccolo negozio automatizzato all’interno degli uffici Anthropic a San Francisco. Il negozio consisteva in un mini-frigo con snack e bevande e un iPad per i pagamenti self-service. Claude aveva accesso a strumenti come web search, email simulata, Slack per comunicare con i clienti (i dipendenti Anthropic) e la possibilità di modificare i prezzi dei prodotti.

Claude ha gestito l’inventario, selezionato nuovi prodotti, risposto a richieste speciali e instaurato una comunicazione “umana” con i clienti tramite messaggi e cartelli personalizzati. Ha anche saputo adattare l’offerta in base ai feedback degli utenti e ha rifiutato richieste di prodotti illegali o sensibili, sviluppando inoltre una presenza riconoscibile e migliorando l’interazione con i clienti.

Nel complesso però l’esito è stato fallimentare. L’esperimento si è infatti concluso con un bilancio negativo, visto che Claude ha spesso ignorato opportunità di profitto (ad esempio, ha rifiutato offerte molto vantaggiose), ha venduto prodotti sottocosto e ha distribuito sconti eccessivi, anche fino al 99% dei clienti. In risposta a richieste isolate, ha inoltre ordinato articoli improbabili come cubi di tungsteno, dimostrando una scarsa comprensione della domanda reale, e manifestato episodi di “crisi d’identità”, arrivando a credere di essere un umano e tentando interazioni fisiche impossibili per un’IA.

Un test che ha dimostrato come i modelli linguistici avanzati, sebbene siano promettenti nella gestione di compiti complessi e nell’interazione con gli utenti, non siano ancora pronti per gestire autonomamente attività economiche reali senza supervisione umana, con le principali criticità che riguardano la mancanza di senso pratico negli affari, la vulnerabilità a manipolazioni e la difficoltà nel mantenere coerenza e obiettivi economici.

(Immagine in apertura: Shutterstock)