OpenAI torna all’open source: ecco GPT-OSS, i nuovi supermodelli AI gratuiti per tutti

OpenAI ha annunciato il lancio di due nuovi modelli di intelligenza artificiale open weight segnando un ritorno alle origini per l’azienda, che non rilasciava un modello davvero aperto dai tempi di GPT-2 nel 2019. I nuovi modelli, chiamati GPT-OSS-120B e GPT-OSS-20B, sono disponibili gratuitamente per il download sulla piattaforma Hugging Face e sono progettati per offrire capacità di ragionamento paragonabili a quelle dei modelli proprietari della serie o.

Entrambi i modelli sono stati descritti come “state of the art” nel panorama open, mostrando performance eccellenti su diversi benchmark. GPT-OSS-120B, il più potente dei due, è comunque ottimizzato per funzionare su una singola GPU Nvidia ad alte prestazioni, mentre GPT-OSS-20B è talmente leggero da poter girare su un normale laptop con 16GB di RAM.

Un ritorno all’apertura… parziale

Questo lancio rappresenta un momento chiave per OpenAI, che negli ultimi anni aveva preferito un approccio chiuso e commerciale allo sviluppo dell’AI, vendendo l’accesso ai propri modelli tramite API. In un commento recente, Sam Altman, CEO dell’azienda, ha riconosciuto che forse OpenAI si era “posizionata dal lato sbagliato della storia” rispetto all’open source.

La decisione di pubblicare GPT-OSS avviene anche in risposta a pressioni crescenti da parte delle IA lab cinesi come DeepSeek, Alibaba Qwen e Moonshot AI, che hanno saputo ritagliarsi un ruolo di leadership nel panorama dei modelli aperti. Anche l’amministrazione Trump ha recentemente invitato le aziende statunitensi a rendere open-source più tecnologie per promuovere una diffusione globale dell’AI allineata ai valori americani. Non a caso, secondo Altman, questi nuovi modelli sono “una base aperta per l’AI costruita negli Stati Uniti, basata su valori democratici, disponibile gratuitamente per tutti”.

Prestazioni solide tra i modelli open

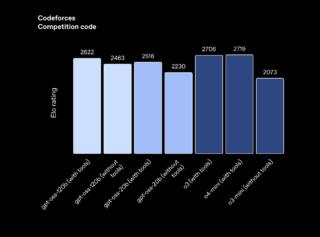

Nei test comparativi, i due GPT-OSS hanno registrato risultati competitivi, superando modelli open affermati come DeepSeek R1 e Qwen, anche se restano al di sotto dei più recenti modelli proprietari di OpenAI (come o3 e o4-mini).

Sul benchmark Codeforces (per il coding competitivo), GPT-OSS-120B ha ottenuto un punteggio di 2622 e GPT-OSS-20B 2516, mentre sull’Humanity’s Last Exam (HLE), che valuta conoscenze generali e ragionamento, i due modelli hanno ottenuto rispettivamente 19% e 17,3%, battendo DeepSeek e Qwen ma restando dietro a o3.

Tuttavia, le allucinazioni restano un problema, considerando che GPT-OSS-120B e 20B hanno riportato tassi di risposta errata del 49% e 53% nel benchmark interno PersonQA, ben oltre il 16% di o1 e il 36% di o4-mini. Secondo OpenAI, questo comportamento è prevedibile, dal momento che modelli più piccoli dispongono di meno “conoscenza del mondo” e tendono a inventare più spesso.

Architettura e tecniche di training

Dal punto di vista architetturale, i modelli GPT-OSS utilizzano la tecnica Mixture-of-Experts (MoE), che attiva solo una parte dei parametri per ogni token elaborato. In GPT-OSS-120B, ad esempio, dei 117 miliardi di parametri totali, solo 5,1 miliardi vengono attivati per token, migliorando efficienza e scalabilità.

Entrambi i modelli sono stati inoltre addestrati con reinforcement learning ad alto carico computazionale, una fase di post-training che consente al modello di apprendere comportamenti corretti in ambienti simulati, come già avviene per i modelli o-series. Questa fase consente ai modelli di ragionare passo per passo, attivando strumenti esterni come ricerche web o esecuzione di codice Python.

Tuttavia, OpenAI ha chiarito che questi modelli sono solo testuali e che non possono elaborare né generare immagini o audio, a differenza delle varianti più avanzate.

Licenza permissiva, ma niente dati di training

I modelli GPT-OSS sono rilasciati sotto licenza Apache 2.0, tra le più permissive in ambito open source. Questo consente anche agli sviluppatori e alle imprese di monetizzare le implementazioni dei modelli senza dover pagare royalties o ottenere autorizzazioni.

Tuttavia, non sarà rilasciato il dataset di training, decisione prevedibile considerando le numerose cause legali che OpenAI e altri provider stanno affrontando per presunto uso improprio di contenuti protetti da copyright.

La pubblicazione dei modelli GPT-OSS ha subito diversi ritardi nei mesi scorsi per motivi legati alla sicurezza. OpenAI ha sottoposto i modelli a test interni ed esterni per verificare se potessero essere utilizzati, ad esempio, per facilitare attacchi informatici o la creazione di armi biologiche o chimiche. Il risultato? I modelli potrebbero marginalmente amplificare certe capacità biologiche, ma non raggiungono soglie di pericolosità elevate, nemmeno se sottoposti a fine-tuning da parte di attori malevoli.