OpenAI accusa DeepSeek di “distillazione abusiva”, ma adotta due pesi e due misure

Un anno fa di questi tempi, la cinese DeepSeek rilasciava R1, un LLM “reasoning” in grado di tenere testa ai modelli più potenti di OpenAI, Anthropic e Google, realizzato però impiegando una frazione dei costi sostenuti dai giganti della Silicon Valley. E lo aveva rilasciato come open source su Hugging Face.

La cosa aveva generato uno scossone sui titoli tech in borsa ed è stato probabilmente l’inizio dello scetticismo dei mercati verso l’effettiva necessità di investire centinaia di miliardi per la creazione di nuovi data center. L’espressione bolla AI ha cominciato allora a essere ripetuta sempre più spesso.

Già ai tempi, OpenAI aveva sostenuto che DeepSeek avesse utilizzato pesantemente i suoi modelli per addestrare il modello R1 attraverso la tecnica della distillazione: in pratica, un modello più grande e potente viene usato per valutare le risposte di un modello più piccolo, trasferendogli la propria conoscenza in modo più efficiente. Questa operazione è di solito affidata a personale umano (si parla in questo caso di addestramento di rinforzo da feedback umano, RLHF) ed è uno dei passaggi più lenti e costosi nella realizzazione di un LLM, perché richiede migliaia di operatori.

Oggi OpenAI formalizza quelle accuse in una lettera inviata al Comitato della Camera sulla competizione strategica tra gli Stati Uniti e il Partito Comunista Cinese. Nella lettera, che Reuters ha potuto leggere, l’azienda denuncia i “continui sforzi fatti da DeepSeek per approfittare delle capacità sviluppate da OpenAI e altri laboratori AI di frontiera americani”.

OpenAI specifica che diversi account riconducibili a impiegati di DeepSeek abbiano sviluppato metodi e software per aggirare le restrizioni all’accesso che OpenAI ha messo in piedi per impedire l’utilizzo dei propri modelli per la distillazione, pratica vietata dalle sue linee guida.

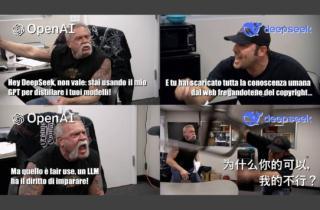

È buffo che un’accusa di questo tipo venga proprio dall’azienda che ha costruito la propria fortuna saccheggiando a mani basse la conoscenza umana disponibile su Internet, anche ricorrendo al download di archivi di libri piratati e ignorando le linee guida dei siti web che vietavano espressamente il download automatizzato allo scopo di creare basi di dati dei propri contenuti.

In questi anni, OpenAI e le altre aziende tech hanno sempre sostenuto che la propria attività non fosse una violazione del copyright degli autori, ma che rientrasse in quello che la legge americana definisce utilizzo legittimo (fair use), inquadrandolo in quello che definisce un diritto di imparare di cui i modelli AI godrebbero.

Con gli usuali toni millenaristi, sempre in bilico tra un radioso futuro per l’umanità e la minaccia alla supremazia tecnologica americana, OpenAi ha chiesto all’amministrazione Trump non solo di sposare la sua visione sul fair use e il diritto all’apprendimento, ma anche di imporla ai partner stranieri. In particolare, si scaglia contro le normative europee che obbligano le aziende AI a rispettare la volontà degli autori riguardo al consenso all’uso delle proprie opere per l’addestramento di modelli

Apparentemente, lo stesso diritto non vale più quando a imparare è un modello più giovane e snello che viene dalla Cina e i contenuti da cui apprende sono quelli generati da OpenAI.