Nvidia punta sull’inferenza e dice che i suoi server decuplicano la velocità degli LLM

Con quella che sembra a tutti gli effetti una risposta alle notizie dei giorni scorsi sui traguardi dei chip IA proprietari di Google, Amazon e Microsoft, che si sono dimostrati particolarmente efficienti ed economici, Nvidia ha mostrato nuovi dati sul suo server IA più avanzato, progettato per spingere ancora più in alto l’efficienza degli LLM attuali.

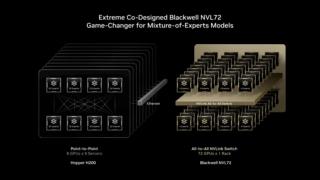

Il sistema GB200 NVL72, presentato con una serie di benchmark interni, dimostra che non basta addestrare bene i modelli, ma che serve anche un’infrastruttura capace di farli funzionare su larga scala. La scelta di Nvidia di concentrarsi sui modelli Mixture-of-Experts non è casuale. Questa architettura, diventata improvvisamente centrale nel dibattito tecnologico dopo l’ascesa di DeepSeek e del suo modello open source ad alte prestazioni, offre un modo elegante per ridurre i costi computazionali mantenendo risposte articolate e rapide.

L’idea di dividere una domanda in più segmenti, ciascuno affidato a un “esperto” interno al modello, ha conquistato rapidamente il settore. Non a caso, OpenAI, Mistral e Moonshot AI hanno già fatto propri questi principi, rendendo la competizione ancora più serrata.

In tale contesto, Nvidia ha voluto ribadire che i suoi chip non sono indispensabili soltanto in fase di training, ma anche nel deployment e lo ha fatto con numeri piuttosto esplicativi. Il nuovo server, che integra 72 unità di calcolo di ultima generazione in un’unica macchina, garantisce infatti un incremento di performance pari a dieci volte rispetto ai sistemi precedenti. È un salto netto, reso possibile non soltanto dalla potenza dei singoli chip, ma soprattutto dalla densità e dalla rapidità dei collegamenti interni, da sempre uno dei punti di forza dell’azienda guidata da Jensen Huang.

Il caso scelto da Nvidia per esemplificare il progresso è particolarmente significativo. Moonshot AI, considerata tra le realtà cinesi più promettenti nella corsa ai modelli aperti, ha pubblicato a luglio il modello Kimi K2 Thinking, accolto con entusiasmo dalla comunità di sviluppatori per la sua efficienza. Con il nuovo server Nvidia, il modello ha mostrato un miglioramento prestazionale di dieci volte in inferenza, replicando quanto già osservato nei sistemi basati sui modelli di DeepSeek.

La coerenza dei risultati rafforza la tesi di Nvidia secondo cui i modelli Mixture-of-Experts, anche se meno avidi di risorse durante il training, beneficiano enormemente da un’infrastruttura di calcolo pensata per farli scalare in produzione.

Dietro questo salto in avanti c’è un aspetto tecnologico spesso sottovalutato rispetto alla pura potenza del chip, ovvero la qualità del collegamento interno. Nvidia ha costruito negli anni un ecosistema di comunicazione ad alta velocità che permette ai vari componenti di scambiarsi dati in modo estremamente efficiente. In un server che ospita decine di unità di calcolo, questo elemento diventa decisivo, perché ridurre la latenza e aumentare la banda significa permettere al modello di attivare e coordinare i suoi “esperti” con maggiore fluidità. È una capacità che i competitor stanno cercando di replicare, ma che al momento rappresenta ancora un vantaggio reale per Nvidia.

La competizione, tuttavia, si sta intensificando. AMD sta lavorando a un server simile (anch’esso basato su più chip potenti) annunciato per il prossimo anno. Se Nvidia ha scelto una strategia di densità e interconnessione come elemento distintivo, AMD punta a un equilibrio tra potenza brute-force e versatilità, cercando di attirare quei provider cloud che non vogliono dipendere da un’unica architettura. A rendere il quadro ancora più dinamico ci sono anche aziende come Cerebras, che inseguono un approccio radicalmente diverso alla costruzione del silicio proponendo wafer-scale engine e soluzioni meno convenzionali.

Proprio per questo, la mossa comunicativa di Nvidia non va letta come un semplice annuncio tecnico, ma come un posizionamento strategico. L’azienda vuole dimostrare di poter dominare anche la nuova era dell’IA, quella in cui non basterà più avere il chip più potente, ma sarà fondamentale anche saper orchestrare un’intera infrastruttura per trasformare la potenza computazionale in esperienze concrete per l’utente finale.