NVIDIA e l’era Rubin: Jensen Huang ridisegna l’infrastruttura dell’intelligenza artificiale al CES 2026

Dal palco del Fontainebleau di Las Vegas, il CEO e fondatore di NVIDIA Jensen Huang ha inaugurato il CES 2026 con un messaggio che va oltre l’annuncio di nuovi prodotti e assume i contorni di una dichiarazione di principio. Secondo Huang, l’informatica sta vivendo una trasformazione strutturale che riguarda ormai l’intero tessuto tecnologico globale. L’intelligenza artificiale sta diventando il nuovo paradigma universale, destinato a sostituire un modello di calcolo tradizionale che ha assorbito investimenti per circa diecimila miliardi di dollari nell’ultimo decennio e che oggi necessita di una profonda modernizzazione.

In questo contesto si inserisce Rubin, la piattaforma IA di nuova generazione (ora entrata in piena produzione) che NVIDIA definisce come la propria prima architettura “extreme-codesigned” a sei chip. Rubin rappresenta sia il successore di Blackwell, sia un cambio di scala e di approccio con l’obiettivo di spingere l’IA verso una nuova frontiera industriale, riducendo drasticamente il costo di generazione dei token fino a circa un decimo rispetto alla piattaforma precedente. Un dato che, letto in chiave economica, rende l’adozione di modelli di grandi dimensioni molto più sostenibile per aziende e sviluppatori, spostando l’equilibrio competitivo del settore.

La scelta del nome non è casuale. Huang ha infatti voluto richiamare la figura di Vera Rubin, astronomo statunitense che ha contribuito in modo decisivo alla comprensione della materia oscura, stabilendo un parallelo simbolico tra l’esplorazione dell’universo e quella dei nuovi spazi computazionali aperti dall’IA. Non a caso, Rubin nasce con una logica “dal data center verso l’esterno”, integrando in modo nativo GPU capaci di raggiungere 50 petaflops in inferenza NVFP4, nuove CPU Vera ottimizzate per il movimento dei dati e per i carichi agentici, una nuova generazione (la sesta) di NVLink e un’infrastruttura di rete che combina Ethernet fotonico Spectrum-X, SuperNIC ConnectX-9 e DPU BlueField-4.

Secondo Huang, questa integrazione estrema è l’unica strada percorribile per scalare l’IA a livello di gigascale. Addestramento e inferenza, per diventare realmente pervasivi, devono ridurre il costo totale di possesso e migliorare l’efficienza energetica in modo sostanziale. In questa direzione va anche l’introduzione di una piattaforma di storage AI-native pensata per la gestione del contesto di inferenza. La Inference Context Memory Storage Platform agisce come un livello KV-cache dedicato, capace di aumentare significativamente il numero di token processati al secondo e di migliorare il rapporto tra prestazioni, costi e consumi. È un tassello che rafforza l’idea di un’IA progettata come infrastruttura, non come semplice software applicativo.

Su questa base hardware prende forma l’altra grande direttrice strategica di NVIDIA, ovvero il ruolo di costruttore di modelli di frontiera aperti. Huang ha ribadito più volte come l’azienda stia addestrando i propri modelli sui supercomputer interni per poi renderli disponibili all’ecosistema globale. L’idea è quella di creare una piattaforma comune di intelligenza su cui possano innestarsi aziende, industrie e persino interi Paesi. D’altronde, la frequenza con cui emergono nuovi modelli, sempre più sofisticati, sta alimentando una crescita esponenziale nelle adozioni, segno di un mercato che vede nell’apertura un acceleratore dell’innovazione.

Questo portafoglio di modelli copre ambiti molto diversi tra loro, dalla sanità alla climatologia, dalla robotica all’intelligenza incarnata, fino alla guida autonoma. NVIDIA rivendica un approccio trasparente che consente di creare, valutare, controllare e distribuire i modelli senza vincoli proprietari stringenti, in modo da rafforzare il ruolo dell’azienda come fornitore di infrastrutture e strumenti, più che come semplice vendor di soluzioni chiuse.

Un altro tema centrale dell’intervento di Huang ha riguardato la dimensione personale dell’IA, che non è più confinata nei grandi data center o nei laboratori di ricerca, ma si avvicina sempre di più alle scrivanie e agli ambienti quotidiani. La dimostrazione di un agente IA personalizzato in esecuzione locale sulla workstation DGX Spark, incarnato in un piccolo robot e basato su modelli open source, ha mostrato come concetti che fino a pochi anni fa apparivano futuristici siano oggi tecnicamente banali da implementare. L’agente diventa l’interfaccia primaria con i sistemi digitali, un paradigma che aziende come Palantir, ServiceNow e Snowflake stanno già adottando nei propri prodotti.

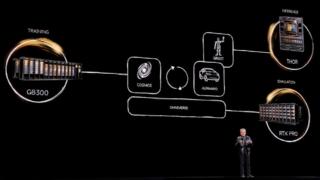

La visione di NVIDIA si estende infine al mondo fisico, dove l’IA smette di essere astratta e inizia a interagire con oggetti, ambienti e persone. Attraverso modelli di simulazione avanzata e mondi virtuali fotorealistici, i sistemi possono essere addestrati su dati sintetici prima di operare nel mondo reale. La piattaforma Cosmos incarna questa filosofia, consentendo di generare video realistici, simulare scenari complessi e prevedere traiettorie con un livello di dettaglio inedito. In questo quadro si colloca Alpamayo, una famiglia aperta di modelli di ragionamento visivo e azionale pensata per la guida autonoma di livello 4, già pronta a debuttare su veicoli di produzione come la nuova Mercedes-Benz CLA.

La stessa logica si riflette nel settore industriale e della robotica, dove NVIDIA sta costruendo un ecosistema fisico basato su simulazione, addestramento e deployment integrati. Le fabbriche del futuro, nella visione di Huang, assomiglieranno sempre più a giganteschi robot coordinati da intelligenze artificiali addestrate in ambienti virtuali e poi trasferite nel mondo reale. È un’idea che trova riscontro nelle collaborazioni con grandi player industriali come come Siemens e nei progressi mostrati nell’ambito della robotica avanzata, suggerendo come l’IA stia cambiando la natura stessa delle macchine che popolano il nostro mondo.