Nvidia e IBM lanciano nuovi LLM e agenti open source, mentre Meta sterza verso i modelli closed

Nel giro di pochi giorni, Nvidia ha presentato la famiglia di modelli IA open source Nemotron 3, IBM ha reso disponibile CUGA (un framework di agenti generalisti configurabili e open source) e Meta prepara un deciso cambio di rotta con Avocado, il successore di Llama che potrebbe abbandonare l’approccio aperto a favore di un modello chiuso e proprietario. Il risultato ai limiti del paradossale è che chi costruisce l’infrastruttura (come Nvidia) raddoppia la scommessa sull’open source, chi presidia il mondo enterprise (IBM) punta su agenti modulari e auditabili, mentre un colosso consumer come Meta decide di blindare il proprio asset più strategico.

Nemotron 3: Nvidia diventa davvero un model maker

Con Nemotron 3, Nvidia smette di essere solo il fornitore di GPU che alimenta i grandi modelli altrui e si presenta come protagonista anche sul fronte dei foundation model. La nuova famiglia di LLM open comprende tre varianti (Nano, Super e Ultra) pensate esplicitamente per applicazioni agentiche, cioè per sistemi multi-agente che collaborano tra loro su compiti complessi, andando ben oltre il classico chatbot monolitico.

Nemotron 3 si affida a un’architettura ibrida “latent mixture‑of‑experts” (MoE) che permette di attivare solo una frazione dei parametri a ogni token, riducendo drasticamente il costo di inferenza a parità di capacità. Il modello Nano, pur avendo 30 miliardi di parametri, ne attiva fino a circa 3 miliardi per token, ottenendo secondo Nvidia fino a 4 volte il throughput di Nemotron 2 Nano e il massimo numero di token al secondo in scenari multi‑agente su larga scala. Le versioni Super (nell’ordine delle decine di miliardi di parametri) e Ultra (nell’ordine delle centinaia di miliardi) sono orientate a compiti di ragionamento avanzato e a deployment su cluster multi‑GPU di fascia alta, con rilascio previsto nella prima metà del 2026.

Dal punto di vista di chi sviluppa, l’elemento cruciale non è solo la potenza del modello, ma il fatto che Nemotron 3 arrivi come componente di uno stack open. Pesi, dati di training documentati e librerie sono infatti pensati per essere analizzati, controllati e adattati da aziende e pubbliche amministrazioni che non possono permettersi la “scatola nera” dei modelli chiusi.

Nvidia, che resta il fornitore di riferimento per OpenAI, Google e gli altri campioni del closed source, usa l’open come leva competitiva anche contro la crescente ondata di modelli aperti cinesi come quelli di DeepSeek, Moonshot AI e Qwen. In questo modo, il colosso USA sottrarre spazio ai competitor asiatici nel mondo open e, al tempo stesso, rafforzare il lock‑in sulla propria infrastruttura hardware.

CUGA di IBM: gli agenti enterprise diventano un framework

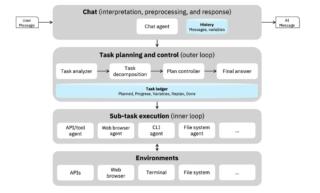

Se Nvidia lavora sul layer del modello, IBM interviene su quello dell’orchestrazione degli agenti. CUGA (acronimo di Configurable Generalist Agent) è un framework di agenti generalisti pensato per scenari enterprise, capace di gestire task lunghi e multi-step che coinvolgono sia servizi web sia API complesse. Invece di chiedere agli sviluppatori di scrivere prompt complicati e architetture ad hoc per ogni progetto, IBM propone una struttura modulare in cui l’azienda definisce strumenti, policy, SOP e guardrail, mentre il framework gestisce pianificazione, esecuzione e coordinamento.

Architettonicamente, CUGA ruota attorno a un Plan Controller Agent che prende l’intento dell’utente, lo scompone in sottocompiti strutturati e li traccia in un “task ledger” dinamico, capace di ripianificare quando qualcosa va storto. I sottocompiti vengono affidati a agent specializzati, come un browser agent per interagire con interfacce UI, e sono supportati da memoria a breve termine, meccanismi di riflessione e gestione di variabili. Questa stratificazione, insieme a un registry di tool che va oltre il solo protocollo MCP, consente a CUGA di orchestrare in modo fine un parco strumenti eterogeneo, mantenendo coerenza con le policy aziendali e permettendo audit accurati a posteriori.

Il dettaglio strategicamente più rilevante è però la licenza. CUGA è infatti rilasciato come open source, con una licenza di tipo Apache 2.0 che consente utilizzo, modifica e deployment in produzione senza barriere restrittive. In un contesto in cui molte aziende temono il lock‑in dei vendor di LLM chiusi, la possibilità di costruire agenti complessi sopra modelli open (Nemotron 3 compreso) usando un framework aperto e orientato alla compliance rappresenta una proposta molto convincente per chi gestisce ambienti regolati o fortemente sensibili a sicurezza e tracciabilità.

Meta Avocado: dal mito dell’open a un closed sempre più spinto

Mentre Nvidia e IBM spingono sul fronte open, Meta si trova in una fase di ripensamento profondo della propria strategia AI. Dopo aver costruito per anni il proprio posizionamento sull’idea di “democratizzare” l’AI con la serie di modelli IA Llama, il gruppo guidato da Mark Zuckerberg sta lavorando a un successore (nome in codice Avocado) che, secondo fonti interne, potrebbe essere rilasciato come modello proprietario, con pesi non accessibili liberamente agli sviluppatori esterni. Il lancio, inizialmente atteso entro la fine del 2025, è ora spostato al primo trimestre 2026, mentre il team testa e ritocca le prestazioni di training per evitare il bis di un rollout affrettato come quello di Llama 4.

Dietro questa sterzata ci sono elementi tanto tecnici quanto politici. Alcuni dei top researcher e degli ingegneri confluiti nella nuova Meta Superintelligence Labs (MSL), diretta dal fondatore di Scale AI Alexandr Wang, hanno espresso riserve sull’open‑source aggressivo della generazione Llama, sottolineando sia i rischi di sicurezza, sia il fatto che competitor come DeepSeek avrebbero sfruttato elementi di architettura senza particolari freni. Il flop relativo di Llama 4, accompagnato da critiche sulle capacità e da tensioni interne, ha portato Zuckerberg a ridisegnare l’organigramma, spostando il chief product officer Chris Cox fuori dall’unità AI e affidando a Wang il compito di costruire una linea di modelli di fascia altissima, con Avocado come punta di diamante.

La scelta di chiudere il modello ha diverse conseguenze. Sul piano competitivo, Meta mira a giocare nella stessa lega di OpenAI, Google (con Gemini 3) e Anthropic, che negli ultimi mesi hanno lanciato nuove versioni accolte positivamente dal mercato e dagli sviluppatori enterprise. In questo scenario, continuare a regalare un vantaggio strutturale tramite open source viene percepito internamente come un lusso che Meta non può più permettersi, soprattutto dopo aver investito 14,3 miliardi di dollari per portare in casa Wang e il suo team, alzando contestualmente la guidance di capex 2025 fino a 70‑72 miliardi.

Al tempo stesso, la virata verso il closed si accompagna a una ristrutturazione più ampia. Meno risorse sul metaverso e sulla realtà virtuale, più focus sugli occhiali smart con AI integrata e sulle infrastrutture per addestrare e servire modelli di nuova generazione, anche appoggiandosi a provider cloud esterni come CoreWeave e Oracle. È un tentativo di trasformare una narrativa di “strategia confusa” in una roadmap chiara e monetizzabile, in cui Avocado è destinato a diventare l’asset che deve riportare Meta in prima fila nel confronto diretto con i tre grandi rivali dell’IA generativa.

(Immagine in apertura: Shutterstock)