La CEO di AMD apre i keynote del CES e annuncia nuovi Ryzen AI, GPU MI455X e workstation per AI

Al CES 2026 di Las Vegas in svolgimento in questi giorni, AMD ha messo in scena un nuovo e importante tassello della sua strategia IA articolandolo in tre direzioni: SoC Ryzen AI 400, il debutto della GPU Instinct MI455X come punta di diamante della nuova famiglia MI400 e la presentazione delle prime workstation e piattaforme “chiavi in mano” per sviluppatori e carichi IA avanzati.

Ryzen AI 400: il PC come nodo IA

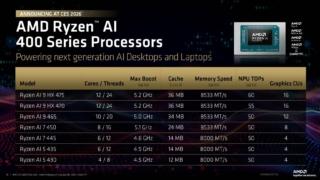

La serie Ryzen AI 400 nasce come evoluzione della precedente generazione, mantenendo l’architettura CPU Zen 5 ma aggiornando profondamente il blocco NPU XDNA 2 e la parte grafica integrata, che ora si appoggia a Radeon RDNA 3.5 (o declinazioni intermedie della famiglia RDNA) per garantire un bilanciamento credibile tra produttività accelerata e gaming mainstream. Il versante su cui AMD ha insistito con più forza è l’abilitazione dei Copilot+ PC, con i Ryzen AI 400 visti come la piattaforma di riferimento per questo segmento grazie a prestazioni IA in locale fino a 60 TOPS sulla sola NPU, a cui si somma il contributo di CPU e GPU.

Sul piano delle specifiche, la nuova gamma di SoC arriva fino a 12 core e 24 thread Zen 5, con frequenze boost nell’ordine dei 5,2 GHz e una GPU integrata con 16 Compute Unit RDNA 3.5 che possono spingersi intorno ai 3,1 GHz, affiancate da memoria DDR5 con supporto fino a 8.533 MT/s sui modelli di fascia alta. Al di là del puro dato numerico, AMD dichiara un miglioramento complessivo del 25% circa della NPU rispetto alla generazione precedente, proponendo la famiglia Ryzen AI 400 come soluzione da 1,3 a 1,7 volte più rapida dei competitor in multitasking e content creation.

L’aspetto forse più interessante, al netto del puro throughput di TOPS, è il posizionamento. AMD punta infatti a di trasformare ogni PC equipaggiato con Ryzen AI 400 in un nodo IA autonomo, potenzialmente in grado di eseguire agenti, modelli linguistici compatti e strumenti di editing “AI-first” senza dipendere costantemente dalla connessione al cloud.

La narrativa “AI per tutti, ovunque” trova così una traduzione concreta sia sui notebook, sia sui desktop e, almeno nelle intenzioni, va a colmare il gap con le proposte di Intel e Qualcomm nel segmento Copilot+, posizionandosi sopra Panther Lake quanto a capacità NPU ma ancora dietro ai picchi assoluti di TOPS dei SoC ARM di fascia alta.

GPU a tutta IA con la Instinct MI455X

Sul fronte data center, la seconda grande novità è la Instinct MI455X, GPU di punta della nuova serie MI400 costruita con chiplet di calcolo prodotti sul nodo TSMC N2 e pensata per abilitare un salto generazionale molto netto nelle prestazioni di addestramento e inferenza IA rispetto alle attuali MI300 e MI350. AMD segmenta la gamma MI400 in più varianti, con la MI430X orientata anche ad HPC tradizionale grazie al pieno supporto FP32 e FP64 e i modelli MI440X e MI455X ottimizzati per la bassa precisione (FP4, FP8, BF16), in linea con le esigenze dei workload di deep learning di ultima generazione.

La MI455X in particolare combina architettura CDNA 5, packaging 3D avanzato e memoria HBM4 ad altissima banda e viene integrata nel sistema Helios in configurazioni fino a 72 acceleratori per rack, per un totale di 31 TB di HBM4 e una bandwidth aggregata di circa 1,4 PB/s. In termini prestazionali, AMD parla di oltre 2,9 exaFLOPS in FP4 per inferenza e circa 1,4 exaFLOPS in FP8 per training in un singolo rack Helios basato su MI455X, descrivendo questo passo come uno dei maggiori incrementi generazionali nella storia dei propri acceleratori.

L’approccio architetturale è chiaramente orientato a ridurre ridondanze e a migliorare l’efficienza per watt. Ottimizzando ogni SKU MI400 sul proprio “envelope di precisione”, AMD elimina infatti unità poco sfruttate e ottimizza area e consumi, cercando di rendere più competitivo il TCO rispetto all’offerta di Nvidia, a cui Helios si contrappone direttamente come alternativa ai sistemi NVL72.

Il posizionamento è esplicitamente pensato per grandi operatori cloud e per realtà che puntano a cluster multi-rack, con scalabilità verso il cosiddetto “YottaScale” tramite interconnessioni basate su standard Ethernet ad alta velocità, così da presentare gruppi di migliaia di GPU come un’unica risorsa logica per i carichi di addestramento più complessi.

Workstation e piattaforme per IA

La terza gamba della strategia di AMD svelata al CES 2026 è rappresentata dalle nuove workstation e piattaforme per IA, presentate come punto di contatto tra il mondo PC e l’infrastruttura datacenter e, in particolare, per sviluppatori, ricercatori e aziende che vogliono lavorare a modelli proprietari o a pipeline complesse mantenendo il controllo sui dati. Su questo fronte rientra anche la nuova Ryzen AI Halo developer platform, una sorta di desktop compatto basato su CPU Ryzen AI di fascia alta e GPU dedicate e progettato per consentire sviluppo e test di modelli localmente, sfruttando ROCm e l’ecosistema software AMD senza la latenza e i vincoli del cloud pubblico.

Parallelamente, AMD mostra le prime declinazioni di workstation professionali costruite attorno agli acceleratori Instinct e alle CPU EPYC di generazione Venice, che fungono da base sia per configurazioni stand-alone, sia per nodi che possono essere integrati in cluster Helios più ampi. AMD vuole proporre soluzioni scalabili lungo un continuum che va dal desktop per sviluppatori ai rack a densità estrema, mantenendo un denominatore comune fatto di supporto alle stesse librerie, agli stessi framework AI e agli stessi driver ROCm, così da ridurre l’attrito nel passaggio dal prototipo alla produzione.