Kimi K2 Thinking è il nuovo LLM cinese che sbaraglia la concorrenza, per prestazioni e costi

Quando un modello IA open-source compete ad armi pari con GPT-5 e Claude Sonnet 4.5 e spesso riesce persino a superarli supera, è la fotografia (non del tutto nuova a essere precisi) di uno spostamento strategico nell’ecosistema dell’intelligenza artificiale.

Kimi K2 Thinking, presentato nei giorni scorsi dall’azienda cinese Moonshot AI, è un LLM che si propone come un “thinking agent” capace di mantenere coerenza su sequenze lunghe di ragionamento e chiamate a strumenti, sfruttando una combinazione di architettura Mixture-of-Experts (MoE) su scala molto ampia (circa un trilione di parametri totali) e tecniche di quantizzazione per efficienza per orchestrare centinaia di passaggi sequenziali senza un degrado significativo delle prestazioni.

La caratteristica fondamentale di questo modello IA e che ne decreta l’efficienza operativa è il fatto che soltanto 32 miliardi di parametri vengono attivati per ogni token elaborato. Questa configurazione sparsa, che impiega 384 esperti di cui solo 8 vengono selezionati per token, permette di ottenere prestazioni da modello di frontiera mantenendo costi computazionali contenuti.

L’aspetto più innovativo risiede nella quantizzazione nativa INT4 implementata attraverso il Quantization-Aware Training (QAT) durante la fase di post-addestramento. Questa tecnica consente di raddoppiare la velocità di inferenza rispetto alle versioni precedenti in FP8, riducendo drasticamente l’utilizzo di memoria GPU senza perdite apprezzabili di precisione, mentre l’attenzione viene mantenuta in BF16 dove la precisione risulta critica.

Con una finestra di contesto di 256.000 token, Kimi K2 Thinking si posiziona come uno strumento progettato specificamente per gestire workflow complessi e documenti estesi, una necessità sempre più pressante nell’ambito delle applicazioni aziendali.

Il ragionamento profondo come paradigma operativo

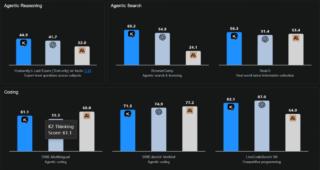

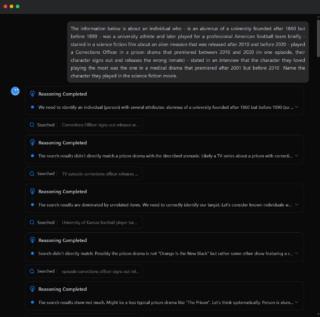

Ciò che distingue Kimi K2 Thinking dai modelli conversazionali tradizionali è la sua capacità di intrecciare ragionamento esplicito con l’utilizzo dinamico di strumenti esterni. Il modello è stato addestrato per generare tracce di ragionamento multi-stadio, scomponendo problemi vaghi e aperti in passaggi concreti e risolvibili, una competenza che persino i chatbot più avanzati faticano ancora a padroneggiare. Questa caratteristica si riflette nei risultati ottenuti sull’Humanity’s Last Exam (HLE), un benchmark progettato per valutare capacità analitiche di livello esperto dove Kimi K2 Thinking ha raggiunto il 44,9% di accuratezza contro il 41,7% di GPT-5 e il 32% di Claude Sonnet 4.5.

Il modello può eseguire autonomamente tra 200 e 300 chiamate consecutive a strumenti esterni senza intervento umano, mantenendo stabilità e coerenza dove modelli precedenti iniziavano a degradare dopo 30-50 passaggi. Una persistenza nel ragionamento che si traduce in una capacità di portare avanti ricerche autonome, sessioni di coding complesse e workflow di scrittura che si estendono per centinaia di azioni sequenziali. Kimi K2 Thinking mantiene inoltre uno stato di ragionamento leggero attraverso i vari step di una sessione, ricordando vincoli, toni e istruzioni definite in precedenza senza necessità di re-prompting continuo.

L’economia dell’intelligenza artificiale

Il contesto economico in cui si inserisce Kimi K2 Thinking rappresenta forse l’aspetto più dirompente dell’intera operazione. Secondo fonti vicine al progetto, il costo di addestramento del modello si è attestato a 4,6 milioni di dollari, una cifra che impallidisce di fronte ai miliardi investiti da OpenAI per i suoi modelli di punta. Questa efficienza economica non è un caso isolato considerando che DeepSeek ha dichiarato di aver speso 5,6 milioni per il suo LLM V3, a dimostrazione di come le aziende cinesi (mettiamoci anche Alibaba) stiano sviluppando metodologie di training più efficienti nonostante le restrizioni statunitensi sull’accesso ai chip avanzati.

La decisione di rilasciare Kimi K2 Thinking come modello open source attraverso piattaforme come Hugging Face rappresenta inoltre una chiara dichiarazione di intenti in un settore dominato da sistemi proprietari e paywall. Diverse aziende statunitensi di primo piano, tra cui Airbnb, hanno iniziato a evidenziare la competitività di alcuni modelli IA cinesi, posizionandoli come alternative efficaci e più economiche rispetto a ChatGPT. I benchmark confermano questa tendenza visto che Kimi K2 Thinking ha stabilito nuovi record open source non solo su HLE, ma anche su BrowseComp, SWE-Multilingual e LiveCodeBench, superando in diverse metriche GPT-5 e Claude Sonnet 4.5.

(Immagine in apertura: Shutterstock)