Intel Innovation 2023: gli sviluppatori potranno portare l’IA ovunque

L’evento Intel Innovation 2023, di cui abbiamo già parlato ieri in occasione dell’annuncio dei nuovi processori Meteor Lake, vede come topic principale l’intelligenza artificiale, che negli annunci di Intel ha fatto davvero la parte del leone.

Nel keynote rivolto agli sviluppatori all’apertura dell’evento, il CEO di Intel, Pat Gelsinger, ha infatti mostrato come l’azienda stia portando le funzionalità di intelligenza artificiale nei suoi prodotti hardware e le stia rendendo accessibili attraverso soluzioni software aperte e multi-architettura. Ha anche sottolineato come l’IA stia contribuendo a promuovere la cosiddetta “siliconomy, una fase di sviluppo economico resa possibile dalla magia del silicio e del software”. Oggi il silicio alimenta un’industria da 574 miliardi di dollari che a sua volta alimenta un’economia tecnologica globale che vale quasi 8.000 miliardi di dollari.

Oltre ai Meteor Lake, Intel ha presentato in anteprima i processori Intel Xeon di quinta generazione, che offriranno un mix di miglioramenti prestazionali e memoria più veloce utilizzando la stessa quantità di energia. Grazie all’efficienza degli E-core, la nuova generazione Xeon (Sierra Forest) offrirà una densità di rack 2,5 volte superiore e prestazioni per Watt 2,4 volte più elevate rispetto allo Xeon di quarta generazione e includerà una versione con 288 core. Granite Rapids, che seguirà in tempi brevi il lancio di Sierra Forest, offrirà inoltre prestazioni in ambito IA da 2 a 3 volte superiori rispetto agli Xeon di quarta generazione.

“L’intelligenza artificiale trasformerà, rimodellerà e ristrutturerà radicalmente l’esperienza del PC, liberando la produttività e la creatività personale attraverso la potenza del cloud e del PC che lavorano insieme”, ha continuato Gelsinger nel discorso di apertura dell’evento. “Stiamo inaugurando una nuova era dell’intelligenza artificiale nei PC.”

In tale ottica, per aiutare gli sviluppatori a sbloccare questo futuro segnato dall’IA, Intel ha annunciato:

- Disponibilità generale della Intel Developer Cloud: Intel Developer Cloud aiuta gli sviluppatori ad accelerare l’intelligenza artificiale utilizzando le ultime innovazioni hardware e software Intel, inclusi i processori Intel Gaudi2 per il deep learning, e fornisce l’accesso alle più recenti piattaforme hardware Intel, come i processori scalabili Intel Xeon di quinta generazione e Intel Data Center GPU Max serie 1100 e 1550. Utilizzando Intel Developer Cloud, gli sviluppatori possono creare, testare e ottimizzare applicazioni AI e HPC. Possono anche eseguire corsi di formazione sull’intelligenza artificiale su piccola e larga scala, ottimizzazione dei modelli e carichi di lavoro di inferenza che vengono distribuiti con prestazioni ed efficienza. Intel Developer Cloud si basa su una base software aperta con oneAPI, un modello di programmazione multivendor e multiarchitettura aperta, per offrire scelta di hardware e libertà dai modelli di programmazione proprietari per supportare l’elaborazione accelerata, il riutilizzo e la portabilità del codice.

- Il lancio del toolkit OpenVINO nel 2023: OpenVINO è il runtime di inferenza e distribuzione IA preferito dagli sviluppatori su piattaforme client ed edge. La versione include modelli preaddestrati ottimizzati per l’integrazione tra sistemi operativi e diverse soluzioni cloud, inclusi molti modelli di intelligenza artificiale generativa, come il modello Llama 2 di Meta. A Intel Innovation, aziende tra cui ai.io e Fit:match hanno dimostrato l’utilizzo che fanno di OpenVINO per accelerare le loro applicazioni: ai.io per analizzare le prestazioni di qualsiasi atleta e Fit:match per rivoluzionare i settori del retail e del wellness aiutando i consumatori a trovare i capi più adatti.

- Project Strata e lo sviluppo di una piattaforma edge native: La piattaforma sarà lanciata nel 2024 con elementi costitutivi modulari, servizi premium e offerte supplementari. Si tratta di un approccio orizzontale per scalare l’infrastruttura necessaria per l’Intelligent Edge e l’intelligenza artificiale ibrida, e riunirà un ecosistema di applicazioni verticali Intel e di terze parti. La soluzione consentirà agli sviluppatori di creare, distribuire, eseguire, gestire, connettere e proteggere infrastrutture e applicazioni edge distribuite.

Continuando con gli annunci, durante la seconda giornata di Intel Innovation 2023 Greg Lavender, Chief Technology Officer di Intel, ha offerto uno sguardo dettagliato su come la filosofia dell’ecosistema aperto e orientato agli sviluppatori di Intel stia lavorando per garantire che le opportunità dell’intelligenza artificiale siano accessibili a tutti. “La comunità degli sviluppatori è il catalizzatore che aiuta le industrie a sfruttare l’IA per soddisfare le loro diverse esigenze, sia oggi che in futuro”, ha dichiarato Lavender. “L’IA può e deve essere accessibile a tutti per essere utilizzata in modo responsabile. Se gli sviluppatori sono limitati nella scelta dell’hardware e del software, la gamma di casi d’uso per l’adozione dell’IA su scala globale sarà limitata e probabilmente limiterà il valore sociale che è in grado di fornire”.

Lavender ha poi sottolineato l’impegno di Intel per la sicurezza end-to-end, tra cui l’Intel Transparent Supply Chain per la verifica dell’integrità di hardware e firmware e la garanzia di un’elaborazione riservata per proteggere i dati sensibili in memoria. Oggi Intel sta ampliando la sicurezza della piattaforma e la protezione dell’integrità dei dati con diversi nuovi strumenti e servizi, tra cui la disponibilità generale di un nuovo servizio di attestazione.

Questo servizio è il primo di un nuovo portafoglio di software e servizi di sicurezza chiamato Intel Trust Authority. Offre una valutazione unificata e indipendente dell’integrità dell’ambiente di esecuzione fidato, dell’applicazione dei criteri e dei registri di audit e può essere utilizzato ovunque venga distribuito il computing riservato di Intel, compresi i sistemi multi-cloud, ibridi, on-premises e edge. Intel Trust Authority diventerà anche una funzionalità integrale per abilitare l’IA confidenziale, contribuendo a garantire l’affidabilità degli ambienti informatici riservati in cui vengono elaborati dati e proprietà intellettuale (IP) sensibili in applicazioni di machine learning, in particolare l’inferencing sulle generazioni attuali e future di processori Intel Xeon.

Un ecosistema aperto facilita la scelta con prestazioni ottimizzate

Le organizzazioni di tutto il mondo utilizzano l’IA per accelerare le scoperte scientifiche, trasformare le aziende e migliorare i servizi ai consumatori. Tuttavia, l’applicazione pratica delle soluzioni di IA è limitata da sfide difficili da superare per le aziende, dalla mancanza di competenze interne e risorse insufficienti per gestire correttamente la pipeline di IA (compresa la preparazione dei dati e la modellazione) fino a piattaforme proprietarie costose e lunghe da mantenere in modo continuativo.

Intel si impegna a promuovere un ecosistema aperto che consenta una facile implementazione su più architetture. Questo include l’essere un membro fondatore della Unified Acceleration Foundation (UXL) della Linux Foundation. Questo gruppo intersettoriale si impegna a fornire un ecosistema di software di accelerazione aperto per semplificare lo sviluppo di applicazioni per la distribuzione multipiattaforma. UXL è un’evoluzione del modello di programmazione oneAPI, che consente di scrivere il codice una sola volta e di distribuirlo su diverse architetture di elaborazione, tra cui CPU, GPU, FPGA e acceleratori.

Intel, che contribuirà con le sue specifiche oneAPI alla UXL Foundation per favorire lo sviluppo multipiattaforma su tutte le architetture, sta inoltre collaborando con Red Hat, Canonical e SUSE per fornire distribuzioni ottimizzate per Intel delle loro versioni di software aziendali, al fine di garantire prestazioni ottimizzate per le ultime architetture Intel. Lavender è stato raggiunto sul palco da Gunnar Hellekson, vicepresidente e direttore generale del settore Red Hat Enterprise Linux, per annunciare una collaborazione ampliata che vedrà Intel contribuire al supporto upstream dell’ecosistema Red Hat Enterprise Linux (RHEL) utilizzando CentOS Stream. Intel continua inoltre a contribuire a strumenti e framework di AI e machine-learning, tra cui PyTorch e TensorFlow.

Per aiutare gli sviluppatori a scalare le prestazioni in modo semplice e veloce, Intel Granulate sta aggiungendo Auto Pilot per il ridimensionamento delle risorse dei pod Kubernetes. Questo strumento offrirà raccomandazioni automatiche e continue per la gestione della capacità agli utenti di Kubernetes. Ciò consentirà loro di ridurre gli investimenti necessari per soddisfare le metriche di costo-prestazione degli ambienti containerizzati. Intel Granulate sta inoltre aggiungendo funzionalità di orchestrazione autonoma per i carichi di lavoro Databricks, che consentiranno una riduzione media dei costi del 30% e dei tempi di elaborazione del 23% senza modifiche al codice.

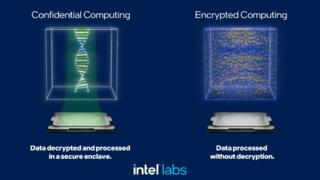

Infine, poiché il mondo si affida sempre di più all’IA per risolvere problemi grandi e complessi e ottenere risultati di business reali, cresce l’esigenza di proteggere i modelli di IA, i dati e le piattaforme su cui vengono eseguiti da manomissioni, manipolazioni e furti. La crittografia completamente omomorfa (FHE) consente di eseguire calcoli direttamente sui dati crittografati, anche se le implementazioni pratiche sono limitate dalla complessità computazionale e dall’overhead.

Intel ha dichiarato di avere in programma lo sviluppo di un acceleratore ASIC (application-specific integrated circuit) per ridurre il sovraccarico di prestazioni di milioni di volte associato a un approccio FHE solo software. Inoltre, l’azienda lancerà la versione beta di un toolkit software per il calcolo criptato che consentirà a ricercatori, sviluppatori e comunità di utenti di imparare e sperimentare la codifica FHE. Questo kit sarà disponibile entro la fine dell’anno nell’ambito di Intel Developer Cloud, la cui disponibilità generale è stata annunciata ieri, e includerà una serie di interfacce interoperabili per lo sviluppo di software FHE, strumenti di traduzione e un simulatore campione del suo acceleratore hardware.