Il trucco con cui ChatGPT è tornato in Italia

Indice dell'articolo

Da venerdì ChatGPT di OpenAI ha riaperto il servizio per gli utenti sul territorio italiano, dopo lo stop autoimposto per ottemperare alle richieste fatto dal nostro Garante Privacy. Ma come ha fatto a soddisfare quei requisiti, visto che la richiesta di rettifica delle informazioni personali generate dal modello IA o la cancellazione dei dati non sono tecnicamente possibili per un modello linguistico, che funziona in modo molto diverso da un database di informazioni?

Riassumendo il nocciolo del problema, i modelli linguistici come ChatGPT (LLM) non memorizzano né comprendono le informazioni che acquisiscono durante la fase di addestramento, che avviene con enormi quantità di testi recuperati da Internet, ma creano un modello che permette di calcolare la probabilità con cui una parola o sua porzione (un token) viene dopo quella precedente nel contesto del discorso che sta facendo. Ogni parola vive di vita propria, ed è per questo che non si può dire che un LLM archivi informazioni.

Ebbene, da quanto si capisce leggendo la nuova informativa privacy di ChatGPT, sembra che l’azienda abbia trovato un escamotage per produrre lo stesso effetto, senza però modificare il modo in cui i dati personali vengono acquisiti e trattati dall’algoritmo.

Ecco i punti salienti dell’informativa, tradotti dall’inglese:

“Se noti che l’output di ChatGPT contiene informazioni personali inaccurate, puoi inviare una richiesta di correzione a dsar@openai.com. Data la complessità tecnica del funzionamento dei nostri modelli, potremmo non essere in grado di correggere l’inaccuratezza. In questo caso, puoi richiederci di rimuovere le tue informazioni personali dall’output di ChatGPT compilando questo modulo”.

La parte rilevante della frase a cui prestare attenzione è che le informazioni personali non vengono rimosse dal modello, ma solo dall’output di ChatGPT, cioè la risposta che viene data all’utente. Apparentemente è stato implementato un filtro che intercetta le risposte contenenti informazioni personali delle persone che hanno richiesto la loro rimozione, e ne impedisce la visualizzazione all’utente.

Se la soluzione funziona agli effetti pratici (ChatGPT non mostra le informazioni sbagliate), l’elaborazione dei dati personali viene comunque fatta, e non viene toccato uno degli aspetti critici delle IA: la liceità dell’acquisizione di contenuti di addestramento che sono sì pubblici (almeno fino a prova contraria), ma che sono stati pubblicati quando non era ipotizzabile un utilizzo di questo tipo.

Si tratta comunque di un precedente importante per tutte le aziende che intendono muoversi nel campo dell’intelligenza artificiale ma sono frenate dal timore di muoversi in un terreno giuridico dai confini ancora poco definiti, almeno fino all’approvazione dell’AI Act dell’Unione europea, sul quale la settimana scorsa è stato raggiunto l’accordo per un emendamento riguardante proprio le IA generative.

Come richiedere a ChatGPT di rimuoverci dalle risposte

Il modulo a cui si accenna nell’informativa è piuttosto complesso e richiede di produrre una serie di informazioni per dimostrare l’identità della persona che fa la richiesta o di un suo legale rappresentante, di chiarire le leggi applicabili, dichiarare se si è una figura pubblica o meno e fornire esempi del prompt e della risposta incriminata.

Non è possibile quindi fare un’opposizione a priori al trattamento, ma solo quando si è ricevuta un’informazione errata.

Il tutto si conclude con una “dichiarazione giurata” sulla veridicità delle informazioni fornite, con tanto di data della firma, ma priva di qualsiasi forma di identificazione o firma digitale riconosciute in Europa, e per tanto di scarso valore da noi. Si capisce l’intenzione di mettere un freno al numero delle possibili richieste. Se fossero milioni i cittadini a chiedere la rimozione da ChatGPT, lo staff e le infrastrutture ne avrebbero un contraccolpo, così come la capacità di ChatGPT di potersi esprimere su molti temi diversi .

Gli altri passi avanti nella privacy di ChatGPT

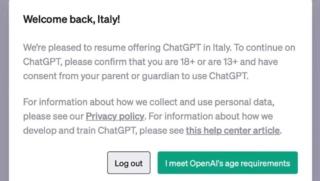

OpenAi ha anche apportato ulteriori modifiche all’informativa privacy, all’interfaccia e alle funzionalità. Oltre alla possibilità di attivare una modalità incognito, che non memorizza le chat e ne impedisce l’utilizzo come dati per l’addestramento dei modelli, ha chiarito le motivazioni giuridiche dei diversi tipi di trattamento di dati personali che effettua, fornito più informazioni sull’esercizio dei diritti degli interessati e posto un divieto di registrazione per i minori di 13 anni (è sufficiente dichiarare di non esserlo, ma siti ben più pericolosi si basano su un meccanismo simile o non ne hanno alcuno).

Basterà questa semplice riga a far passare il concetto che i modelli linguistici devono essere considerati delle “macchine per produrre testi”, e non “macchine per dare risposte”?

(Credit immagine di apertura: Ascannio / Shutterstock.com)