Il MIT censisce e valuta gli Agenti AI in circolazione: rischi e tendenze emergenti

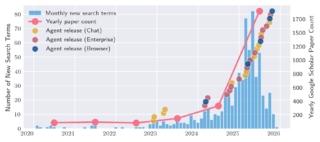

Il 2025 ha segnato il passaggio definitivo dall’IA generativa puramente consultiva a quella agentica. Gli agenti AI infatti non si limitano più a rispondere a domande, ma agiscono nel mondo digitale navigando sul web, utilizzando software aziendali, scrivendo codice e gestendo flussi di lavoro complessi.

Questo massiccio salto tecnologico sta avvenendo però in un vuoto normativo e tecnico che i ricercatori del Computer Science & Artificial Intelligence Laboratory (CSAIL) del MIT definiscono preoccupante. All’interno del loro AI Agent Index 2025, un’analisi approfondita sui 30 agenti AI più rilevanti al mondo, emerge infatti un quadro di profonda opacità, dove lo sviluppo accelerato prevale sistematicamente sulla sicurezza e sulla definizione di standard comportamentali condivisi.

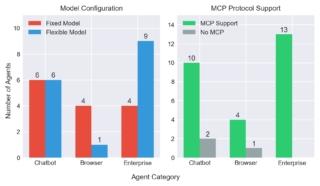

La tassonomia di questi strumenti è estremamente variegata. Troviamo applicazioni di chat dotate di strumenti operativi come ChatGPT Agent o Claude Code, agenti basati sul browser come Perplexity Comet e soluzioni integrate nei flussi aziendali come Microsoft Copilot Studio o ServiceNow Agent.

Nonostante questa pervasività, il rapporto del MIT evidenzia come le informazioni pubbliche riguardanti lo sviluppo e il dispiegamento di tali sistemi rimangano scarse, impedendo a ricercatori e decisori politici di valutarne i rischi reali. Un esempio lampante di questa deriva è l’erosione dei protocolli web storici. Molti agenti, infatti, ignorano sistematicamente il Robot Exclusion Protocol (robots.txt), il meccanismo con cui i siti web segnalano il mancato consenso al passaggio di bot e scraper. Questo comportamento suggerisce che le infrastrutture di protezione della vecchia rete siano ormai inadeguate di fronte alla forza d’urto dell’intelligenza artificiale autonoma.

Le implicazioni economiche e strategiche alimentano questa fretta produttiva. McKinsey stima che gli agenti AI potrebbero iniettare fino a 2.900 miliardi di dollari nell’economia statunitense entro il 2030, ma a fronte di investimenti miliardari da parte di colossi come OpenAI e Anthropic, il ritorno sull’investimento per le imprese rimane ancora incerto.

Solo un anno fa, gli agenti faticavano a completare più di un terzo dei compiti d’ufficio multi-step e sebbene le capacità siano migliorate drasticamente con l’arrivo di modelli sempre più sofisticati, la sicurezza non ha seguito la stessa curva di crescita. Dei 30 agenti analizzati dal MIT, ben 25 non forniscono infatti alcun dettaglio sui test di sicurezza effettuati e 23 non presentano dati verificati da terze parti.

Il problema della trasparenza è aggravato da una complessa struttura di dipendenze tecnologiche. Molti agenti sul mercato non sono entità isolate, ma “wrapper” costruiti attorno a una manciata di modelli di base (foundation models) sviluppati da Anthropic, Google e OpenAI. Questa stratificazione crea una catena di responsabilità frammentata per la quale, quando un agente commette un errore o viola una norma di sicurezza, diventa difficile stabilire se la colpa risieda nel modello sottostante, nello strato di orchestrazione o nel software di interfaccia.

Un’architettura “a cipolla” che rende la valutazione del rischio un esercizio estremamente complesso per i ricercatori, dal momento che nessuna singola entità detiene il controllo o la visibilità sull’intero processo operativo.

Importante anche la distribuzione geografica e aziendale degli agenti AI, che riflette inoltre tensioni geopolitiche e standard etici divergenti. Tredici dei sistemi analizzati provengono da società registrate nel Delaware, mentre cinque hanno origine in Cina. Tra questi ultimi, solo uno ha pubblicato un framework di sicurezza e uno standard di conformità.

Per gli agenti occidentali, la situazione appare leggermente migliore sulla carta, con quindici di essi che citano protocolli come la Responsible Scaling Policy di Anthropic o il Preparedness Framework di OpenAI. Tuttavia, la realtà dei fatti mostra che, tra i tredici agenti che esibiscono livelli di autonomia “di frontiera”, solo quattro hanno reso pubblici i risultati delle loro valutazioni di sicurezza. Si tratta di nomi di spicco come ChatGPT Agent, OpenAI Codex, Claude Code e Gemini 2.5 Computer Use (gli altri rimangono vere e proprie scatole nere operative).

La natura chiusa del settore è un altro punto critico sollevato dal MIT. 23 agenti analizzati sono a codice chiuso (closed-source), limitando ulteriormente la capacità della comunità scientifica di analizzarne i processi decisionali. Solo sette sviluppatori hanno scelto la via dell’open-source per i loro framework, tra cui figurano realtà come Alibaba con MobileAgent, ByteDance con Agent TARS e la stessa Google con Gemini CLI. Questa predominanza del software proprietario, unita alla concentrazione del mercato nelle mani di pochissimi attori, solleva dubbi sulla futura interoperabilità e sulla possibilità di stabilire regole comuni per il comportamento degli agenti online.

(Immagine in apertura: Shutterstock)