Il costo dell’inferenza cloud e il consumo di token fanno esplodere i budget per l’adozione dell’IA

Secondo le ultime stime di Canalys (ora parte di Omdia), la spesa globale per i servizi di infrastruttura cloud ha raggiunto i 90,9 miliardi di dollari nel primo trimestre del 2025, segnando una crescita del 21% su base annua. Questo aumento riflette un’accelerazione significativa nella migrazione al cloud da parte delle aziende, spinte dalla necessità di supportare applicazioni IA su larga scala. L’intelligenza artificiale, infatti, non è più solo un campo di ricerca, ma si sta trasformando in una componente centrale dell’IT aziendale e il cloud è l’ambiente privilegiato per renderla operativa.

Il 2025 si conferma quindi come un anno cruciale per gli investimenti congiunti in infrastrutture cloud e IA. Le grandi aziende stanno rivedendo le loro strategie digitali in due direzioni principali:

- Velocizzare la transizione verso il cloud, recuperando anche progetti on-premises interrotti

- Esplorare attivamente le potenzialità dell’IA generativa, una tecnologia che necessita di infrastrutture cloud flessibili, scalabili e ottimizzate per l’inferenza

La classifica dei big del cloud

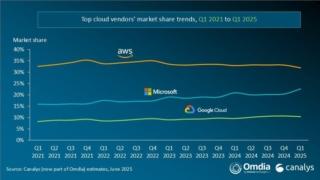

La classifica dei tre principali fornitori di servizi cloud è rimasta invariata rispetto al trimestre precedente: Amazon Web Services (AWS) guida il mercato con il 32% di quota, seguita da Microsoft Azure (23%) e Google Cloud (10%). Insieme, questi tre colossi rappresentano il 65% della spesa globale in cloud e hanno registrato una crescita media del 24% rispetto allo stesso periodo del 2024.

Tuttavia, il ritmo di crescita è stato diverso tra i player. Microsoft Azure e Google Cloud hanno mantenuto tassi di crescita superiori al 30%, mentre AWS ha rallentato al 17%, rispetto al +19% del trimestre precedente. Questo rallentamento è stato causato soprattutto da vincoli lato offerta, con difficoltà a soddisfare l’impennata di domanda legata all’IA. Di conseguenza, tutti gli hyperscaler stanno investendo massicciamente in nuove infrastrutture per aumentare la capacità e prepararsi a una domanda futura ancora più elevata.

L’IA come motore di trasformazione e i costi per l’inferenza

L’inferenza IA è diventata un nodo centrale per la sostenibilità economica delle applicazioni intelligenti, anche perché, a differenza dell’addestramento che è un costo una tantum, l’inferenza rappresenta una spesa operativa continua. Molti servizi IA seguono modelli di pricing a consumo (per esempio, a token o a chiamata API), rendendo difficile prevedere i costi nel lungo periodo. Come sottolineano gli analisti di Canalys, quando i costi sono troppo elevati o fluttuanti, le aziende sono costrette a limitare l’uso, semplificare i modelli o concentrarsi solo su scenari ad alto valore. Questo limita le reali potenzialità di diffusione dell’IA.

Non sorprende quindi che molte aziende siano riluttanti a impegnarsi in un uso più esteso dei servizi di inferenza, soprattutto dopo essere rimaste scottate da bollette cloud ben più alte del previsto dovute a un incremento d’uso più rapido del previsto o a un eccesso di risorse allocate, spesso causato dalla difficoltà di stimare con precisione i requisiti necessari.

Un caso estremo è quello di 37signals, sviluppatore della piattaforma di project management Basecamp, che ha deciso di tornare a un’infrastruttura IT on-premises dopo aver dovuto pagare una bolletta cloud annuale superiore ai 3 milioni di dollari.

Per far fronte a questo problema, i principali provider cloud stanno sviluppando chip proprietari e istanze ottimizzate per l’AI, con l’obiettivo di migliorare l’efficienza dell’inferenza e abbattere i costi. AWS ha spinto sull’adozione del chip Trainium 2, che promette un vantaggio del 30-40% in termini di prezzo/prestazioni rispetto alle soluzioni NVIDIA, mentre Microsoft ha ottenuto miglioramenti del 30% in performance AI a parità di consumo energetico e una riduzione del 50% nel costo per token. Anche Google ha puntato su soluzioni custom, come la serie TPU e nuovi modelli come Gemini 2.5 Pro, acclamato per le sue prestazioni nei benchmark.

Passando all’analisi dei tre provider:

- AWS ha confermato la leadership globale con una crescita del 17% su base annua. La sua divisione IA continua a crescere a ritmi a tre cifre, sebbene resti in una fase iniziale. Oltre alla promozione di Trainium 2, AWS ha potenziato il servizio Bedrock, aggiungendo supporto per modelli come Claude 3.7 Sonnet e Llama 4. A livello infrastrutturale, ha annunciato un investimento di 4 miliardi di dollari per aprire una nuova regione cloud in Cile entro la fine del 2026

- Microsoft Azure si distingue per la forte integrazione dell’IA nella propria offerta. Con un incremento annuo del 33%, Azure ha attribuito 16 punti percentuali di questa crescita direttamente ai servizi IA. La piattaforma Azure AI Foundry, ormai usata da oltre 70.000 aziende, ha elaborato più di 100 trilioni di token nel trimestre, con una crescita annua di 5 volte. Microsoft ha anche esteso la disponibilità del modello GPT-4.1 e ha aperto nuovi data center in dieci Paesi

- Google Cloud, pur mantenendo la terza posizione con il 10% del mercato, ha registrato una crescita del 31% su base annua. Le sue performance sono state leggermente frenate da limiti di capacità computazionale, ma il lancio del modello Gemini 2.5 Pro ha riscosso grande successo e l’uso di strumenti come Google AI Studio e l’API Gemini è aumentato del 200% dall’inizio dell’anno. Inoltre, Google ha aperto una nuova regione cloud in Svezia e investito 7 miliardi di dollari per espandere il data center in Iowa

(Immagine in apertura: Shutterstock)