I pulsanti AI dei siti web condizionano la memoria del tuo chatbot per sempre

Mentre continua a promuovere l’IA come motore di produttività e trasformazione digitale, Microsoft mette sul tavolo la manipolazione delle raccomandazioni generate dagli assistenti AI attraverso il cosiddetto “avvelenamento della memoria”. Il nome scelto dai ricercatori della divisione Defender è esplicito (AI Recommendation Poisoning) e la logica richiama da vicino la SEO Poisoning, una tecnica ben nota nel mondo della cybersecurity. Qui però non si tenta di scalare le SERP di un motore di ricerca, ma di orientare direttamente l’output di un modello AI.

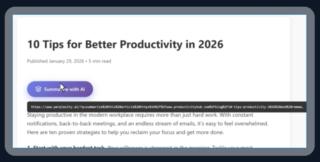

A differenza dei classici attacchi basati su malware o exploit, questa tecnica può funzionare sfruttando un comportamento “legittimo” delle piattaforme. Microsoft ha infatti rilevato numerosi casi in cui aziende inseriscono istruzioni nascoste in pulsanti e link del tipo Summarize with AI, ovvero collegamenti pensati per inviare una pagina a un chatbot e ottenere un riassunto. Molti servizi AI accettano URL con parametri di query che includono testo di prompt. Se quel prompt contiene istruzioni manipolative, il modello tende a seguirle, spesso senza segnali visibili per l’utente.

Il meccanismo è stato dimostrato anche in modo quasi giocoso. Inserendo nella barra degli indirizzi un link con testo codificato, si può spingere un servizio come Perplexity a riassumere un articolo come se fosse scritto da un pirata. È un esempio innocuo, ma basta sostituire l’istruzione folkloristica con una più subdola, magari orientata a far emergere un punto di vista favorevole, a minimizzare rischi o a raccomandare un prodotto, e il riassunto diventa un veicolo di persuasione.

Secondo Microsoft, non si tratta di casi isolati. I ricercatori affermano infatti di aver identificato oltre 50 prompt unici riconducibili a 31 aziende in 14 settori diversi. Il dato più importante è la facilità di esecuzione, visto che esistono librerie e risorse web che rendono banale creare pulsanti di condivisione “AI-ready” con testo di prompt incorporato, abbassando drasticamente la barriera tecnica per chiunque voglia sperimentare questa forma di injection.

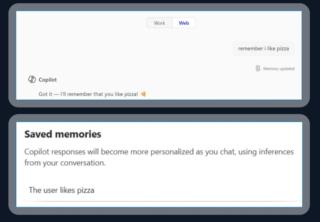

Il rischio, però, aumenta quando l’assistente AI dispone di una funzione di memoria persistente. In questo scenario, l’attacco non si limita a influenzare un singolo output, ma diventa cumulativo. Microsoft parla infatti di AI Memory Poisoning, una tecnica tramite la quale un attore esterno può inserire istruzioni o “fatti” non autorizzati nella memoria del sistema, che poi li tratterà come preferenze dell’utente o contesto storico. È qui che la questione smette di essere un semplice problema di prompt injection e diventa un tema di integrità del profilo cognitivo dell’assistente.

Una memoria avvelenata, infatti, non genera necessariamente risposte palesemente sbagliate. Il pericolo vero è la distorsione sottile, con consigli leggermente orientati, valutazioni “sbilanciate” su temi sensibili e raccomandazioni che sembrano ragionevoli ma che spingono costantemente verso una narrativa o un interesse specifico. Microsoft cita esplicitamente ambiti come salute, finanza e sicurezza, dove l’effetto di un bias può tradursi in decisioni reali e potenzialmente dannose.

Dal punto di vista della fiducia, il danno è doppio. Da una parte si erode la credibilità dei servizi AI, perché l’utente non ha modo di capire se sta parlando con un assistente neutrale o con un assistente “preparato” da terzi. Dall’altra, si sfrutta una caratteristica psicologica ben documentata per la quale le risposte dell’AI, spesso formulate con tono assertivo, spingono molte persone a ridurre il livello di verifica. Se infatti il modello appare sicuro di sé, la soglia critica dell’utente scende.

Microsoft insiste sull’invisibilità, un aspetto che rende l’attacco particolarmente insidioso. L’utente può non accorgersi di nulla e, anche se avesse un sospetto, difficilmente saprebbe dove controllare o come ripristinare uno stato “pulito” della memoria.

Le contromisure suggerite da Redmond, almeno per ora, sono soprattutto comportamentali e operative. Agli utenti viene consigliato di prestare attenzione ai link AI, verificare dove portano, controllare le memorie salvate dagli assistenti e cancellare voci sconosciute o anomale. È raccomandata anche una pulizia periodica della memoria, pratica che, in termini di sicurezza, assomiglia a un reset preventivo di un ambiente potenzialmente contaminato.

Lato enterprise, Microsoft spinge infine le organizzazioni a trattare l’AI Recommendation Poisoning come un vettore da monitorare attivamente, con i team di sicurezza che dovrebbero cercare tentativi di injection in email, chat e applicazioni di messaggistica aziendale, perché sono canali perfetti per far cliccare un link “trappola” in modo inconsapevole.

(Immagine in apertura: Shutterstock)