Google inietta la IA di Gemini 1.5 Pro e Flash in tutti i suoi prodotti

Indice dell'articolo

Sfruttando un popolare meme per descrivere questa edizione di Google I/O, possiamo dire c’è un po’ di Google in questo evento sulla IA. I vari modelli IA di Google, e Gemini su tutti, dominano completamente la scena, entrando da protagonisti in praticamente tutti gli annunci fatti dal CEO Sundar Pichai e gli altri manager che si sono alternati sul palco.

Partendo dai modelli fondativi, accanto ad alcune ottimizzazioni per Gemini 1.5 Pro, come miglioramenti nelle traduzioni, nel ragionamento, nella generazione di codice o la possibilità di richiedere di l’accesso alla lista di attesa per una versione con finestra di contesto da ben due milioni di token, l’annuncio più interessante è probabilmente rappresentato da Gemini 1.5 Flash.

Pur conservando alcune delle caratteristiche del fratello maggiore, come la multimodalità (capisce testo, immagini, audio e video) o una finestra di contesto da un milione di token (equivalente a circa 700.000 parole, 1 ora di video o 11 ore di audio), Google dichiara per Flash una latenza inferiore al secondo nella generazione dei token e un costo di utilizzo inferiore.

Sembra quindi terminata la gara a costruire il modello proprietario più grande possibile per concentrarsi invece su modelli ottimizzati per offrire il miglior compromesso tra prestazioni e consumo di risorse, e quindi costi di utilizzo.

Gemini 1.5 Pro e 1.5 Flash sono disponibili in preview pubblica all’interno di Google AI Studio e Vertex AI.

Crescono invece le dimensioni del modello open source Gemma, che con la versione 2 passa da 7 a 27 miliardi di parametri, ma secondo Google ha prestazioni equivalenti a Llama 2 70B, e si arricchisce con la versione PaliGemma specializzata nella visione e descrizione di immagini.

È stata anche annunciata la disponibilità in Europa della versione a pagamento Gemini Advanced, basata su Gemini 1.5 Pro.

Project Astra, il futuro degli assistenti IA per Google

Google ha anche mostrato Project Astra, una versione ancora sperimentale di agente in grado di colloquiare con l’utente in modo interattivo e sulla base di suoni e immagini percepiti dalla videocamera dello smartphone o di un paio di occhiali smart anch’essi sperimentali.

Da quanto mostrato nel video, l’assistente è in grado non solo di rispondere a domande riguardanti l’immagine inquadrata, dimostrando capacità di ragionamento piuttosto avanzate, ma anche di ricordare quanto visto in precedenza, per esempio per aiutare l’utente a localizzare un oggetto.

Astra appare come una risposta diretta all’app alimentata dal modello GPT 4o presentata l’altro giorno da OpenAI, e apre una finestra su un mondo in cui davvero gli assistenti potrebbero fornire un aiuto nella vita quotidiana e nel lavoro che potrà potenziare le capacità di tutti, ma anche permettere ad anziani e disabili di avere un supporto importante.

Gemini 1.5 Pro in Workspace, Gmail e Google Photos

La sidebar di Workspace con le funzioni di IA generativa, per chi ha abilitato le funzioni Workspace Labs, userà da oggi Gemini 1.5 Pro. Le maggiori capacità di elaborare richieste complesse e mettere in relazione più informazioni grazie alle dimensioni della finestra di contesto permetteranno agli utenti di chiedere per esempio un riassunto di lunghe catene di email o estrarre informazioni utili da appunti, documenti complessi e trascrizioni di riunioni.

I miglioramenti nel supporto di lingue differenti hanno consentito di abilitare funzioni di traduzione automatica nelle riunioni Google Meet tra 60 lingue, e di abilitare la funzione “Help me write” in più lingue.

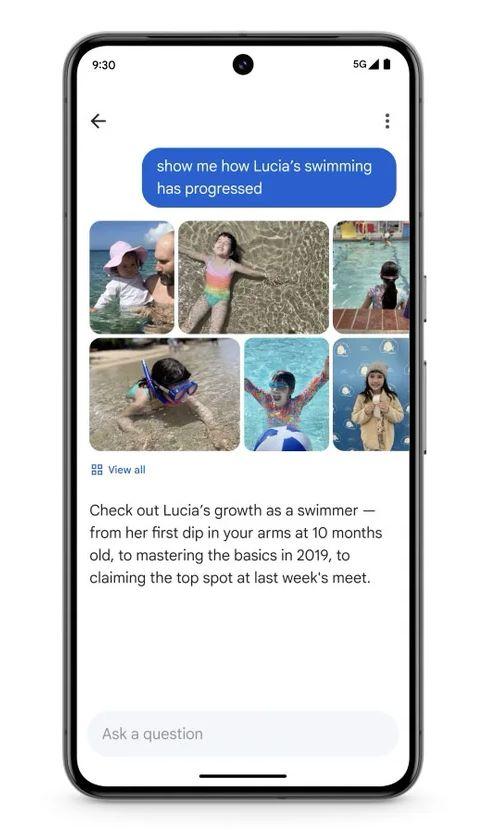

Grazie alle capacità multimodali di Gemini, sarà possibile interrogare il nostro archivio di foto per selezionare quelle che corrispondono a criteri complessi (per esempio, “mostrami i progressi nel nuoto di mia figlia nel corso degli ultimi anni) estrarre informazioni contenute nelle immagini (“qual è il numero di targa della mia auto?”).

Grazie alle capacità multimodali di Gemini, sarà possibile interrogare il nostro archivio di foto per selezionare quelle che corrispondono a criteri complessi (per esempio, “mostrami i progressi nel nuoto di mia figlia nel corso degli ultimi anni) estrarre informazioni contenute nelle immagini (“qual è il numero di targa della mia auto?”).

Questo va al di là di una semplice ricerca sulle etichette applicate dalla IA che abbiamo oggi, che permette di trovare tutte le foto di nostra figlia o tutte le targhe, e prevede una interpretazione avanzata della richiesta, la correlazione di più fattori e l’estrazione di informazioni e significati per dare una risposta organica, fatta di immagini ma anche di testo.

La funzione Ask Photos sarà disponibile a partire dalla prossima estate.

La ricerca generativa arriva per (quasi) tutti

Non si può parlare di IA e Google senza citare la ricerca web, cioè la funzione su cui è nata l’azienda. La ricerca generativa, che permette di rispondere a richieste complesse ed estrarre informazioni sintetiche dal patrimonio informativo del web, finora è stata disponibile solo per chi ha abilitato le funzioni sperimentali all’interno di Google Labs. La ricerca generativa sarà ora automaticamente disponibile per tutti gli utenti americani e progressivamente in altre nazioni. Speriamo arrivi anche per gli utenti europei, che al momento non possono nemmeno attivare la funzione sperimentale in Google Labs a distanza di un anno dal suo lancio.

Tra le funzionalità della Generative Search c’è AI Overviews, che offre risposte veloci a domande strutturate, estraendo le informazioni da diverse pagine web. AI Overview potrà a breve anche essere configurata per avere risposte più o meno sintetiche, o per punti.

Sarà anche possibile fare ricerche complesse, per esempio chiedere tutti i negozi che offrono un certo tipo di servizio in una certa area, o pianificare un’attività che comprende più passaggi.

Particolarmente sorprendente il passaggio dalla ricerca per immagini alla ricerca per video. Nell’esempio mostrato, l’app inquadra un giradischi il cui braccio non rimane sulla traccia, e offre all’utente una spiegazione del perché non stia funzionando nel modo corretto.

Che momento stiamo vivendo nel settore della IA

Nel campo della IA la competizione è più calda che mai, e gli annunci delle principali aziende che sviluppano i modelli si concentrano in periodi specifici, tentando di arrivare un giorno prima del concorrente nell’annunciare un nuovo prodotto o funzionalità. OpenAI ha annunciato l’altro giorno il modello GPT 4o, più leggero per i server e veloce nelle risposte, e le stesse caratteristiche le possiamo ritrovare in Gemini Flash; il modello per generare video da descrizioni testuali Veo appare come un diretto concorrente di Sora di OpenAI.

Mettersi a fare la spunta delle caselle con le funzionalità a confronto – specialmente per quelle al momento solo annunciate – ha poco senso, quando si parla di Google che oltre alla tecnologia può contare su un portfolio di prodotti e servizi che arriva a miliardi di persone, e che l’azienda può sfruttare per far arrivare al pubblico i suoi servizi di intelligenza artificiale.

Nel keynote introduttivo di Google I/O, il CEO Sundar Pichai ha detto che Gemini arriva oggi a due miliardi di persone che usano i servizi Google, ma la realtà è che non arriva per tutti allo stesso modo.

Le funzionalità di ricerca generativa non sono al momento attivabili in Europa o per gli account collegati a Google Workspace. Altre funzionalità sono in lista di attesa.

La vastità del pubblico potenziale, del resto, deve fare i conti con la sostenibilità in termini di risorse di calcolo e quindi i costi. E forse anche con la trasformazione dell’ecosistema dell’informazione e della conoscenza verso una modalità che non dipenda più dal traffico generato dalle ricerche web, che andrà inesorabilmente a erodersi in modo significativo.