DeepSeek pubblica in sordina il nuovo modello “pensante” R1-0528. Nel coding è una bomba

Il panorama degli LLM si è appena arricchito di un nuovo protagonista: DeepSeek R1-0528. Questo modello cinese rappresenta un aggiornamento della serie R1, già nota per le sue prestazioni di alto livello in ambito ragionamento, coding e gestione di testi complessi, e si basa su un’architettura avanzata, con una dimensione dichiarata di 685 miliardi di parametri che ne fa uno dei modelli più grandi mai rilasciati pubblicamente. Tuttavia, la sua struttura si avvale di tecniche di efficienza come il Mixture of Experts (MoE), che permette di attivare solo una parte dei parametri per ogni token, ottimizzando così sia le prestazioni che i costi computazionali.

Il modello è stato rilasciato con licenza MIT su piattaforme come Hugging Face, consentendone l’uso commerciale e facilitando l’adozione da parte della comunità di sviluppatori e aziende. Inoltre, grazie all’integrazione con servizi come OpenRouter, è possibile accedere a R1-0528 tramite API unificate, anche in versione gratuita, abbattendo le barriere di ingresso per test e sviluppo.

Uno dei punti di forza di DeepSeek R1-0528 è la sua abilità nel ragionamento strutturato e nella generazione di codice. Nei benchmark di settore, il modello si posiziona infatti immediatamente dietro i più recenti modelli OpenAI (o4 mini, o3) per quanto riguarda la generazione di codice, superando concorrenti come Qwen 3 di Alibaba e Grok 3 mini di xAI. Gli utenti che lo hanno testato segnalano risposte più lente ma molto più accurate, con processi di pensiero più articolati e output di codice pulito e funzionante al primo tentativo.

DeepSeek R1-0528 offre inoltre una finestra di contesto estesa (fino a 164.000 token), che lo rende particolarmente adatto alla gestione di documenti lunghi e attività di analisi testuale avanzata. Questo lo pone tra i modelli più performanti per attività come riassunti, traduzioni e analisi di documenti complessi.

Un aspetto distintivo di questo LLM è il rapporto tra prestazioni e costi. R1-0528 riesce infatti a offrire capacità paragonabili ai top di gamma statunitensi a una frazione del costo computazionale, grazie all’architettura MoE e a un processo di inferenza ottimizzato. Questo lo rende particolarmente competitivo per aziende e sviluppatori con budget limitati.

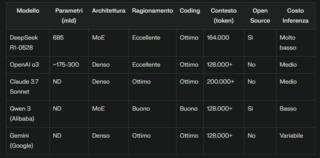

Per comprendere meglio il posizionamento nel mercato di questo nuovo LLM, è utile confrontarlo con i modelli di punta di altre aziende leader nel settore IA:

- DeepSeek R1-0528 vs OpenAI o3: DeepSeek R1-0528 si avvicina molto alle prestazioni di OpenAI o3, soprattutto nei compiti di ragionamento e coding, ma offre un vantaggio significativo in termini di costi e apertura (open source). OpenAI resta leggermente superiore nella generazione di codice nei test LiveCodeBench, ma la differenza si assottiglia sempre più

- DeepSeek R1-0528 vs Claude 3.7 Sonnet: Rispetto a Claude 3.7 Sonnet di Anthropic, DeepSeek R1-0528 mostra una maggiore profondità di ragionamento e una migliore capacità di gestire compiti complessi, sebbene Claude sia preferibile per interazioni più conversazionali e fluide. Entrambi eccellono nell’analisi documentale, ma DeepSeek offre risposte più dettagliate e strutturate

- DeepSeek R1-0528 vs Qwen 3 e Gemini: Qwen 3 di Alibaba e Gemini di Google rappresentano alternative solide, ma DeepSeek R1-0528 si distingue per la qualità del ragionamento e la capacità di generare codice pulito. Inoltre, la sua disponibilità open source e la finestra di contesto ampia lo rendono più accessibile e versatile per molte applicazioni

(Immagine in apertura: Shutterstock)