Confluent lavora per alimentare le AI con dati real time

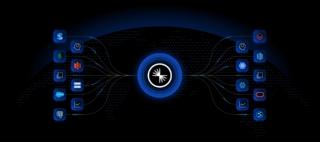

Confluent, pioniere del data streaming e già punto di riferimento nel mondo Apache Kafka, ha annunciato Confluent Intelligence, una piattaforma progettata per colmare il divario tra i dati in movimento e l’intelligenza artificiale fornendo alle aziende uno stack completo, scalabile e interamente gestito per costruire sistemi di IA real-time e ricchi di contesto, capaci di apprendere e reagire istantaneamente agli eventi.

Basata su Confluent Cloud, la nuova soluzione consente alle imprese di trasmettere ed elaborare in modo continuo dati storici e in tempo reale, fornendo un contesto dinamico direttamente alle applicazioni di IA. Confluent Intelligence rappresenta in pratica l’anello mancante per creare agenti intelligenti operativi, in grado di prendere decisioni informate senza dover dipendere da batch di dati statici o pipeline complesse.

Come ha sintetizzato Jay Kreps, co-fondatore e CEO di Confluent, “abbiamo fondato l’azienda per risolvere uno dei problemi più difficili del mondo dei dati: permettere alle informazioni di fluire liberamente all’interno di un’azienda, in tempo reale. Oggi, la stessa base ci consente di colmare il divario di contesto nell’intelligenza artificiale”. Kreps evidenzia come i modelli pre-addestrati, per quanto potenti, restino “ciechi” senza un flusso continuo di dati aggiornati. Lo streaming, in questo senso, diventa il carburante che consente all’AI di prendere decisioni realmente utili e tempestive.

L’importanza del contesto nei sistemi IA

Il lancio di Confluent Intelligence arriva in un momento di forte disillusione nei confronti dell’IA generativa. Nonostante gli investimenti stimati tra 30 e 40 miliardi di dollari, il MIT segnala che il 95% delle iniziative GenAI non genera ritorni concreti. Il motivo principale è l’assenza di contesto, dal momento che i modelli non riescono a comprendere relazioni, eventi e significati in modo dinamico, limitandosi a risposte statiche e spesso non pertinenti.

Per superare questo limite, Confluent propone un’infrastruttura in grado di trasmettere, analizzare e adattarsi ai dati in tempo reale, eliminando la latenza e garantendo un flusso continuo di informazioni verso le applicazioni di IA. In questo modo, i sistemi non si limitano a reagire, ma possono anticipare e apprendere dal cambiamento.

È un paradigma che trasforma l’IA da strumento analitico a sistema operativo intelligente per l’intera azienda e che secondo Atilio Ranzuglia, Head of Data and AI del Palmerston North City Council, “permette di costruire una smart city veramente reattiva, dove gli agenti automatizzano i workflow grazie a dati di alta qualità trasmessi in tempo reale”.

Confluent Intelligence: architettura e componenti

Confluent Intelligence si basa su un’integrazione profonda di Apache Kafka e Apache Flink, due pilastri dello streaming moderno. Kafka gestisce la trasmissione dei dati, mentre Flink elabora i flussi in tempo reale. A questo si aggiungono funzionalità di governance integrata, prestazioni a bassa latenza e “replayability”, ossia la possibilità di riprodurre eventi passati per addestrare o testare modelli in modo continuo.

La piattaforma introduce tre moduli fondamentali:

- Power with Real-Time Context Engine: un motore che trasmette contesto strutturato e affidabile a qualsiasi agente o applicazione IA, sia interna sia esterna, grazie al supporto del Model Context Protocol (MCP). Questo consente ai team di accedere a dati attendibili e aggiornati in un unico punto, senza dover gestire infrastrutture complesse basate su Kafka. Il servizio è attualmente in Early Access

- Build with Streaming Agents: Questa funzione permette di creare, distribuire e orchestrare agenti event-driven direttamente in Flink, unificando l’elaborazione dei dati con il ragionamento dell’IA. Gli agenti così costruiti possono osservare, decidere e agire autonomamente in tempo reale, riducendo al minimo l’intervento umano. Il servizio è in Open Preview

- AI/ML Functions with Confluent Cloud for Apache Flink: La piattaforma include funzioni di machine learning pronte all’uso (rilevamento di anomalie, previsioni, inferenza e visualizzazione in tempo reale) direttamente in Flink SQL. Questo approccio semplifica il lavoro dei team di data science, che possono così ottenere insight azionabili più rapidamente e trasformarli in decisioni operative

La collaborazione con Anthropic e l’integrazione di Claude

Un aspetto chiave della strategia è la partnership con Anthropic, con Claude che diventerà l’LLM predefinito integrato all’interno degli Streaming Agents di Confluent. L’obiettivo è creare sistemi IA adattivi e contestuali, in grado di filtrare automaticamente il rumore informativo per evidenziare ciò che conta davvero. Tra i casi d’uso più promettenti, Confluent cita il rilevamento intelligente delle anomalie, la personalizzazione in tempo reale e l’automazione dinamica dei processi decisionali.

La sinergia tra il motore di contesto real-time di Confluent e la capacità linguistica di Claude promette così di aprire nuove possibilità per applicazioni industriali, smart city, supply chain e customer experience evolute.