Con il chip per l’inferenza AI Maia 200, Microsoft alza la posta nella sfida con AWS e Google

Con la presentazione di Maia 200, Microsoft compie un passo ulteriore nella costruzione di una propria sovranità tecnologica nel campo dell’intelligenza artificiale. L’acceleratore di seconda generazione sviluppato internamente punta infatti a ridurre la dipendenza dall’ecosistema Nvidia nel momento in cui l’inferenza dei modelli di grandi dimensioni diventa il vero collo di bottiglia dell’IA generativa su scala cloud. Maia 200 non è infatti un processore general purpose per l’addestramento, ma un chip disegnato attorno alla generazione di token in tempo reale per modelli sempre più estesi e complessi.

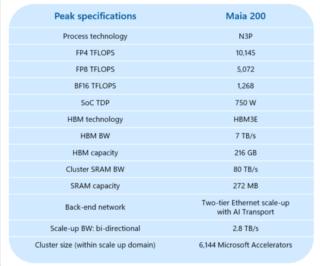

Realizzato da TSMC sul nodo produttivo N3, Maia 200 integra 144 miliardi di transistor e raggiunge una potenza dichiarata di 10 petaFLOPS in FP4. Numeri che lo collocano direttamente in competizione con le prime GPU Blackwell di Nvidia come la B200, almeno per quanto riguarda l’inferenza. Scott Guthrie, responsabile cloud e AI di Microsoft, ha chiarito che l’architettura di Maia 200 è stata ottimizzata esplicitamente per gestire modelli di dimensioni estreme come quelli orientati al reasoning e alle catene di pensiero, oggi centrali nello sviluppo dei sistemi generativi avanzati.

La scelta progettuale ruota attorno al principio secondo cui, durante l’inferenza, la vera risorsa critica non è il calcolo in sé, bensì la banda di memoria. Ogni token generato richiede infatti l’accesso continuo ai pesi attivi del modello e questo impone un limite fisico alla reattività dei sistemi. Maia 200 affronta il problema equipaggiandosi con 216 GB di memoria ad alta velocità distribuiti su sei stack HBM3e, per una banda complessiva di circa 7 TB/s. Le B200 di Nvidia offrono meno memoria o valori simili con una banda che però si attesta sugli 8 TB/s, mentre le versioni più recenti aumentano la capacità senza incrementare ulteriormente la velocità.

Maia 200 viene anche presentato da Microsoft come un acceleratore IA sensibilmente più economico e parsimonioso nei consumi rispetto alle alternative sul mercato. Con un assorbimento massimo di 750 watt, il chip resta ben al di sotto delle GPU Nvidia di fascia alta, che possono superare i 1.200 watt. Questo consente un’integrazione più flessibile nei data center anche in configurazioni raffreddate ad aria, un dettaglio tutt’altro che secondario quando si parla di scalare l’infrastruttura globale di Azure.

Il prezzo di questa efficienza emerge analizzando il supporto alle precisioni numeriche. Il cuore computazionale di Maia 200, il Tile Tensor Unit, lavora nativamente solo con FP8, FP6 e FP4. Le operazioni a 16 o 32 bit vengono demandate ai Tile Vector Processor, con un impatto prestazionale significativo. È una scelta coerente con lo stato attuale dell’inferenza dei LLM, che sempre più spesso utilizza pesi a bassissima precisione, come le varianti a 4 bit, mantenendo precisioni superiori solo per attivazioni e cache temporanee al fine di preservare l’accuratezza del modello. Sul fronte dell’addestramento, però, BF16 resta lo standard dominante, ed è qui che Maia 200 mostra chiaramente i propri limiti strutturali.

Questo spiega perché, nonostante i progressi, Microsoft non abbia alcuna intenzione di ridurre drasticamente gli acquisti di GPU Nvidia nel breve periodo. L’arrivo di Rubin, la prossima architettura Nvidia, promette un salto prestazionale rilevante anche in inferenza, rendendo evidente come Maia 200 sia parte di una strategia di diversificazione più che di sostituzione totale.

Dove il chip Microsoft mostra ambizioni di lungo periodo è invece nella scalabilità. Ogni Maia 200 dispone di 2,8 TB/s di banda bidirezionale per la comunicazione tra chip, permettendo la creazione di cluster fino a oltre seimila unità. In questa configurazione, si arriva a decine di exaFLOPS di potenza aggregata e a oltre un petabyte di memoria HBM condivisa. Il tutto è orchestrato tramite una rete Ethernet integrata on-chip e un protocollo di trasporto proprietario, una scelta che richiama soluzioni già viste in ambito AMD e Intel pur andando in direzione opposta rispetto a tecnologie come NVLink.

Per evitare colli di bottiglia, Microsoft ha inoltre introdotto una gestione dinamica dei 272 MB di SRAM per chip, suddivisibili tra buffer di comunicazione a livello di cluster e cache locali per le operazioni matriciali. È un approccio raffinato, pensato per sostenere modelli frontier da trilioni di parametri, inclusi quelli sviluppati da OpenAI.

Maia 200 è già operativo in alcuni data center statunitensi e verrà esteso ad altre regioni nei prossimi mesi. A supporto, Microsoft ha rilasciato un SDK in anteprima con compatibilità PyTorch e Triton, segnale chiaro della volontà di abbassare le barriere di adozione e trasformare l’acceleratore in una componente strutturale dell’offerta cloud.