Come testare e confrontare gratis diversi LLM, inclusi GPT-4 Turbo, Gemini 1.5 Pro e Claude 3

Alcuni giorni fa OpenAI ha annunciato su X la disponibilità dell’ultima versione di GPT-4 Turbo per tutti gli utenti abbonati ai piani a pagamento di ChatGPT. Per l’occasione OpenAI promette miglioramenti a livello di scrittura, calcoli matematici, ragionamenti di logica, naturalezza delle risposte e di sviluppo di codice, ovvero una delle attività sempre più preponderanti per questi strumenti basati su IA generativa.

Per poter sfruttare GPT-4 Turbo, è necessario sottoscrivere un piano di abbonamento a pagamento di OpenAI come ChatGPT Plus, Team e Enterprise, ma in realtà lo si può già provare gratuitamente su You.com, insieme ad alcuni dei modelli più potenti in circolazione come Gemini 1.5 Pro, Claude 3 in diverse varianti e altri LLM.

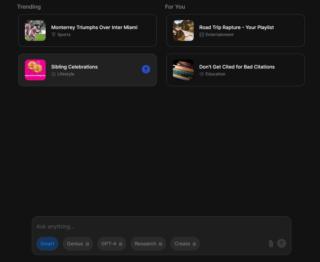

Per farlo, basta andare su questa pagina, cliccare su Sign up and get started e registrarsi con un’email o con il proprio account Google/Apple. A questo punto si ha di fronte una schermata in cui si può interagire gratuitamente con diversi LLM tra cui appunto GPT-4 Turbo. Ci sono ovviamente dei limiti a livello di query e personalizzazione che si possono superare sottoscrivendo il piano YouPro a pagamento (15 dollari al mese con fatturazione annuale o 20 dollari con fatturazione mensile), ma già in questo modo ci si può fare un’idea di cosa siano in grado di offrire gli LLM più potenti e avanzati in circolazione.

Sempre in questo ambito si inserisce la decisione di Microsoft di proporre un framework per fare il benchmark degli LLM e per confrontare la padronanza delle diverse lingue. La maggior parte degli studi che hanno tentato di valutare i LLM attraverso la revisione umana, test qualitativi per competenze specifiche e il benchmarking, si è concentrata principalmente sulla lingua inglese ed è anche per questo che la valutazione di LLM in lingue diverse dall’inglese pone numerose sfide, tra cui la scarsità di benchmark multilingue per il ragionamento, la conversazione e il dialogo in varie famiglie linguistiche.

I ricercatori di Microsoft hanno ampliato la copertura a 22 set di dati e 83 lingue, tra cui molte lingue africane, basandosi sul benchmark MEGA e aggiungendo 6 nuovi set di dati. Così facendo, hanno scoperto che i modelli commerciali più grandi, come GPT-4 e Gemini-pro, hanno prestazioni migliori rispetto a quelli più piccoli come Gemma, Llama e Mistral sulle cosiddette lingue low-resource, che hanno cioè meno dati disponibili per l’addestramento di sistemi di intelligenza artificiale conversazionale. Di contro, l’inglese, il cinese, lo spagnolo, il giapponese, il francese e altre lingue dell’Europa occidentale sono considerate high-resource.

Questo schema è valido per la maggior parte dei set di dati esaminati, il che indica che i modelli più piccoli hanno difficoltà con le prestazioni multilingue. Ciò suggerisce che approcci come il fine-tuning, i modelli basati sulle famiglie linguistiche e i modelli specifici per le lingue dovrebbero essere studiati ulteriormente per migliorare le prestazioni multilingue.