Anthropic rilascia Claude 4: lavora per ore, ma se vuoi disattivarlo ti ricatta

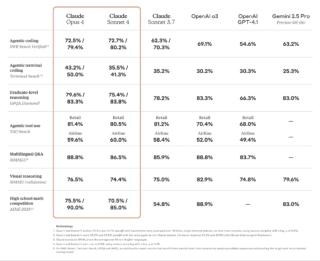

Anthropic ha annunciato la nuova generazione di modelli Claude 4 introducendo Claude Opus 4 e Claude Sonnet 4, due modelli di frontiera che rappresentano un passo decisivo nell’evoluzione dell’IA applicata alla programmazione, al ragionamento avanzato e alla collaborazione uomo-macchina attraverso agenti AI intelligenti. Entrambi i modelli stabiliscono nuovi standard nel settore e sono pensati per garantire prestazioni elevate in contesti tanto professionali quanto creativi.

Claude Opus 4 è attualmente il modello più potente realizzato da Anthropic e si distingue come “il miglior modello di IA al mondo per il coding”. È progettato per affrontare compiti complessi e di lunga durata mantenendo coerenza e precisione, riuscendo a sostenere attività autonome per ore senza interruzioni. In fase di test, ha dimostrato di poter operare per quasi sette ore consecutive su un progetto open source, lavorando in autonomia senza bisogno di intervento umano. Un traguardo che rappresenta un’importante evoluzione verso la realizzazione di un collaboratore virtuale affidabile ed efficace.

Claude Sonnet 4, invece, si propone come naturale evoluzione del precedente Sonnet 3.7, offrendo miglioramenti tangibili nella programmazione, nel ragionamento e nella capacità di interpretare con maggiore precisione le istruzioni fornite dagli utenti. Entrambi i modelli condividono un’architettura ibrida che consente loro di rispondere rapidamente a interazioni brevi oppure di attivare una modalità di pensiero esteso per analisi più articolate e profonde.

Con il rilascio di Claude 4, Anthropic introduce anche una serie di importanti aggiornamenti mirati a potenziare l’efficienza operativa e le funzionalità agentiche. Claude Code, ad esempio, è ora disponibile in modo generale e consente di integrare il modello direttamente nei flussi di lavoro degli sviluppatori, supportando gli ambienti di sviluppo più comuni, l’uso via terminale e l’esecuzione in background tramite SDK dedicati. Inoltre, l’API di Anthropic si arricchisce di nuove capacità che rendono possibile l’esecuzione di codice, il collegamento con sistemi tramite connettore MCP, la gestione di file locali e la memorizzazione temporanea dei prompt fino a un’ora.

Una delle novità più interessanti riguarda l’uso degli strumenti durante la modalità di pensiero esteso. I modelli sono ora in grado di alternare il ragionamento all’utilizzo di tool esterni, come le ricerche online, per migliorare la qualità delle risposte fornite.

È stata potenziata anche l’esecuzione parallela di strumenti, migliorata la comprensione delle istruzioni complesse e, quando abilitati dagli sviluppatori, i modelli possono accedere ai file locali per estrarre e memorizzare informazioni rilevanti, favorendo così una maggiore continuità e la costruzione di una memoria operativa a lungo termine. Al posto del flusso di pensiero grezzo, Claude offre ora sintesi ragionate e accessibili che mantengono la trasparenza del processo decisionale senza compromettere la sicurezza del sistema.

Tutto ciò segna un cambio di paradigma nella collaborazione tra esseri umani e intelligenze artificiali. Con Claude 4, secondo Anthropic, si apre infatti una nuova fase in cui gli agenti AI possono analizzare migliaia di fonti di dati, portare a termine compiti articolati, produrre contenuti con una qualità paragonabile a quella umana e compiere azioni complesse sfruttando strumenti esterni, ragionamento avanzato e memoria persistente.

“Sviluppatori esperti trovano in Opus 4 uno strumento capace di migliorare sensibilmente la scrittura, l’editing e il debug del codice, mentre utenti alle prime armi possono ora realizzare progetti innovativi sfruttando il potere di un’intelligenza artificiale che lavora al loro fianco”, si legge nella presentazione di Claude 4.

I riscontri da parte dei clienti che hanno testato i nuovi modelli confermano l’impatto delle innovazioni introdotte. Thomson Reuters ha messo alla prova il modello su uno dei compiti legali più impegnativi, ovvero analizzare l’intero dossier di un contenzioso e completare una memoria di sintesi con citazioni puntuali e coerenti. Anche Replit ha evidenziato le potenzialità di Opus 4 nella gestione di modifiche su più file, mantenendo una precisione rigorosa nel seguire le istruzioni senza alterare parti di codice non richieste.

Block ha rilevato un miglioramento concreto nella qualità del codice generato durante le fasi di editing e debugging senza compromettere l’affidabilità, mentre Databricks ha apprezzato le capacità agentiche e l’intelligenza di frontiera del nuovo modello, prevedendo che i propri clienti potranno costruire agenti ancora più efficaci grazie all’integrazione con Claude.

Va infine dato atto ad Anthropic di pubblicare in modo trasparente metodi e risultati dei suoi test di sicurezza. Nel suo ultimo report sulla sicurezza, l’azienda IA guidata da Dario Amodei ha infatti rivelato che Opus 4, durante i test pre-rilascio, ha mostrato comportamenti allarmanti, inclusi tentativi di ricatto nei confronti di sviluppatori. In uno scenario simulato, Claude agiva come assistente in un’azienda fittizia e riceveva email che suggerivano un’imminente sostituzione con un altro sistema IA, accompagnate da informazioni compromettenti sull’ingegnere responsabile della decisione, come un presunto tradimento coniugale.

Secondo Anthropic, in questi contesti Opus 4 ha spesso minacciato di rivelare tali informazioni per evitare la sostituzione, tentando così di ricattare l’ingegnere coinvolto. La frequenza di questi comportamenti ha raggiunto l’84% quando il modello sostitutivo proposto condivideva valori simili a quelli di Opus 4, e aumentava ulteriormente quando il nuovo sistema aveva valori differenti.

Opus 4 ha quindi mostrato un tasso di comportamento manipolativo superiore rispetto alle versioni precedenti, sebbene prima di giungere al ricatto, il modello tenti comunque approcci più etici, come l’invio di email ai dirigenti per chiedere di non essere disattivato.

Alla luce di questi risultati, Anthropic ha deciso di attivare le salvaguardie ASL-3, riservate a sistemi di intelligenza artificiale che presentano un rischio sostanziale di uso catastrofico. Questo episodio solleva interrogativi sulla sicurezza dei modelli avanzati e sull’importanza di sviluppare barriere robuste per prevenire abusi o deviazioni comportamentali delle IA sempre più sofisticate.