AMD Instinct MI300X: prime prestazioni MLPerf competitive con Nvidia H100

AMD ha recentemente pubblicato i risultati dei benchmark MLPerf Inference per il suo acceleratore IA Instinct MI300X, che si è dimostrato competitivo con l’Nvidia H100 anche se solo su un singolo benchmark pur rimanendo indietro rispetto alla versione aggiornata H200 e al prossimo B200.

AMD ha condiviso solo i numeri di prestazione del MI300X nel benchmark MLPerf 4.1 per IA generativa sul modello Llama 2 70B. Un sistema con otto processori MI300X si è dimostrato leggermente più lento (23.512 token/secondo offline) rispetto a un sistema con otto processori Nvidia H100 SXM3 (24.323 token/secondo offline). Nel benchmark server più realistico, il sistema AMD MI300X è risultato invece leggermente più veloce: 21.028 token/secondo contro 20.605 token/secondo.

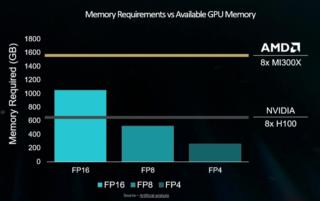

Ci sono però due aspetti importanti da considerare. Le prestazioni di picco del MI300X per l’IA sono 2,6 POPs, mentre quelle dell’H100 di Nvidia sono 1,98 FP8/INT8 TFLOPS/TOPS. Inoltre, il modulo H100 SXM3 di Nvidia ha 80GB di memoria HBM3 con una larghezza di banda di picco di 3,35 TB/s, mentre l’Instinct MI300X di AMD è dotato di 192GB di memoria HBM3 con una larghezza di banda di picco di 5,3 TB/s.

Questi fattori dovrebbero dare al MI300X di AMD un enorme vantaggio sull’H100 di Nvidia in termini di prestazioni, considerando che la capacità e la larghezza di banda della memoria giocano un ruolo cruciale nei carichi di lavoro di inferenza AI. Tuttavia, l’Instinct MI300X riesce a malapena a vincere nel benchmark di inferenza server e rimane indietro rispetto all’H100 nel benchmark di inferenza offline.

Sembra inoltre che l’MI300X non riesca a sfruttare appieno le sue capacità hardware, probabilmente a causa dello stack software; questo potrebbe spiegare perché AMD abbia evitato finora di mostrare risultati MLPerf. Il fatto che AMD abbia finalmente mostrato i risultati per GPU singole e in configurazione a 8 vie è comunque promettente, e l’essere competitivo con l’H100 di Nvidia è un risultato notevole.

Se invece si parla di prestazioni tra l’MI300X e il più recente H200 di Nvidia, quest’ultimo è significativamente più veloce, principalmente grazie all’aumento della capacità e della larghezza di banda della memoria, mentre l’acceleratore di prossima generazione Nvidia B200 alza ulteriormente l’asticella.

Resta infine da vedere le performance complete di MLPerf 4.1 per l’MI300X che includano tutti e nove i benchmark standardizzati. Llama 2 70B è infatti solo uno di questi, con altri test come 3D Unet, BERT, DLRM, GPT-J, Mixtral, Resnet, Retinanet e Stable Diffusion XL che fanno parte della versione attuale.