3 soluzioni per industrializzare lo sviluppo dell’intelligenza artificiale

SAN FRANCISCO (CA) – In un’epoca in cui la competitività è sempre più spinta, l’intelligenza artificiale ha le potenzialità per trasformare radicalmente il business e la vita di tutti noi. Una ricerca di Price Waterhouse Cooper citata anche in uno studio del Parlamento Europeo stima in 700 miliardi di dollari l’impatto positivo della IA sul business della sola Europa Meridionale.

C’è solo un problema: sviluppare soluzioni innovative di intelligenza artificiale è maledettamente difficile, costoso e per nulla garantito. Una ricerca considerata attendibile da diversi imprenditori e manager di aziende di IA che abbiamo incontrato stima che l’85 percento dei progetti di IA fallisce nel suo scopo di soddisfare le esigenze di business per cui erano stati concepiti.

Non stiamo parlando di progetti che fanno ricorso a funzioni di intelligenza artificiale generiche che sono ormai consolidate, economiche e accessibili tramite comode API (ne riparleremo più avanti), ma di modelli originali sviluppati per risolvere un problema aziendale specifico, utilizzando dati interni. Quelli che, insomma, possono creare servizi realmente innovativi che facciano guadagnare all’azienda un vantaggio sulla concorrenza.

Lo sviluppo di nuovi modelli di IA è ancora un processo artigianale, che richiede competenze altamente specializzate e difficilmente reperibili sul mercato del lavoro (gli ormai mitici data scientist), una grande quantità di dati di buona qualità, strumenti hardware e software in continua evoluzione, con infiniti parametri da configurare manualmente. Siamo all’epoca delle prime automobili costruite a mano in officina da Karl Benz. La macchina funziona, ma non è facilmente replicabile su vasta scala. Affinché la IA possa penetrare e diffondersi nel business, è necessario che qualcuno inventi l’equivalente della catena di montaggio di Henry Ford.

Nel nostro recente tour tra le startup in Silicon Valley, abbiamo incontrato tre aziende che, con metodi diversi, ci stanno provando.

Valohai: gestione delle pipeline di deep learning

“C’è un grande problema di usabilità nel machine learning. Prendere dataset grandi e configurare una piattaforma hardware adeguata per addestrare un modello è già difficile in sé, ma rendere il tutto utilizzabile in pratica dai data scientist lo è ancor di più”, ci dice Eero Laaksonen, CEO di Valohai, startup finlandese che ha messo radici a San Francisco e che fornisce una soluzione per la gestione di piattaforme di deep learning.

Eero Laaksonen, cofondatore e CEO di Valohai

“Per le aziende che lo comprendono, avere i modelli più velocemente degli altri è la chiave per battere la concorrenza – dice Laaksonen – è quindi necessario un nuovo paradigma di ingegnerizzazione per superare l’attuale collo di bottiglia: permettere ai data scientist di addestrare i modelli più velocemente”. A questo, si aggiungono una serie di complicazioni normative riguardanti il trattamento dei dati e la possibilità di fare auditing dei processi aziendali in cui è coinvolta la IA.

La ricetta di Valohai per lo sviluppo veloce e standardizzato della IA prevede quattro ingredienti principali.

1. Rendere gli esperimenti riproducibili, velocemente

In campo IA, il soggetto di un esperimento non è costituito dal solo codice, ma è un sistema complesso formato da script, dati, configurazione hardware e altri parametri. Per riprodurre un test, è necessario replicarli tutti. Non sempre però le informazioni su versione del codice, dataset utilizzato ed esatte configurazioni delle variabili d’ambiente e dell’infrastruttura sono documentate in modo efficiente. Valohai permette di effettuare fork tenendo traccia delle variabili modificate e permettendo il controllo di versione.

2. Compliance normativa

Il GDPR, così come il recente California Consumer Privacy Act e altre norme che verranno, prevedono che un consumatore possa richiedere a un’azienda la cancellazione dei suoi dati. Cancellarlo dall’anagrafica è semplice, ma se i suoi dati sono serviti ad addestrare un modello IA, dopo essere magari stati sottoposti a trasformazioni successive, l’azienda potrebbe non essere in grado di rintracciarli e garantirne la cancellazione (cosa che avrebbe comunque un impatto sul funzionamento dell’algoritmo, ma questo è un altro problema).

Se sotto il punto di vista della privacy le norme sono abbastanza chiare, lo stesso non si può dire di altri aspetti, come la necessità di poter sottoporre ad auditing un processo decisionale. Se l’algoritmo di una banca decide di chiudere la linea di credito di un’azienda, questa dovrebbe avere il diritto di chiederne il motivo e verificare che la decisione non sia frutto di discriminazione (bias) intenzionale o involontaria. E se da una simile decisione automatico si genera un danno a terzi, un giudice potrebbe richiedere di revisionare il processo che, ripetiamo, non è svolto dal solo algoritmo, ma dall’insieme algoritmo, dati e infrastruttura. Serve quindi tracciabilità e visibilità su tutta la pipeline, con un sistema di version control.

3. Veloce insediamento di nuovi membri nei team

La figura del data scientist, si sa, è al momento molto ricercata dalle aziende, che si contendono le poche figure molto qualificate con offerte “che non si possono rifiutare”. La mobilità in questo ruolo è quindi molto elevata. Con l’attuale approccio artigianale, la perdita del data scientist per dimissioni può comportare una battuta d’arresto importante ai progetti (fino a sei mesi di lavoro, secondo Laaksonen).

4. Permettere di sperimentare velocemente

Con i tassi di fallimento citati in precedenza, per riuscire a trovare una soluzione funzionante è necessario… Fallire più velocemente. La piattaforma di Valohhai permette di eseguire decine di test in parallelo, scalando le risorse in base all’effettiva necessità.

Valohai ha attualmente una quindicina di dipendenti, ma è ancora in crescita grazie a finanziamenti per 1,8 milioni di dollari in tre anni da venture capitalist e da fondi inglesi e finlandesi. Il motto aziendale è “non c’è niente di artificiale nell’intelligenza”. Hanno ragione.

Onepanel: gestire workflow di IA su cloud pubblico o privato

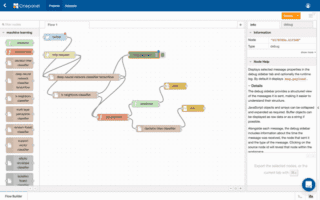

Un workflow Node-RED può essere creato in modo visuale.

In dettaglio, Onepanel permette di accedere, attraverso un’interfaccia grafica semplificata che l’azienda definisce “un IDE per il deep learning”, le seguenti funzionalità:

- Gestione di Pipeline AI con fork (Progetti)

- Gestione dei Dataset

- Annotazioni ai dati

- Sviluppo dei modelli

- Addestramento dei modelli

- Analisi delle prestazioni

- Sviluppo dei modelli

- Deployment dei modelli

- SDK e interfaccia CLI

- Template di container personalizzati

Onepanel supporta molti linguaggi, framework e strumenti usati nel campo, come TensorFlow, PyTorch, jupyter, Node-RED e Keras, e fornisce strumenti che permettono a team di sviluppo distribuiti geograficamente di collaborare in modo efficace a progetti di IA.

L’azienda offre i suoi servizi attraverso tre diverse offerte, CVAT Workflow Starter (solo cloud pubblico), Team ed Enterprise (su cloud pubblico o privato, quest’ultimo rivolto in particolare a chi ha stringenti requisiti di compliance normativa). Al piano sottoscritto vanno poi aggiunte le risorse di calcolo da dedicare ai workload in cloud, scegliendo tra diverse combinazioni di CPU, GPU e memoria (con tariffazione oraria), e aggiungendo lo storage necessario, in questo caso con piani mensili per gigabyte.

L’offerta cloud è disponibile anche su Google Cloud Platform, ed è possibile sperimentare la piattaforma registrandosi gratuitamente alla demo sulla piattaforma.

RapidAPI: un marketplace per semplificare e governare lo sviluppo con API in azienda

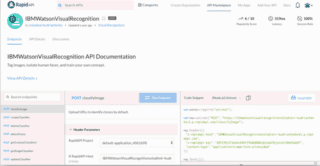

Se l’implementazione tecnica delle API è molto più semplice dello sviluppo di modelli in proprio, il metodo non è privo di complicazioni solo in apparenza secondarie: innanzi tutto è necessario scoprire e confrontare le diverse API disponibili per scegliere la migliore, valutarne la sicurezza nel suo complesso (garanzia di disponibilità e prestazioni, autenticazione e compliance normativa sulla riservatezza dei dati). Se l’API non è disponibile, anche l’applicazione ha un disservizio; se è compromessa, lo è anche l’applicazione. Le aziende hanno inoltre la necessità di monitorare e gestire in modo centralizzato i costi e le autorizzazioni di spesa per sviluppatori o unità di business.

Ogni API ha poi le sue peculiarità e si differenzia dalle altre per il formato utilizzato (Rest, Soap, GraphQL, Rpc, gRpc), autenticazioni (Oauth in diverse versioni o autenticazioni proprietarie), formato di dati (XML, Json, YAML) e protocolli di sicurezza e cifratura.

RapidAPI si propone di risolvere tutti questi problemi attraverso un marketplace in cui le API sono censite e organizzate per tematica, documentate (con SDK ed esempi del codice di richiesta e risposta immediatamente disponibili) e commentate dalla community.

La scheda informativa di ogni API mostra anche la latenza media misurata, la disponibilità nel tempo e la popolarità tra gli utenti.

Scelta l’applicazione da utilizzare, RapidAPI fa da proxy sia da un punto di vista tecnico (per garantire le prestazioni, che vengono costantemente monitorate), sia dal punto di vista della fatturazione, offrendo quindi una visione centralizzata dell’andamento dei costi di tutte le API utilizzate dall’azienda.

Il proxy tecnico è facoltativo: le aziende più grandi possono installare internamente un proprio proxy, così come stabilire vincoli e limiti di utilizzo granulari per i propri dipendenti (alcuni sviluppatori sono autorizzati all’uso di certe API, con determinati limiti) .

All’altro estremo della catena del valore, RapidAPI offre alle aziende che erogano servizi attraverso API una vetrina e un canale di vendita per raggiungere i propri clienti, dietro retrocessione di una commissione sui ricavi. Il marketplace censisce 10.000 API, eroga miliardi di chiamate API all’anno ed è frequentato da un milione di sviluppatori.

Iddo Gino, fondatore e CEO di RapidAPI

Cominciata come progetto open source nel 2014, quando il suo fondatore e CEO Iddo Gino aveva solo 16 anni, RapidAPI ha avuto una crescita velocissima come startup una volta trapiantatasi a San Francisco, raccogliendo 37,5 milioni di dollari di finanziamenti nel giro di tre anni e affermandosi come punto di riferimento in questo mercato che, secondo dati forniti dall’azienda potrebbe raggiungere prossimamente i 2,2 miliardi di dollari. Tra i principali clienti corporate figurano aziende come Rakuten, Cisco, eBay, Hyatt e Tata.