Data center, il gigante da rendere sostenibile

Quella dei grandi centri di elaborazione dati è stata la prima era dell’industria dell’IT, quando la potenza di calcolo era una merce rara e costosa, concentrata in pochi siti ben protetti. Poi è arrivato il personal computer in ogni ufficio, piccolo e potente, e i grandi centri hanno perso parte della loro importanza, a favore delle workstation e dei server compatti. Con la diffusione dell’e-commerce negli anni ‘90, e ancor di più con il cloud computing, è iniziato un fenomeno inverso, una sorta di ritorno alle origini, poiché la necessità da parte delle imprese di fornire servizi on demand, di elaborare grandi quantità di dati e di centralizzare operazioni che spesso avvengono in tutto il mondo, ha portato alla nascita di centri enormi, scalabili e sicuri, a cui potessero attingere in modalità IaaS anche innumerevoli piccole e medie imprese.

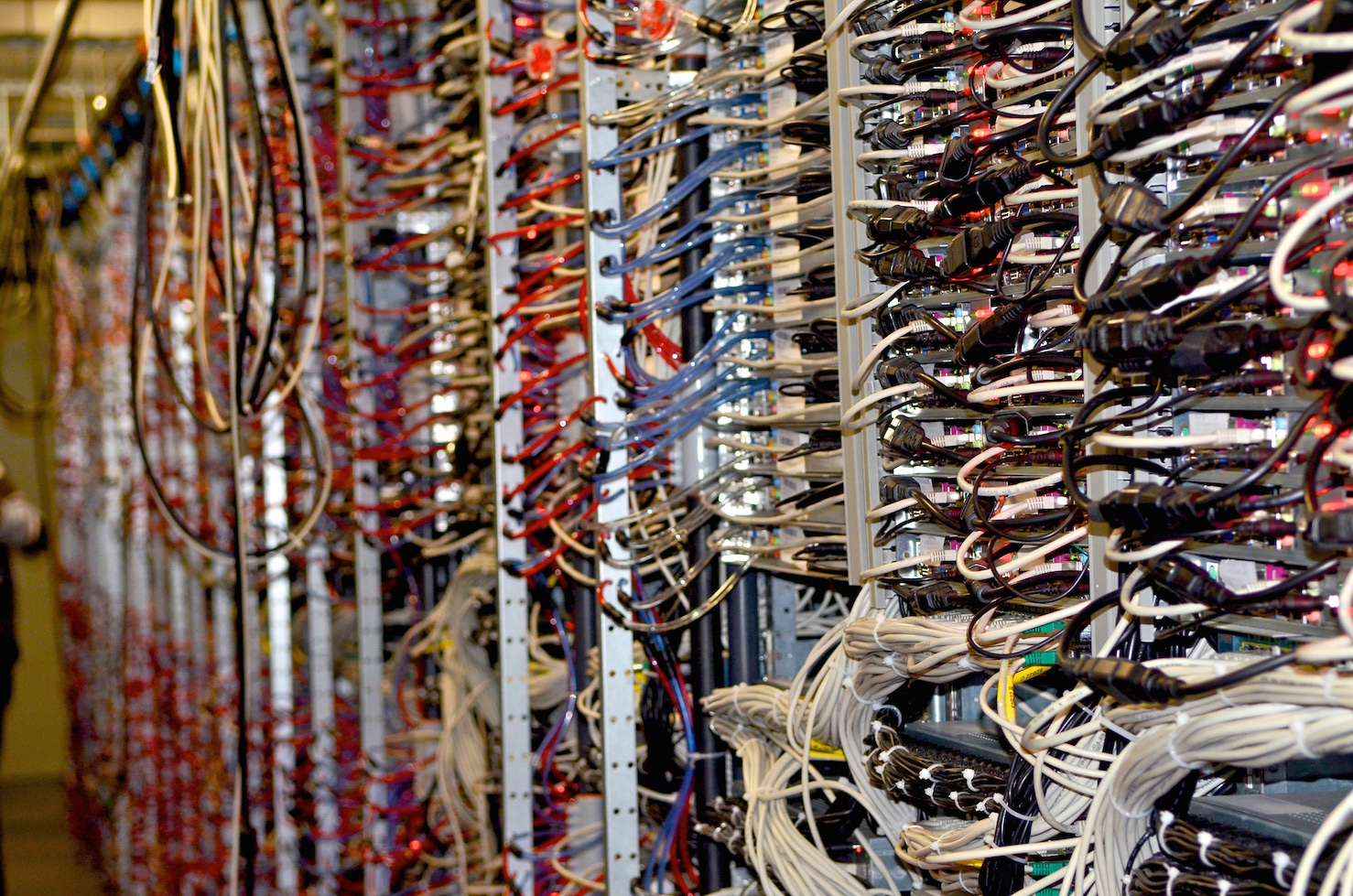

Per questo oggi si tende a realizzare strutture con un’elevata densità di unità di elaborazione rispetto alla superficie del data center, il che comporta consumi energetici sempre più impegnativi, specie per il raffreddamento. Inoltre se prima era normale che le Cpu fossero sfruttate solo parzialmente rispetto alla loro potenza di calcolo, le tecniche di virtualizzazione hanno portato a spremere l’hardware fino all’ultima goccia, creando hot spot difficili da controllare con un sistema di raffreddamento tradizionale, generalmente distribuito in modo uniforme su tutto il data center. La soluzione ideale invece consiste nel creare una mappa tridimansionale della distribuzione del calore e usare soluzioni di raffreddamento intelligenti e modulari che concentrino gli effetti solo dove è necessario.

Quello dello spreco di energia rappresenta l’elemento più critico della progettazione di nuove installazioni, poiché centri sempre più grandi, con consumi paragonabili a quelli di una piccola città, possono diventare insostenibili, specie in questi anni caratterizzati dalla crescita inarrestabile del costo dell’energia.

Secondo Greenpece, 6 tra le più grandi realtà fornitrici di servizi di elaborazione, ovvero Apple, Box, Facebook, Google, Rackspace e Salesforce, hanno promesso di rendere i loro data center al 100% alimentati da fonti rinnovabili, mentre altri, come Amazon, restano più indietro. Ma quando si tratta di aziende relativamente più piccole e meno sotto la lente, la situazione è quanto mai frammentata, e non molti sembrano orientati a seguire una comune best practice.

Come si misura il consumo

Fino a poco tempo fa si era soliti considerare che per ogni watt consumato dall’hardware bisogna metterne in conto due per far funzionare i sistemi di supporto e smaltire il calore. Più precisamente, il livello di efficienza di un data center è specificato da due indicatori, definiti dal consorzio Green Grid. Il DCIE (Data center Infrastructure Efficiency) è definito come l’energia utilizzata dal data center fratto quella utilizzata in totale. Al suo opposto c’è il più conosciuto PUE (Power Usage Effectiveness), calcolato dividendo la potenza totale consumata dall’installazione per quella relativa alla sola parte IT. Il valore ideale per il PUE, praticamente irraggiungibile, è pari a 1, che equivarrebbe alla totale assenza di calore sprecato. La media del PUE per le installazioni negli Stati Uniti è invece 2, che corrisponde appunto alla richiesta di 2 watt consumati per ogni unità di energia effettivamente utilizzata. Le installazioni più efficienti al mondo riescono a mantenere il PUE sotto il valore di 1,2, grazie generalmente a un misto di buona progettazione e condizioni climatiche particolarmente favorevoli. Non è un caso che le installazioni più importanti in Europa siano quelle poste in aree ventose e gelide, come l’impianto di Facebook in Svezia o quello sul Mar Baltico di Google, che dichiara un PUE di 1,12. In Italia, dove la media è tra PUE 2 e 3, uno dei migliori esempi di data center efficiente è quello inaugurato dall’Eni nel 2013, pari a 5200 mq interrati a Ferrera Erbognone, vicino a Pavia, alimentato da una vicina centrale a metano, sempre di Eni, che fornisce i 30MW di potenza necessari al suo funzionamento. Grazie a un moderno ed efficientissimo sistema di raffreddamento, l’impianto è capace di un PUE di 1,2.

Quattro gradi di affidabilità

Dopo l’efficienza energetica, la grande sfida che deve affrontare il progetto di un data center è quello della business continuity. Il livello richiesto per l’affidabilità, la sicurezza e la tolleranza agli imprevisti è il cardine delle specifiche in base alle quali valutare l’investimento in un data center. Dal 2005 esiste una scala che indica con precisione i livelli di affidabilità di un’installazione e quali caratteristiche deve avere per garantirli. È una scala definita dalla statunitense TIA (Telecommunications Industry Association) e suddivide i sistemi in quattro fasce, chiamate tiers e perfezionate dall’Uptime Insitute, organizzazione indipendente che ha specificato il tempo in cui un data center di ciascun livello può restare inattivo nell’arco di un anno.

Il primo livello, indicato come Tier 1, riguarda le installazioni più semplici, che non devono far girare applicazioni business critical. Avranno componenti di potenza non ridondanti, con un unico percorso di alimentazione e generatori con autonomia di 12 ore in caso di blackout. Un data center Tier 1 dovrà essere spento per effettuare in sicurezza interventi di manutenzione programmata, ma non dovrebbe comunque accumulare più di 29 ore di inattività nel corso dell’anno, che corrispondono a un’ availability del 99,67%.

Un’installazione Tier 2 disporrà di componenti di potenza ridondati che possono essere sostituiti senza spegnere gli elementi critici del sistema, in modo da portare avanti alcuni interventi di manutenzione senza provocare downtime, mentre altri interventi più importanti richiederanno comunque lo spegnimento dell’intero sistema. Complessivamente c’è da aspettarsi per questi data center una disponibilità del 99,74% corrispondente a 23 ore l’anno di inattività.

Decisamente più adatto ad applicazioni critiche è il Tier 3, in cui componenti di potenza, percorsi di distribuzione e tutti i carichi che alimentano i sistemi IT sono ridondanti. Il sistema può quindi funzionare anche durante interventi di manutenzione ordinaria e straordinaria, e solo guasti gravi o multipli o errori umani possono portare a momenti di inattività. La percentuale di availability attesa per questi sistemi è del 99,98%, e il suo downtime in un anno si misura in appena 95 minuti.

Nei prossimi 10 anni metà dell’energia dei data center potrebbe arrivare da fonti rinnovabili

Nemmeno i guasti più importanti possono fermare un data center Tier 4. In questi sistemi a prova di tutto sono ridondanti anche i sistemi che portano energia alla ventilazione e al raffreddamento. La sua architettura prevede che tutti i componenti di supporto siano multipli, isolati e indipendenti. Perfino le fonti di energia che lo alimentano devono essere ridondanti e protette. Un Data center Tier 4 è fatto per non spegnersi mai, salvo in caso di incendio o catastrofe naturale. La sua percentuale attesa di availability è del 99,995%, cono solo 26 minuti di inattività media per anno.

Il data center del 2025

Se questo è lo stato dell’arte, c’è da chiedersi come saranno i data center che si costruiranno nel prossimo decennio, che dovranno sopportare flussi di dati in crescita esponenziale e un cloud che potrebbe sobbarcarsi il 60% dell’attività computazionale globale.

Una ricerca del 2014, promossa da Emerson Network Power ha affrontato il tema con 800 manager di data center in tutto il mondo.

Per molti la sfida sarà quella di realizzare siti in gran parte alimentati da fonti rinnovabili. L’energia solare potrebbe fornire almeno 1/4 della potenza necessaria ad alimentare il tutto, a patto di risolvere in modo innovativo i problemi di riscaldamento e superare i limiti di efficienza attuale di questa tecnologia. Altra energia arriverebbe dall’eolico, dal geotermico e soprattutto dalle fuel cell, per arrivare a coprire fino al 50% delle necessità.

Secondo il 58% degli intervistati i data center, in controtendenza, saranno più piccoli di quelli attuali circa della metà. Questo comporterebbe una maggior densità dei rack che per il 26% degli intervistati dovrebbero passare dai 40 kWh agli 80 kWh. C’è perfino un buon 15% che si aspetta di arrivare addirittura ai 100 kWh. Sarebbe una bella sfida di ingegnerizzazione.