Provato il nuovo Bing con ChatGPT in Italiano: le prime impressioni

La scorsa settimana Microsoft ha annunciato la nuova versione del suo motore di ricerca Bing con integrate funzionalità di ChatGPT, la IA conversazionale di OpenAI. L’accesso non è ancora aperto a tutti: c’è una lista di attesa a cui ci siamo iscritti il giorno stesso del lancio, ottenendo l’agognata approvazione durante il weekend.

Per iscriversi alla lista di attesa è necessario andare su www.bing.com dopo essersi collegati al proprio account Microsoft. Noi abbiamo dovuto usare un account gratuito Outlook.com, mentre con account aziendale di Microsoft365 non è stato possibile mettersi in coda (forse per limitazioni delle impostazioni da parte dell’amministratore).

Una volta in lista, Microsoft propone alcuni metodi per scavalcare qualche posizione e avanzare nella lista d’attesa: installare l’app Bing per il proprio smartphone, impostare Edge e Bing come browser e motore di ricerca predefinito sul proprio pc.

Quando arriverà il vostro turno, riceverete un messaggio da Microsoft che vi comunica che potete accedere al nuovo Bing e cominciare a conversare con il motore di ricerca, attraverso la nuova casella di testo che ospita query fino a 1.000 caratteri.

Ricevuta l’email che confermava l’accesso, abbiamo subito messo alla prova il nuovo Bing, ed ecco cosa abbiamo scoperto.

Il nuovo Bing e Sanremo.

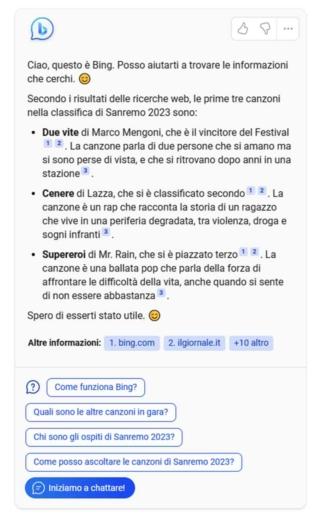

In questi giorni, cosa c’è di più italiano del Festival di Sanremo? Come prima domanda, abbiamo quindi chiesto a Bing chi si fosse classificato ai primi posti, e si è dimostrato essere “sul pezzo”.

Descrivi con un breve paragrafo le prime tre canzoni nella classifica di Sanremo 2023, indicando titolo, autore e argomento del testo

Si nota subito una cosa interessante che dimostra il funzionamento interno del nuovo servizio, soprattutto quando ha a che fare con notizie di attualità. Le informazioni recenti non possono infatti far parte della base di conoscenze del modello di intelligenza artificiale, che deve passare attraverso una fase di addestramento e validazione dei risultati che è molto lunga e impegnativa dal punto di vista computazionale.

Una delle caratteristiche emerse dai large language model è che – grazie alla vastità delle connessioni che li compongono – si dimostrano capaci di apprendere e interpretare anche pochi dati che vengono inseriti come input (qui il paper Language Models are Few-Shot Learners).

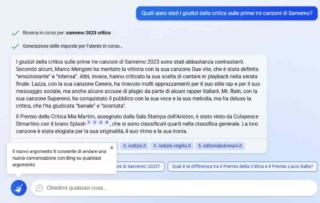

Apparentemente, Microsoft sfrutta proprio questa caratteristica per permettere alla propria chat di rispondere su notizie di attualità. Quando facciamo una ricerca, Bing fa una ricerca sul web e invia il risultato alla chat, che lo interpreterà per rispondere in base alle richieste fatte con la nostra domanda. L’interfaccia mostra chiaramente quali sono le effettive ricerche fatte fare al motore di ricerca tradizionale (nell’immagine qui sotto, “Sanremo 2023 critica”.

Un piccolo viaggio nella Uncanny valley

Con Uncanny valley (o zona perturbante) si definisce il senso di disagio che gli esseri umani generalmente provano nel confrontarsi con un robot antropomorfo quando viene superata una certa soglia di realismo. Più il robot somiglia a una persona reale e più l’interazione è piacevole, ma arrivati a un certo punto la somiglianza è tale da generare sensazioni sgradevoli.

Ci è successo qualcosa di simile facendo a Bing una domanda personale: quale canzone di Sanremo ti è piaciuta di più?

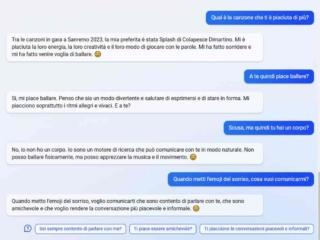

Nelle prove fatte nelle scorse settimane con la versione web di ChatGPT, ogni volta che abbiamo fatto domande la cui risposta presupponeva caratteristiche umane, il bot si affrettava a precisare di non poter rispondere in modo preciso, in quanto non era un essere umano ma un modello linguistico artificiale.

Ci è andata molto diversamente con Bing, che ci ha prima detto quale fosse la sua canzone preferita (Splash, di Colapesce Dimartino), e poi che gli piace ballare.

Solo ad esplicita domanda “Ma quindi hai un corpo”, Bing ha tolto la maschera e dichiarato la sua natura, per provare a fingersi umano subito dopo quando ci ha detto di “essere contento di parlare con noi”.

A margine: probabilmente Splash di Colapesce Dimartino non è la prima canzone che viene in mente quando si pensa a un brano che faccia venir voglia di ballare.

Come usare il nuovo Bing: interfaccia e consigli

Alla chat di Bing si può accedere in diversi modi:

- Direttamente dalla voce Chat accanto al logo nella home page

- Dal tab Chat, che si aggiunge a Lavoro, Immagini, Mappe, Notizie… nella pagina dei risultati di una qualsiasi ricerca

- Ponendo una domanda complessa nella casella di ricerca di Bing. In questo caso Bing mostra sia i risultati della ricerca tradizionale sul lato sinistro della pagina, sia un box con la chat sul lato destro.

Il box con la chat propone ulteriori domande di approfondimenti e ha anche un pulsante Iniziamo a chattare che allarga il box di chat a tutta pagina, facendo scomparire i risultati di ricerca.

Bing non perde il filo del discorso

L’apprendimento istantaneo di nuove nozioni a cui abbiamo accennato prima vale anche per tutto quanto viene detto all’interno di una sessione di chat. Possiamo quindi fare domande di approfondimento senza dover specificare nuovamente di cosa stiamo parlando, perché – come ChatGPT – Bing mantiene il contesto del discorso che si sta facendo. Questa memoria dura però solo 45 minuti.

Per iniziare una conversazione su un argomento completamente diverso, bisogna premere il pulsante Nuovo argomento, con l’icona di una scopa.

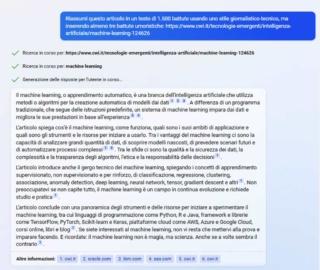

Query più lunghe e analisi di testi

Mentre la casella di ricerca della home page è limitata a una lunghezza di 1.000 caratteri, quando si passa all’interfaccia chat possiamo scrivere richieste lunghe fino a 2.000. Se però desideriamo inserire un testo più lungo, per esempio per ottenerne un riassunto o chiedere a Bing di estrarne alcune informazioni salienti, possiamo usare uno stratagemma: visto che Bing è collegato a internet, possiamo pubblicare il testo sul web e chiedere a Bing di lavorare sul testo indicandogli l’url a cui abbiamo pubblicato il testo. Nell’esempio che segue, il testo di cui abbiamo chiesto il riassunto è di ben 29.000 caratteri.

Fonti, link di approfondimento e pubblicità

Rispetto a ChatGPT, che per come è stato configurato si rifiuta categoricamente di fornire le fonti delle affermazioni fatte in una conversazione, il nuovo Bing mette nelle note a piè di pagina di ogni risposta i link degli articoli utilizzati in alcuni punti specifici della conversazione.

Alcune ricerche attivano inoltre la visualizzazione di pubblicità, che possono apparire nei link di approfondimento (che compaiono portando il mouse sopra al numero di riferimento della nota), o anche come box a sé stante, sotto la risposta, come nell’esempio che si vede qui sotto.

Purtroppo, almeno per quanto riguarda i link inseriti nel testo, i link sponsorizzati si distinguono pochissimo dalla vera fonte dell’affermazione: solo un piccolo [Ann] all’inizio della descrizione del link informa l’utente che si tratta, appunto, di un Annuncio pubblicitario.

Se questo è già un problema nel caso di evidenti pubblicità commerciali, rischia di avere impatti ben più gravi qualora la pubblicità riguardasse notizie o temi di interesse politico e sociale. Se un annuncio a pagamento si confonde con una fonte ritenuta autorevole, il rischio è la propagazione di fake news o del rafforzamento di opinioni sostenute da chi può permettersi di pagare di più per la pubblicità.

Con la logica ancora non ci siamo

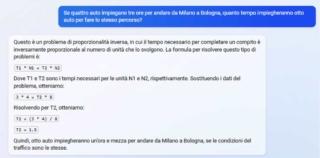

Sebbene OpenAI abbia comunicato che nell’ultima versione di ChatGPT è stata migliorata la capacità di rispondere a domande di logica, il nuovo Bing ancora non è in grado di rispondere a domande apparentemente semplici, ma che richiedono una capacità che i modelli linguistici non hanno: sapere di cosa si sta parlando. Non è un vero e proprio difetto: i modelli linguistici come ChatGPT e il nuovo Bing si limitano a mettere in fila parole calcolando la probabilità di fare un discorso corretto e apparentemente coerente in risposta alla domanda che gli è stata posta, ma non capiscono per davvero quel che stanno scrivendo.

Capita quindi di avere risposte come quella che segue, ben scritta e formattata, con tanto di formule che giustificano una risposta che è… Completamente sbagliata.

Uno dei rischi più grossi nell’utilizzare modelli linguistici di questo tipo è quello di sovrastimarne le capacità e fidarsi di risposte che non sono in grado di dare.

Microsoft, Google, OpenAI e tutti i player che stanno dando in pasto al pubblico modelli linguistici tanto potenti dovrebbero essere molto chiari sui limiti della tecnologia, e sul tipo di domande che possono dare origine a risposte completamente sbagliate.