DGX-1: ecco cos’è il nuovo supercomputer di Nvidia

Si chiama DGX-1 ed è il nuovo super computer che Nvidia ha presentato nelle scorse ore. Jen-Hsun Huang, CEO del produttore hardware americano, ha parlato di questo sistema alla Gpu Technology Conference (Gtc) in corso a San Jose come “una scatola che funziona come un intero data center, o più precisamente un super PC con la potenza di calcolo e le risorse di memoria di 250 server”.

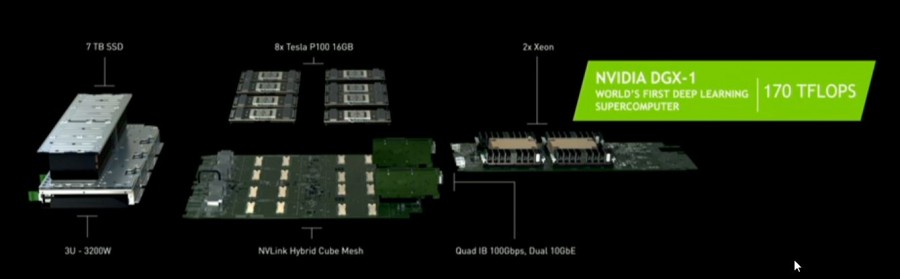

Un supercomputer (il primo del suo genere) che integra in un’unica soluzione software di deep learning e un hardware estremamente potente, il tutto con un form-factor di un singolo server. Il vero cuore del DGX-1, nonché l’elemento che lo rende unico, è l’utilizzo di otto Tesla P100, l’ultimo modello di processore grafico di Nvidia lanciato nella medesima occasione.

Una GPU potentissima con architettura Pascal che integra 15,3 miliardi di transistor realizzati con processo produttivo FinFET a 16 nanometri. All’interno del chip sono presenti 16 GB di memoria HBM2 (High Bandwidth Memory 2) con supporto ECC capaci di una larghezza di banda pari a 720 GB/sec.

Le otto Tesla P100 del DGX-1 comunicano tra loro tramite NVLink, un’interfaccia che permette di ottenere velocità di trasferimento bidirezionale fino a 160 MB/sec, cinque volte maggiore dell’attuale PCIe 3.0.

Altri dati che fanno capire l’eccezionalità di questo supercomputer (e anche il suo prezzo di 129.000 dollari) sono i 7 TB di storage (SSD) e connettività dual 10GbE e Quad InfiniBand 100Gb. Nvidia ha inoltre parlato di un throughput equivalente a quello di 250 server con CPU x86. Il DGX-1 raggiunge infatti i 170 TFLOPS contro i 3 TFLOPS di un sistema con due CPU Intel Xeon-E5, mentre il training di una rete neurale, rispetto alle 150 ore necessarie con un comune server x86, dura solo un paio d’ore.

Ma così tanta potenza a cosa servirà e soprattutto quali sono gli ambiti operativi a cui Nvidia ha pensato nel corso della progettazione del DGX-1, che sarà disponibile a partire da giugno? Huang ha parlato principalmente di intelligenza artificiale per le future auto a guida autonoma, di previsioni metereologiche, della ricerca di nuovi farmaci e di altri scenari per i quali c’è bisogno di reti neurali sempre più complesse.