Nvidia svela una nuova architettura GPU progettata per i data center

Mentre il resto del settore informatico fatica a raggiungere un exaflop di elaborazione, Nvidia sta per superare tutti con un supercomputer da 18 exaflop alimentato da una nuova architettura GPU.

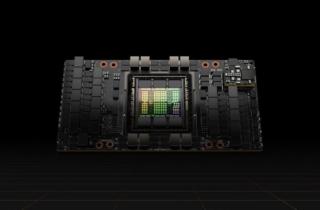

La GPU H100, attesa sul mercato nel terzo trimestre dell’anno, ha 80 miliardi di transistor (la generazione precedente, Ampere, ne aveva 54 miliardi) con quasi 5 TB/s di connettività esterna e supporto per PCIe Gen5, oltre a High Bandwidth Memory 3 (HBM3) che consente 3 TB/s di memoria larghezza di banda. È la prima di una nuova famiglia di GPU con nome in codice Hopper in onore dell’ammiraglio Grace Hopper, la pioniera dell’informatica che ha creato COBOL e ha coniato il termine “bug del computer”.

Questa GPU ha lo scopo di alimentare i data center progettati per gestire pesanti carichi di lavoro di intelligenza artificiale. La famiglia di GPU Hopper include anche la seconda generazione della tecnologia proprietaria Secure Multi-Instance GPU (MIG), che consente di partizionare una singola GPU per supportare la sicurezza negli usi multi-tenant. Il cambiamento più importante apportato dalla GPU H100 è che le MIG sono ora completamente isolate e protette in modo indipendente.

I ricercatori alle prese con carichi di lavoro più piccoli dovevano noleggiare un’istanza CSP A100 completa per l’isolamento. Con la GPU H100, invece, possono utilizzare MIG per isolare in modo sicuro una parte di una GPU, assicurandosi che i loro dati siano al sicuro. “Ora questa potenza di calcolo può essere divisa in modo sicuro tra diversi utenti e tenant cloud”, ha affermato Paresh Kharya, senior director del Data Center Computing di Nvidia. “Parliamo più precisamente di sette volte le capacità MIG rispetto alla generazione precedente.”

Una novità della GPU H100 è una funzione chiamata confidential computing, che protegge i modelli di intelligenza artificiale e i dati dei clienti durante l’elaborazione. Kharya ha osservato che attualmente i dati sensibili sono spesso crittografati a riposo e in transito sulla rete, ma spesso non sono protetti durante l’uso. Confidential computing colma propria questa lacuna proteggendo i dati in uso.

L’architettura Hopper integra anche NVLink di quarta generazione, la tecnologia di interconnessione ad alta velocità di Nvidia. In combinazione con un nuovo switch NVLink esterno, il nuovo NVlink può connettere fino a 256 GPU H100 con una larghezza di banda nove volte superiore rispetto alla generazione precedente.

Infine, Hopper aggiunge nuove istruzioni DPX per accelerare la programmazione dinamica, la pratica di scomporre i problemi con complessità combinatoria in sottoproblemi più semplici. È impiegata in un’ampia gamma di algoritmi utilizzati nella genomica e nelle ottimizzazioni dei grafi. Le nuove istruzioni DPX di Hopper accelereranno la programmazione dinamica di sette volte.

La promessa del supercomputer più veloce al mondo

Queste tecnologie verranno utilizzate per creare sistemi Nvidia DGX H100, unità montate su rack 5U che rappresentano gli elementi costitutivi per potenti supercomputer DGX SuperPOD. Kharya ha affermato che il nuovo sistema DGX H100 offrirebbe 32 petaflop di prestazioni AI, sei volte di più rispetto al DGX A100 attualmente sul mercato. E, se combinato con il sistema di switch NVLink, creerebbe un DGX SuperPOD a 32 nodi che offrirà un exaflop di prestazioni AI e una larghezza di banda bisezione di 70 terabyte al secondo, 11 volte superiore rispetto al DGX A100 SuperPOD.

Per mostrare le capacità dell’H100, Nvidia sta costruendo un supercomputer chiamato Eos con 18 SuperPOD DGX H100 (si tratta di 4.608 GPU H100 unite da switch NVLink e InfiniBand di quarta generazione), per un totale di 18 exaflop di prestazioni AI. Secondo il più recente elenco di supercomputer Top500, il picco di prestazioni a 8 bit del supercomputer più veloce al mondo, Fugaku, raggiunge quattro exaflop; Nvidia promette quindi di andare quattro volte più veloce.

Eos fornirà prestazioni bare metal con isolamento multi-tenant, nonché isolamento delle prestazioni per garantire che un’applicazione non influisca sull’altra. “Eos sarà utilizzato dai nostri team di ricerca sull’intelligenza artificiale, nonché da numerosi altri ingegneri e team di software che stanno creando i nostri prodotti, tra cui la piattaforma per veicoli autonomi e il software di intelligenza artificiale conversazionale”, conclude Kharya.

Nvidia non ha ancora precisato una tempistica per la distribuzione di Eos, mentre i DGX H100 POD e SuperPOD sono previsti entro la fine dell’anno.