Raffreddamento a liquido: una scelta obbligata per lo sviluppo dei data center

Indice dell'articolo

I server e le GPU necessarie per l’intelligenza artificiale hanno consumi così elevati che i grandi hyperscaler stanno cercando fonti energetiche alternative per poterli alimentare. E raffreddare. Già, perché il calore generato dai server è direttamente proporzionale all’energia consumata, per cui anche il loro raffreddamento deve essere potenziato. Aggravando ulteriormente il consumo energetico.

L’efficienza nell’alimentazione e nel raffreddamento dei data center, da questione squisitamente tecnologica, assume oggi una rilevanza esistenziale per i paesi: “Con l’erogazione di servizi digitali essenziali e lo sviluppo della AI, il data center sta diventando un asset strategico, la cui esistenza sul territorio è legata alla possibilità di alimentarlo e raffreddarlo in modo efficiente”, dice Maurizio Frizziero, Direttore della divisione Cooling Innovation and Strategy di Schneider Electric. Il corollario è che “più la dissipazione del calore è efficiente (quindi meno energia consuma) e più energia resterà disponibile per alimentare i server. Se ho 100 megawatt per alimentare un data center, ma ne impiego 35-45 nel raffreddamento, potrò installare una potenza di calcolo limitata. Avere sistemi di raffreddamento più efficienti, quindi, non è più solo motivato dalla riduzione dei costi o delle emissioni, ma permette alle organizzazioni di potenziare un asset strategico”.

La densità e il limite fisico del raffreddamento ad aria

A complicare ulteriormente le cose, c’è il tema della densità dei nuovi sistemi dell’AI. Non solo energia e calore sono elevatissimi, ma sono anche sempre più concentrati in spazi più ridotti.

“Da decenni, la potenza dei server è sempre cresciuta per arrivare oggi a una media di 10-15 kW per ogni armadio nei data center. Con l’avvento delle GPU per AI, però, la curva di crescita della densità di potenza ha preso una deriva esponenziale. Già oggi siamo a 100-150 kW per armadio, ma si sta ragionando su armadi da 500 kW e si prevede la possibilità di arrivare addirittura al megawatt”.

“Da decenni, la potenza dei server è sempre cresciuta per arrivare oggi a una media di 10-15 kW per ogni armadio nei data center. Con l’avvento delle GPU per AI, però, la curva di crescita della densità di potenza ha preso una deriva esponenziale. Già oggi siamo a 100-150 kW per armadio, ma si sta ragionando su armadi da 500 kW e si prevede la possibilità di arrivare addirittura al megawatt”.

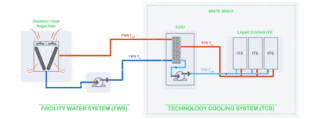

C’è però un problema: il tradizionale raffreddamento ad aria dei data center cessa di essere efficiente attorno ai 30 kW per armadio e non è più applicabile oltre i 50. Oltre quella soglia, diventa fisicamente necessario utilizzare un mezzo liquido per sottrarre calore alle macchine. Cosa che, fortunatamente, aiuta anche nella risoluzione del primo problema, cioè ridurre il consumo dei sistemi di raffreddamento. Essendo lo scambio termico tra solido e liquido molto più efficiente che quello tra solido e aria, il liquido può anche essere mantenuto a una temperatura più elevata, permettendo di impiegare meno energia per raffreddarlo.

Quattro tipi di liquid cooling

A seconda del comportamento termodinamico del liquido impiegato e del tipo di contatto con la superficie da raffreddare, esistono al momento quattro diverse tecnologie di raffreddamento a liquido. Se il liquido refrigerante subisce un cambiamento di fase durante il suo riscaldamento (cioè evapora per essere poi condensato esternamente), si parla di raffreddamento a due fasi (two-phase). Altrimenti, di raffreddamento single-phase.

Il liquido – a fase singola o due fasi – può poi circolare in uno scambiatore di calore a diretto contatto con il chip nel server (direct-to-chip), oppure riempire delle vasche in cui vengono completamente immersi i server (immersion cooling). Ovviamente, è necessario che il liquido non conduca elettricità.

“Il raffreddamento a liquido, in particolare a singola fase e direct-to-chip, non è certo una novità tecnologica e viene usato nei pc gaming dai primi anni Duemila e nei supercomputer da più di dieci anni – dice Frizziero. La sfida quindi non è tecnologica, ma di implementazione pratica e logistica: come avere una soluzione in grado di essere implementata rapidamente e in modo affidabile su migliaia di server? Come progettare i nuovi data center per utilizzarla, e come adattare i data center attuali affinché i carichi IA convivano con i sistemi tradizionali già in funzione”?

Direct-to-chip, single-phase: lo standard di mercato

Queste considerazioni hanno fatto sì che al momento – tranne alcune implementazioni specifiche nell’high performance computing e nel mining delle criptovalute – la stragrande maggioranza del mercato liquid cooling sia costituito da sistemi direct-to-chip a singola fase.

Il primo beneficio è che consente un raffreddamento localizzato solo sul chip. I produttori di server ormai possono fornire macchine già configurate per il liquid cooling, con piastra di raffreddamento già montata sul chip e tubi per l’entrata e l’uscita del liquido, pronti da collegare all’interno degli armadi standard già esistenti.

“Possiamo discutere sulla migliore efficienza teorica dei sistemi a immersioni o a due fasi, ma la possibilità di inserire il raffreddamento a liquido dove serve anche in datacenter raffreddati ad aria, senza dover mettere mano ai progetti delle sale e senza dover smembrare i server per immergerli nelle vasche – con implicazioni su garanzia e responsabilità in caso di guasti – ha fatto emergere il single-phase/direct-to-chip come soluzione standard, almeno a oggi”, afferma Frizziero.

Progettare prevedendo il futuro

Considerata la crescita della potenza e della densità e l’evoluzione delle tecnologie GPU, quel che è valido oggi potrebbe non esserlo più domani. Qui c’è un problema di fondo: “Dall’inizio della progettazione all’apertura di un data center possono passare tre anni, e deve essere pensato per un ciclo di vita di almeno 10 o 15 anni. È quindi necessaria una collaborazione tra tutti i soggetti della filiera – dai produttori di chip e server, a noi che costruiamo i sistemi di alimentazione e raffreddamento, ai progettisti di data center – per avere visibilità su tutto il processo nel contesto della roadmap di sviluppo – avverte Frizziero. Proprio per questo abbiamo stretto una partnership strategica con NVIDIA, in modo da definire i passi dell’evoluzione dei reference design realizzati congiuntamente. Questa conoscenza viene poi trasferita all’ecosistema dei partner attraverso corsi di formazione dedicata e ai progettisti e installatori. È finita l’era in cui ciascun soggetto della filiera poteva occuparsi solo di fornire la sua componente isolata, potendo contare sul fatto che si sarebbe perfettamente integrata con le altre in modo ottimale. È necessario un processo integrato”.

La Cooling Valley italiana è nel Nordest

Pensando alle eccellenze italiane i primi settori che vengono in mente sono la moda, il vino, le supercar o gli Yacht. Pochi sanno però che il Nordest Italiano è universalmente considerato la linea di frontiera globale nello sviluppo delle tecnologie di condizionamento e raffreddamento industriale. Non parliamo solo dello stabilimento e centro R&D di Schneider Electric a Conselve (PD), in cui Frizziero lavora, ma di diverse multinazionali del settore e un’intera filiera di aziende hanno fatto sì che la zona sia conosciuta nel settore come “Cooling Valley”.

“È importante si sappia che nel Nordest italiano ci sono aziende che stanno investendo e innovando le tecnologie del cooling, settore fondamentale per lo sviluppo e il funzionamento dei data center. E io le incrocio ogni sera tornando a casa dal lavoro”.