L’IA sta rivoluzionando l’architettura dei data center: ecco come

Il diffondersi delle applicazioni di intelligenza artificiale (IA), e in particolare il boom della IA generativa, stanno profondamente cambiando anche l’industria dei data center. Ne abbiamo parlato diverse volte, ma è utile tornare sull’argomento quantificando con alcuni dati questo cambiamento grazie a un report di Dell’Oro Group, società di ricerca specializzata negli ambiti tlc, netwoking e data center.

L’AI generativa, scrive Lucas Beran, analista del mercato delle infrastrutture fisiche di Data Center (DCPI) di Dell’Oro Group, contribuirà a una crescita continua del mercato DCPI, mediamente del 10% all’anno almeno fino al 2027, anno in cui gli investimenti Capex nei Data Center supereranno la soglia dei 500 miliardi di dollari.

Il prezzo da pagare per questa spinta alla crescita sono i grandi cambiamenti richiesti nell’architettura dei data center, a causa della potenza computazionale necessaria per istruire e utilizzare i Large Language Model (LLM) che supportano le applicazioni di IA generativa.

Hardware per applicazioni “normali” e AI: le differenze

Un’idea dei tipi di hardware necessari, scrive Beran, ce la può dare l’HPC (High Performance Computing). Che però è utilizzato solo da realtà istituzionali (governative, centri di calcolo, ecc.) o grandi imprese per applicazioni molto specifiche. Ora invece la necessità di infrastrutture del genere si è estesa anche ai service provider e a tutte le aziende utenti interessate appunto ad applicazioni di IA generativa.

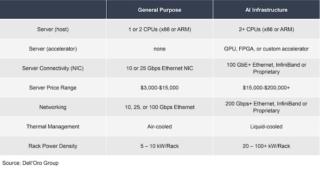

In una tabella, che riportiamo qui sotto, il report mostra le differenze a vari livelli – dai server, al networking, fino alla densità di potenza per rack – tra le infrastrutture di data center necessarie per applicazioni “normali” (general purpose) e per applicazioni di AI.

In estrema sintesi (per la trattazione completa rimandiamo al report di Dell’Olio Group), i workload dell’IA richiedono più potenza computazionale, e più alte velocità di rete, ovvero più alte densità di potenza per rack, cosa che a sua volta impone appunto profondi cambiamenti della DCPI (Data Center Physical Infrastructure). Non tanto a livello di “grey space”, cioè di infrastrutture di back-end, sottolinea Beran, quanto di “white space”, cioè di infrastrutture IT.

Occorreranno rack PDU di potenza più alta, cosa che spingerà l’adozione di rack PDU intelligenti, con funzioni di monitoraggio e gestione della distribuzione di energia nel rack. Rack PDU intelligenti che però hanno costi di vari ordini di grandezza più alti delle rack PDU “normali”.

Liquid cooling, un mercato che nel 2025 varrà 2 miliardi di dollari

Ma soprattutto occorreranno sistemi di raffreddamento “liquid cooling”, per gestire il calore che sarà generato dalle CPU e GPU ad alta densità termica progettate ad hoc per gestire i workload di IA.

Il liquid cooling è un cambiamento tecnologico dirompente per i data center, ma se ne parla già da anni. La sua diffusione infatti è stata finora molto lenta per la difficoltà di trovare una tecnologia efficiente e sostenibile.

Per questo, avverte Beran, anche l’IA, almeno nel breve termine (1-2 anni), avrà un basso impatto in termini di spinta alla diffusione del liquid cooling. La soluzione più diffusa al momento è il retrofitting di facility esistenti con sistemi di liquid cooling “air-assisted”

Per vedere un buon numero di facility costruite con sistemi a raffreddamento liquido bisognerà aspettare il 2025, quando il mercato liquid cooling secondo Dell’Oro Group raggiungerà un volume di fatturato di due miliardi di dollari.

Un possibile ostacolo: la disponibilità di energia

Il mercato DCPI quindi sarà trainato dall’esplosione delle applicazioni AI, ma come sottolinea il report ci sono anche alcuni fattori che potrebbero rallentarne la crescita. Le difficoltà di supply chain provocate dalla pandemia, per esempio, hanno rallentato la costruzione di data center per tre anni. Ora che quel problema sembra in via di risoluzione, se ne sta affacciando un altro: la capacità delle utility di assicurare a tutte le strutture di data center in costruzione e in progettazione la fornitura dell’energia necessaria a farle funzionare.

Una cosa però è sicura, conclude Beran: l’AI ha dato il via a una nuova era in cui l’infrastruttura fisica dei data center giocherà un ruolo decisivo per le loro performance, ma anche per la loro sostenibilità.