Il computer quantistico farà rivivere la Legge di Moore

La tecnologia dell’informazione sta attraversando un momento delicato. Dal punto di vista dell’utente comune, la potenza di calcolo raggiunta potrebbe apparire più che sufficiente, visto che per la maggior parte delle funzioni quotidiane bastano le Cpu dei dispositivi mobili, che per quanto evolute restano insignificanti rispetto a quelle di notebook e workstation. E non è un caso che il mercato dei microprocessori sia sempre più orientato alla riduzione dei consumi piuttosto che alle prestazioni.

Ma all’orizzonte ci sono nuove sfide, dall’analisi predittiva dei big data, alle reti neurali, per le quali la potenza di calcolo non è mai abbastanza. Per non parlare delle frontiere della crittografia.

Il problema è che aumentare la capacità di elaborazione miniaturizzando circuiti di silicio sta diventando troppo costoso, con un costante calo dello yield. Per superare l’impasse, l’industria punta su nuovi materiali, come gallio e indio, ma la verità, di cui i ricercatori sono ben consapevoli, è che qualunque affinamento della tecnologia attuale potrà solo rimandare di qualche lustro l’inevitabile conclusione del percorso di evoluzione dell’elaboratore elettronico così come lo conosciamo da settant’anni.

È la fine annunciata della legge di Moore, sconfitta dal comportamento degli elettroni, che oltre la soglia attuale di miniaturizzazione diventano imprevedibili. Il solo percorso possibile per aggirare il muro del principio di indeterminatezza di Heisenberg è sfruttare le particolarità delle particelle subatomiche, riprogettando i computer su nuove basi in modo che si pieghino alle regole della fisica quantistica.

La nascita del computer quantistico

L’idea di un sistema di elaborazione basato sugli stati delle particelle elementari ha più di trent’anni, e si può far risalire alle intuizioni di Richard Feynman, brillante fisico e visionario divulgatore. Solo nell’ultima decade si è fatto però qualche concreto progresso.

L’obiettivo è quello di sostituire i bit, ottenuti da semiconduttori sfruttando due stati possibili, 1 e 0, con i qubit, che possono trovarsi in quattro condizioni differenti. Nella meccanica quantistica, infatti, le particelle possono assumere contemporaneamente due stati diversi e a ogni qubit possono essere associate tutte le permutazioni di questi due stati, ottenendo quattro possibilità.

Sistemi di elaborazione ottenuti combinando poche decine di qubit associati tra loro potrebbero polverizzare qualunque Hpc basato sulla tecnologia attuale, aprendo le porte ad una nuova età dell’oro dell’IT, capace di affrontare in breve tempo problemi che oggi sono fuori dalla portata dei migliori supercomputer, a meno che non si voglia aspettare più di una vita umana per avere una risposta. Questo perché le particelle, nella fisica quantistica, possono essere legate tra loro pur non interagendo attraverso le forze tradizionali, secondo il misterioso fenomeno denominato entanglement quantistico. Sistemi di qubit sono così capaci di restituire più risultati di calcolo simultaneamente, secondo una progressione esponenziale dipendente dal numero di qubit interconnessi.

In pratica, con un gruppo sufficientemente grande di qubit si potrebbero esplorare innumerevoli opzioni per la risoluzione di un calcolo istantaneamente, operando a una velocità in qualche modo superiore a quella della luce.

Tutto questo in teoria, ma in pratica gli ostacoli da superare per realizzare il computer quantistico sono apparsi finora insormontabili, al punto da mantenerne i progetti in ambito strettamente accademico. Il principale problema è legato alla stabilità estremamente difficile da mantenere dei qubit, che sono facilmente disturbati dall’ambiente e perdono l’informazione appena entrano in contatto con radiazioni elettromagnetiche o per interazione con la materia circostante, tanto che il solo atto della lettura dell’informazione distrugge il dato.

Inoltre sono soggetti al cosiddetto quantum noise. L’espressione dei risultati è infatti più che altro una valutazione probabilistica, sulla correttezza della quale possono pesare errori quantistici poco prevedibili.

Una sfida difficile quindi, ma negli ultimi tempi qualcosa sta cambiando.

IBM a caccia di errori

Nei progetti di ricerca più avanzati nell’ambito del quantum computing, non poteva mancare il contributo di Big Blue. I laboratori IBM Research, in prima fila da trent’anni in quest’ambito, hanno pubblicato sul numero di aprile di Nature Communications uno studio importante proprio sulla previsione degli errori quantistici.

Un computer quantistico pienamente efficiente potrebbe sbriciolare in pochi istanti i sistemi di encryption attuali

I fisici di Ibm hanno messo in piedi un sistema sperimentale a quattro qubit, realizzato a partire dalle proprietà dei superconduttori. Il sistema è organizzato come un chip quadrato da 1/4 di pollice, e proprio questa disposizione dei qubit, sui quattro lati, ha aiutato nell’identificazione contemporanea dei due errori tipici a cui sono soggetti i bit quantistici.

Oltre al classico bit-flip, per cui un 1 è scritto al posto di uno zero, possibile anche nei computer tradizionali e controllato con il bit di parità, i circuiti quantistici sono soggetti anche a errori di fase, detti phase-flip, in cui si inverte il rapporto di sovrapposizione tra i due stati contemporaneamente presenti nel qubit.

L’identificazione contemporanea di questi due errori è una condizione necessaria per ricavare risultati affidabili da un computer quantistico. Il grande vantaggio del lavoro svolto da Ibm è che potrà essere facilmente replicato su sistemi di numerosi qubit, nella speranza che sia risolto il problema di realizzarli in quantità con tecniche simili a quelle con cui si realizzano i normali chip.

D-Wave e l’approccio adiabatico

Il primo prototipo funzionate di computer quantistico, o presunto tale, è in realtà già in commercio. Anzi, è arrivato alla seconda versione. Il primo modello si chiama D-Wave One, sfruttava 128 qubit e ha visto la luce nel 2011. A realizzarlo è stata una società canadese, la D-Wave System Inc. nata dalle intuizioni del fisico Eric Ladizinsky, e finanziata anche dalla Darpa (Defense Advanced Research Projects Agency), che segue i progetti speciali della difesa USA.

Perfino Jeff Bezos, numero uno di Amazon, ha voluto essere della partita, contribuendo a finanziare il progetto con i suoi fondi personali. Per realizzare il D-Wave è stato necessario raffreddare superconduttori a temperature molto prossime allo zero assoluto (si parla di 20 millikelvin) e operare a pressioni 10 miliardi di volte inferiori a quella dell’atmosfera. Questo per ridurre al minimo le interazioni dei qubit con l’ambiente.

Il risultato è stato un sistema realmente funzionante, che effettua calcoli e risolve alcuni problemi in modo sorprendentemente veloce. Questo approccio è la vera novità del D-wave ed è definito adiabatico, mentre i primi esperimenti, e molta della ricerca attuale, sono basati sul cosiddetto recinto quantico (quantum corral). Al progetto si sono subito interessati tanto Google quanto la Nasa, che ha avviato il laboratorio QUail per studiare il funzionamento del D-Wave.

Nel frattempo al primo modello di processore quantico se ne è affiancato un secondo. Il D-Wave Two riunisce 512 qubit e in alcuni problemi ha dimostrato di essere migliaia di volte più veloce di un computer tradizionale. A dire la verità, non tutti sono convinti della reale efficacia del D-Wave, il cui effettivo meccanismo di funzionamento è tuttora oggetto di studio. In particolare, non si sa quanto l’approccio adiabatico reggerà alle evoluzioni future, quando sarà richiesta ancora più potenza di calcolo, da ottenere collegando migliaia di qubit.

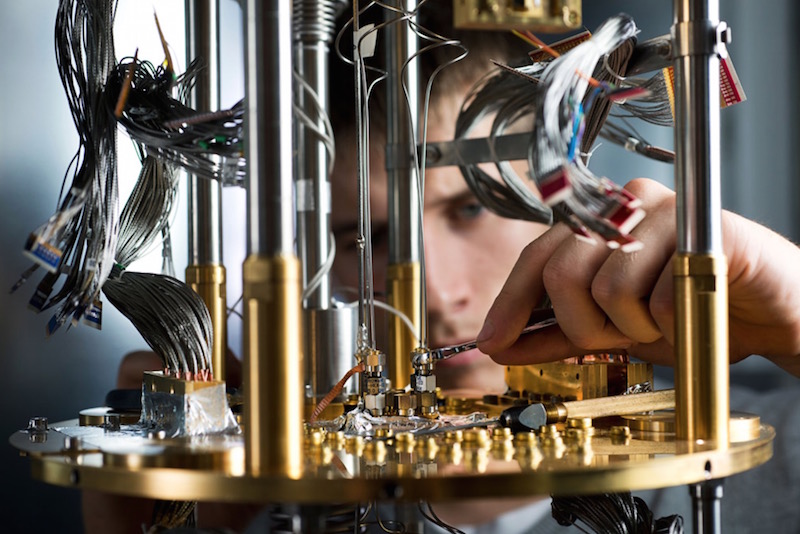

Al di là dell’innegabile fascino vagamente steampunk di questa tecnologia, che fa un uso abbondante di rame luccicante, alla luce dei risultati già ottenuti, e di quelli che vengono regolarmente resi pubblici, il D-Wave è una scommessa a cui non si possono voltare le spalle.

Per molto, ma non per tutto

Non si deve credere, comunque, che il computer quantico sia la soluzione migliore per qualsiasi problema di calcolo. La sua particolarissima struttura lo rende adatto a superare velocemente alcune specifiche situazioni complesse, mentre in altri casi, come il semplice calcolo matematico, il computer attuale resterà a lungo il più adatto. In un certo senso, il suo modo di ‘ragionare’ è simile a quello del cervello umano, più capace di salti improvvisi e soluzioni brillanti che di procedimenti semplici ma ricorsivi.

Potremmo quindi immaginare un futuro, non troppo lontano, in cui gli elaboratori elettronici tradizionali potranno usufruire di una sorta di coprocessore quantistico per accelerare alcune operazioni. Ma quali sono gli scenari in cui l’introduzione dei qubit può rappresentare una vera svolta?

Il primo è quello della sicurezza. Un computer quantistico pienamente efficiente potrebbe sbriciolare in pochi istanti i sistemi di encryption attuali, il che giustifica l’interesse del governo USA a seguirne l’evoluzione con la massima attenzione. Allo stesso tempo, sfruttando le proprietà dei qubit potrebbero essere realizzati nuovi sistemi di codifica praticamente inviolabili.

I computer quantistici potrebbero anche risolvere alcuni dei più famosi problemi matematici finora senza risposta, ma soprattutto potrebbero dare un nuovo impulso all’analisi di grandi quantità di dati, aiutando a trovare il cosiddetto ago nel pagliaio. Anche il riconoscimento vocale o del viso, così come l’interpretazione del linguaggio umano, diventerebbero procedure estremamente facili e veloci.

Anche la biochimica e la medicina ne avrebbero un grande impulso, poiché i computer quantistici sarebbero in grado di valutare in breve tempo innumerevoli combinazioni molecolari alla ricerca di farmaci più efficaci, oltre ad effettuare analisi genetiche istantanee. Ma soprattutto, e questa è davvero fantascienza, si potrebbero tranquillamente pianificare i weekend al mare, perché le previsioni meteorologiche non sarebbero più solo vaghe ipotesi.

In apertura il sistema di raffreddamento del computer quantistico, su gentile concessione di D-Wave Systems Inc.