Le novità dal Red Hat Summit: RHEL 10, AI Inference Server, OpenShift LightSpeed

Il Red Hat Summit 2025, appena conclusosi a Boston, ha confermato ancora una volta il ruolo centrale dell’open source nell’innovazione tecnologica globale. L’evento ha visto infatti la presentazione di tre novità di rilievo: Red Hat Enterprise Linux 10 (RHEL 10), il nuovo AI Inference Server e OpenShift LightSpeed. Queste soluzioni rispondono alle esigenze di aziende che operano in ambienti sempre più ibridi, distribuiti e orientati all’intelligenza artificiale, puntando su sicurezza, automazione e semplificazione della gestione IT.

RHEL 10: la piattaforma enterprise si rinnova

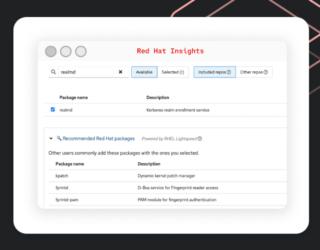

Red Hat Enterprise Linux 10 segna una tappa fondamentale per la distribuzione enterprise più diffusa al mondo. La nuova release nasce per rispondere alle sfide di ambienti cloud e containerizzati, integrando funzionalità che semplificano il lavoro di sviluppatori e amministratori di sistema. Una delle innovazioni più evidenti è l’approccio container-native, grazie al nuovo “image mode” che unifica i processi di build, deployment e gestione sia del sistema operativo che delle applicazioni, in un unico workflow. Questo consente a team DevOps di adottare pratiche comuni, riducendo la complessità operativa e accelerando il rilascio delle soluzioni.

Sul fronte della sicurezza, RHEL 10 si distingue per l’integrazione di crittografia post-quantum conforme agli standard FIPS, un passo avanti per proteggere i dati anche contro le minacce future legate al quantum computing. Sono stati potenziati strumenti come SELinux, esteso il supporto a TLS 1.3 e FIPS 140-2, e introdotta la possibilità di applicare patch al kernel in modalità live, riducendo i downtime e migliorando la resilienza dei sistemi.

L’esperienza utente è stata completamente ripensata. L’installazione infatti è ora più semplice e moderna, con supporto RDP per l’accesso remoto e un nuovo sistema di generazione delle immagini integrato con pipeline CI/CD. RHEL 10 si basa sul kernel 6.11, garantendo performance superiori soprattutto su hardware di ultima generazione come i processori AMD Zen 3 e Zen 4, e aggiorna strumenti chiave come Podman, Buildah e DNF, quest’ultimo ora più veloce e con metadati compressi in zstd.

Tra le novità più importanti spicca anche l’integrazione di Lightspeed, un assistente AI generativo che guida gli utenti nell’amministrazione del sistema semplificando la risoluzione dei problemi e suggerendo best practice direttamente dalla command line.

AI Inference Server: democratizzare l’intelligenza artificiale

L’intelligenza artificiale è ormai un elemento imprescindibile nei carichi di lavoro enterprise. Red Hat ha risposto a questa esigenza presentando il nuovo AI Inference Server, una soluzione open source progettata per semplificare e ottimizzare l’esecuzione di modelli generativi AI su qualsiasi acceleratore e in qualsiasi ambiente cloud.

Basato sul progetto vLLM della University of Berkeley e arricchito con tecnologie Neural Magic, Red Hat AI Inference Server offre strumenti avanzati di compressione e ottimizzazione dei modelli, riducendo il consumo energetico e migliorando le prestazioni. Il server agisce come un layer comune di inferenza, supportando qualsiasi modello AI su qualunque acceleratore (GPU, CPU, ecc.) e in ogni cloud, sia in modalità standalone che integrato con RHEL AI e OpenShift AI.

Questa soluzione risponde a una delle principali sfide dell’AI moderna come l’inferenza, ovvero la fase in cui i modelli pre-addestrati vengono utilizzati per generare risposte in tempo reale. Con l’aumento della complessità dei modelli e delle richieste di produzione, l’inferenza rischia di diventare un collo di bottiglia sia in termini di risorse hardware che di costi operativi. Red Hat AI Inference Server promette proprio di superare questi limiti, offrendo un’esperienza utente più reattiva e la libertà di scegliere modelli, acceleratori e ambienti IT senza vincoli proprietari.

Tra le funzionalità principali spiccano:

- Compressione intelligente dei modelli senza perdita di accuratezza

- Repository ottimizzato di modelli validati, accessibile tramite la pagina Red Hat AI su Hugging Face

- Interoperabilità con piattaforme esterne, incluse Linux e Kubernetes non-Red Hat

- Supporto enterprise e aggiornamenti costanti, ereditati dall’esperienza Red Hat nell’industrializzazione dell’open source

OpenShift LightSpeed: l’IA generativa al servizio della gestione cloud

La terza grande novità uscita dal Red Hat Summit 2025 è il già citato OpenShift LightSpeed, un assistente virtuale basato su IA generativa integrato direttamente nella console di Red Hat OpenShift. L’obiettivo è abbattere la curva di apprendimento per i nuovi utenti e massimizzare l’efficienza degli operatori esperti nella gestione delle piattaforme applicative ibride basate su Kubernetes.

OpenShift LightSpeed offre suggerimenti contestuali, risposte in linguaggio naturale e guida nella risoluzione dei problemi, sfruttando l’integrazione con i principali provider di modelli AI come OpenAI, Azure OpenAI e IBM watsonx. La funzione “cluster-interaction”, ora in preview, permette di ottenere risposte dettagliate e contestualizzate rispetto allo stato reale dei cluster, migliorando la precisione e la rapidità nell’identificazione delle criticità.

Un’altra caratteristica distintiva è la possibilità per le aziende di caricare la propria documentazione e conoscenza organizzativa tramite la funzione BYO Knowledge, personalizzando così l’assistente in base alle esigenze specifiche. Inoltre, LightSpeed supporta la migrazione da vendor di virtualizzazione legacy, fornendo risposte e best practice su temi come networking, storage e modernizzazione delle infrastrutture.

Questa soluzione si inserisce in un contesto in cui la carenza di competenze IT rischia di rallentare l’innovazione: secondo IDC, entro il 2026 oltre il 90% delle organizzazioni globali sentirà il peso di questa crisi, con perdite stimate in trilioni di dollari. OpenShift LightSpeed mira a colmare questo gap, accelerando l’adozione di tecnologie avanzate anche da parte di team meno esperti.

RHEL 10 ridefinisce la piattaforma Linux per ambienti cloud e AI, l’AI Inference Server democratizza l’accesso all’intelligenza artificiale generativa e OpenShift LightSpeed porta l’AI generativa direttamente nella gestione delle infrastrutture.