Data fabric: il ‘tessuto’ per integrare i dati

Quando i dati diventano big, etereogenei, da interpretare, verificare e normalizzare, ma necessari per prendere decisioni in tempo reale, conviene sperimentare nuovi approcci per velocizzare la loro elaborazione. Qualunque azienda di livello enterprise deve fare i conti con fonti di informazioni molto diverse, che superano di parecchio i confini, la standardizzazione e la sicurezza del classico database aziendale. Intanto quest’ultimo non è più singolo, visto che non è infrequente che la stessa azienda usi in ambiti diversi altrettanto differenti tecnologie di archiviazione e ricerca delle informazioni. Ma soprattutto sono i web service e le soluzioni in cloud a costituire fonti di dati alternative, ben lontane dai data center di riferimento e quindi difficili da integrare, anche in termini di connessioni fisiche, quantomeno in modo abbastanza efficiente da fornire ai decisori l’immediatezza di risposta di cui avrebbero bisogno.

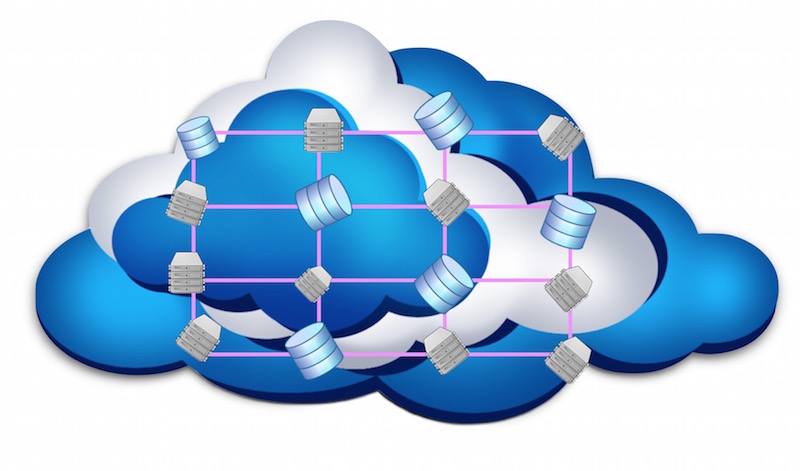

La soluzione è una diversa architettura di queste interconnessioni, capace di collegare elementi di data center, mainframe o servizi secondo una logica funzionale finalizzata a precisi obiettivi di integrazione delle informazioni, creando una sorta di trama di connessioni, detta data fabric, secondo un concetto direttamente mutuato dal grid computing, sviluppato all’inizio degli anni ’90.

Con grid computing si fa riferimento a un insieme di risorse di elaborazione connesse tra loro per collaborare a uno scopo comune. Ogni nodo del ‘tessuto’ di un simile sistema distribuito può avere caratteristiche differenti e svolgere una specifica porzione della macro attività di cui si occupa l’intera struttura. Questa differenziazione tra i nodi distingue il grid computing da altri sistemi di calcolo distribuito, come il cluster computing, sfruttato dagli Hpc.

Nuova vita ai vecchi sistemi

Una struttura progettata secondo i criteri del data fabric permette quindi di usare anche database relativamente datati ma agili e semplici da gestire, come quelli basati su MySQL, garantendo allo stesso tempo la scalabilità necessaria alle crescenti esigenze di affidabilità e prestazioni con grandi quantità di dati. Si tratta in pratica di costruire un sistema complesso partendo da nodi più semplici, attraverso un’accurata progettazione, unificando e aggiornando i metodi di connessione dei nodi, che potrebbero avere protocolli di comunicazione diversi, e unificando il tutto con un moderno sistema di gestione e interrogazione. Così un insieme di decine di server Dbms opererà come un solo database secondo un approccio SaaS, senza che chi lo sfrutta debba preoccuparsi della gestione dei singoli sistemi. Le applicazioni si connetteranno al data fabric nello stesso modo in cui possono connettersi ai singoli Dbms che lo compongono.

Ne deriva una struttura assai più semplice di quella multi-livello di un data center tradizionale, che sfrutta meglio la banda disponibile riducendo la latenza e evitando gli sprechi e le ridondanze che caratterizzano molti sistemi di gestione dei dati.