Data center verso il raddoppio nel 2030, ma in EU ci sono 7 anni di attesa perché manca energia

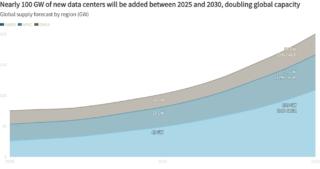

Il settore dei data center sta entrando nella fase più intensa della sua storia recente e, secondo il nuovo report di JLL, da qui al 2030 la capacità globale potrebbe aumentare di circa 97 GW, arrivando a quota 200 GW complessivi. Tradotto in termini industriali, significa un raddoppio in appena cinque anni, un ritmo che ricorda più le grandi corse infrastrutturali del passato che l’evoluzione graduale tipica dell’IT enterprise. La differenza, oggi, è che la domanda non arriva solo dal cloud “tradizionale”, ma dall’AI, che sta trasformando il data center in una fabbrica di calcolo ad altissima densità.

La crescita prevista è pari a un CAGR del 14% fino al 2030, sostenuta principalmente dall’espansione hyperscale e dall’aumento dei workload legati all’intelligenza artificiale. È una combinazione potente, considerando che da un lato i grandi cloud provider continuano ad assorbire domanda globale per servizi digitali, mentre dall’altro i modelli generativi richiedono capacità di calcolo e reti interne che spingono le infrastrutture al limite.

Dal punto di vista geografico, le Americhe restano il baricentro del mercato. Concentrano circa metà della capacità mondiale e mostrano anche il tasso di crescita più elevato tra le macro-regioni, con un supply CAGR atteso del 17% fino al 2030. Il dato chiave è che, all’interno delle Americhe, gli Stati Uniti valgono circa il 90% della capacità; è lì infatti che si concentra la maggior parte dei nuovi campus hyperscale, dei contratti energetici e delle sperimentazioni su alimentazione e raffreddamento per carichi AI.

In Asia-Pacifico la traiettoria è diversa ma altrettanto significativa. La capacità dovrebbe passare da 32 GW a 57 GW entro il 2030, con un CAGR del 12%. Qui la colocation cresce a ritmi molto più alti, circa il 19%, mentre l’on-premise è in contrazione, con una previsione di calo del 6%. È l’effetto diretto della migrazione cloud, che nell’area APAC sta svuotando progressivamente le sale server tradizionali delle imprese, spostando budget e consumo verso operatori specializzati.

In EMEA, invece, la crescita prevista è più moderata (intorno al 10% CAGR), ma con una dinamica qualitativamente interessante. Il motore principale è la spinta politica grazie al supporto governativo alle infrastrutture AI e domanda crescente di “sovereign AI cloud”, cioè piattaforme pensate per rispettare requisiti stringenti su localizzazione dei dati e conformità normativa. La regione dovrebbe aggiungere nel 2030 13 GW di nuova capacità, con sviluppo concentrato negli hub europei consolidati e in mercati mediorientali emergenti, che stanno inseguendo strategie di trasformazione digitale molto aggressive.

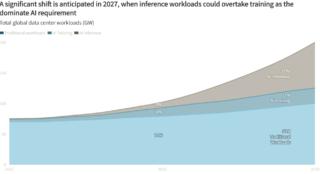

La variabile più dirompente resta l’AI. Nel 2025, i workload AI hanno rappresentato circa un quarto del totale nei data center, con la fase di training come componente dominante. Ma il cambio di marcia è atteso nel 2027, quando l’inferenza, cioè l’uso operativo dei modelli in applicazioni reali, potrebbe superare il training e diventare il driver principale. Un passaggio cruciale perché modifica la natura economica della domanda, visto che addestrare un modello è un investimento concentrato nel tempo (farlo girare in produzione genera consumo continuo, quindi ricavi ricorrenti). Ogni modello rilasciato, se adotta utenti, crea una domanda di inferenza che cresce con la base installata.

Questa domanda, però, non può essere servita soltanto da pochi mega-campus. L’inferenza ha infatti bisogno di distribuzione geografica per ridurre latenza e migliorare l’esperienza utente. È qui che entrano in gioco regioni edge, micro data center e architetture distribuite con un effetto a catena: più capillarità significa più siti, più complessità operativa e più bisogno di energia e connessioni.

Il collo di bottiglia più concreto non è infatti la domanda, ma la potenza elettrica. Nei mercati primari, i tempi medi per ottenere una connessione alla rete superano ormai i quattro anni (e in Europa si arriva anche a sette). Di fronte a questo blocco, gli operatori stanno spingendo soluzioni “behind-the-meter”, cioè alimentazione direttamente in sito, spesso integrata con sistemi di accumulo a batterie. Negli Stati Uniti, il gas naturale viene visto come strumento per aggirare i vincoli della rete sia come soluzione ponte, sia come generazione permanente. Va anche detto che una parte dei grandi tenant hyperscale non ama questa strada, perché il gas è percepito come incompatibile con obiettivi ESG e neutralità climatica.

In EMEA e APAC il gas è meno centrale. Qui cresce l’uso di rinnovabili, soprattutto solare ed eolico, con modelli sempre più interessanti come progetti integrati con trasmissione “private wire”, in grado di ridurre il costo dell’energia per i tenant anche del 40% rispetto alla rete tradizionale. In alcuni mercati, i ritardi di interconnessione stanno spingendo gli operatori oltre i classici PPA (contratti di acquisto di energia elettrica a lungo termine) e così, invece di comprare energia verde, iniziano a finanziare direttamente impianti di generazione. Le politiche “bring your own power”, già visibili in aree come Irlanda e Texas, accelerano ulteriormente questa tendenza.

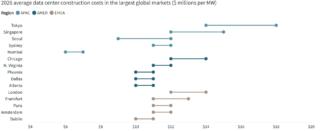

Nel frattempo, costruire data center costa sempre di più. Tra 2020 e 2025 il costo medio globale è salito da 7,7 a 10,7 milioni di dollari per MW, mentre per il 2026 è atteso un ulteriore +6% a circa 11,3 milioni per MW. Questi numeri però si riferiscono solo a shell e core, mentre la parte tecnologica è spesso a carico dei tenant e, per infrastrutture AI, può arrivare fino a 25 milioni di dollari per MW.

In questo contesto, per portare online circa 100 GW di nuova capacità entro il 2030 si parla di un fabbisogno di investimenti che può sfiorare i 3.000 miliardi di dollari, includendo real estate, debito e fit-out tecnologico. È un superciclo infrastrutturale in piena regola che si porta dietro progetti che diventano più grandi, più costosi e più sofisticati (e le barriere all’ingresso si alzano). Chi ha capitali, accesso al debito e competenze ingegneristiche avanzate accelera, mentre la speculazione pura perde spazio e lascia campo a operatori credibili in grado di sostenere tempi lunghi, complessità energetica e requisiti tecnici sempre più stringenti.