Ripensare la gestione dei dati per un time-to-value più rapido

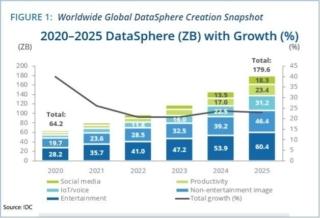

Secondo il Worldwide Global DataSphere Forecast 2021-2025 di IDC, i dati aziendali e sui consumatori si sono accumulati a un tasso di crescita annuale composto (CAGR) di circa il 23% dallo scorso anno, con un CAGR del 28% attribuito alle imprese, e si prevede che raggiungeranno 180 zettabyte entro il 2025. Anche i dati creati nel cloud crescono del 36% all’anno, mentre i dati raccolti all’edge attraverso vari dispositivi IoT e di rilevamento crescono del 33% all’anno e costituiranno il 22% della sfera dati globale totale entro 2025.

Il compito di rendere i dati pronti per il calcolo diventa più complesso con l’aumentare della quantità di dati e le aziende impiegano poco tempo e sforzi per sviluppare processi e piattaforme di gestione dei dati efficaci per rendere questi facilmente utilizzabili. Ad esempio, molte aziende raccolgono enormi quantità di dati sulle transazioni digitali relative ai propri clienti, ordini, utilizzo del prodotto, base di installazione, ticket di servizio, registri di arresto anomalo e informazioni di mercato, ma non hanno un buon modo per creare una visione a 360 gradi di ciascun cliente o della loro attività, nonostante abbiano a disposizione più scelte tecnologiche che mai per estrarre intelligenza dai dati.

Molte aziende hanno raggiunto uno stato in cui è chiaro che la quantità di dati in loro possesso non fornisce un vantaggio competitivo costante né consente loro di trarne facilmente valore. Allo stesso tempo, questa maggiore proprietà dei dati solleva problemi di riservatezza e costi di applicazione e aumenta anche la complessità degli ambienti.

Verso una migliore strategia di gestione dei dati

Le architetture allo stato attuale sono il risultato dell’accumulo di dati senza prima sviluppare una strategia per l’utilizzo efficace e intelligente di tali dati, implementare un mix complesso di tecnologie e processi frammentati e fare affidamento su pratiche di ingegneria dei dati basate su una base di dati molto debole.

Per la maggior parte, queste basi si basano sul metodo di estrazione, trasformazione e caricamento (ETL), che estrae i dati da una serie di origini, trasforma i dati in un formato specifico tramite un server ETL e quindi carica i dati in un dato magazzino dove può essere analizzato e, si spera, presentato come business intelligence. Tuttavia, il processo di trasformazione dei dati può essere alquanto complesso e ad alta intensità di calcolo poiché viene tradotto in un formato che può essere riconosciuto e utilizzato da una linea di database aziendali. Può anche richiedere molto tempo, poiché il processo implica molte attività di I/O, elaborazione di stringhe e analisi dei dati.

Una migliore strategia di gestione dei dati inizia impiegando un processo che inizia con l’estrazione dei dati, quindi caricandoli in repository di dati specifici che trasformano individualmente i dati in una forma più utile e pertinente. Questa metodologia ELT carica i dati nel sistema di destinazione prima di trasformarlo, trasferendo tali compiti a singoli data warehouse basati su cloud.

Invece di utilizzare un singolo motore/server ETL per trasformare tutti i dati grezzi strutturati e non strutturati, con un approccio ELT i segmenti dei dati vengono convogliati a specifici data warehouse cloud in cui tali porzioni vengono trasformate individualmente. Il risultato è un tempo di I/O inferiore e un’analisi più rapida.

Meno caos, più intelligenza

Le future architetture dei dati di stato, basate su una struttura ELT, si concentreranno sulla creazione di un solido livello di base dati e su un approccio basato sulla piattaforma per fornire una soluzione di gestione dei dati onnicomprensiva per l’intera organizzazione. Che si tratti di dati IoT, flussi di clic, intelligence di marketing e di vendita, metriche aziendali o analisi degli utenti, le future architetture faranno affidamento su una piattaforma coesa per ridurre il divario tra l’acquisizione di dati e lo sblocco di valore.

Alcune delle considerazioni chiave per la futura architettura statale sono:

- Implementazione delle funzionalità del livello di base, inclusi connettori, streaming di eventi, writeback dell’origine e MapReduce. Un livello successivo comprenderà il ciclo di vita della gestione dei dati, la modellazione dei dati, l’applicazione dello schema, la privacy dei dati, la governance, i consensi, la sicurezza, i progetti di dati e la gestione.

- Al centro di questa architettura c’è un motore di discovery e autoapprendimento in grado di eseguire la scansione e recuperare i dati da varie fonti nell’ecosistema, adattandosi costantemente alle mutevoli esigenze aziendali e assorbendo la giusta quantità di dati pronti per il calcolo.

- Per soddisfare le realtà del rispetto delle normative sulla privacy dei dati, è necessario che la struttura dei dati e l’astrazione della persistenza forniscano soluzioni per la residenza dei dati.

L’obiettivo finale delle future architetture di stato è eliminare le query di lunga durata e unire i dati aziendali acquisendo elementi di dati pronti per il calcolo che consentano un utilizzo ottimale dell’archiviazione dei dati e delle risorse di elaborazione. Ciò non solo ridurrà la quantità di dati archiviati a una frazione di ciò che archiviamo oggi, ma aumenterà anche la velocità con cui le aziende possono sbloccare una business intelligence utile e utilizzabile.