La strada verso l’intelligenza collettiva

Tra i molti aneddoti e spunti di riflessione venuti fuori dal Sas Forum di Milano, appuntamento annuale della multinazionale specializzata nell’analisi dei big data, il più interessante è stato forse quello proposto dal professor Dino Pedreschi, ordinario di informatica dell’Università di Pisa. Pedreschi ha infatti citato uno studio dei primi del novecento di Sir Francis Galton, antropologo britannico con la passione per la statistica.

Il ricercatore racconta di una sagra paesana in cui si scommetteva su chi sapesse indovinare il peso esatto di una vacca. Facendo la media statistica delle risposte di una moltitudine di persone, Galton era riuscito ad individuare il peso con grande precisione, a dimostrazione di come l’analisi di una quantità sufficiente di dati, per quanto imprecisi possa effettivamente fornire risposte a domande complesse. La cosa curiosa è che applicando lo stesso procedimento a un numero più ristretto ma di esperti allevatori, il risultato era molto meno corretto.

Su questa considerazione poggiano tutte le speranze che riponiamo negli algoritmi di analisi dei dati, sebbene per molte questioni l’intelligenza collettiva non possa ancora essere interpretata senza l’esperienza umana del singolo ricercatore. Questo è ancora più vero quando non si tratta di fotografare l’esistente, bensì di cercare di costruire scenari futuri, necessari allo sviluppo di qualsiasi business. Qui l’errore è dietro l’angolo, come sanno bene le aziende che dopo aver passato anni a portare avanti il proprio business senza variazioni di rilievo, si ritrovano improvvisamente sorpassate da startup che ragionano da punti di vista totalmente diversi.

Per Marco Fredi, CIO di Allianz, molte di queste imprese rischiano di fallire nel momento in cui, messe alle strette dai nuovi concorrenti, si affidano ai propri dati per azzardare un salto nel vuoto, nel tentativo di recuperare una spinta innovatrice che non hanno mai avuto. In realtà “le predictive analytics non funzionano in questi casi. Sono utili solo quando il passato contiene in qualche misura il futuro.” Rimane quindi il ruolo centrale dell’intuizione umana, che contraddistingue le grandi idee dirompenti che cambiano i mercati.

Del resto le aziende sono portate a pensare che visto che dispongono di molti dati, la risposta che cercano sia comunque a portata di mano. Il problema è che, come il classico ago nel pagliaio, talvolta l’elemento utile non è distinguibile dal rumore di fondo. Così ci si può illudere che la risposta sia proprio in questo rumore, confondendo un mucchietto di critiche provenienti dai social network per una reale istanza degli utenti su cui basare cambiamenti nella politica industriale. Del resto, ricorda Fredi, se un tacchino analizzasse il comportamento tipico dell’uomo, che lo cura e lo nutre, dovrebbe dedurne che gli è disinteressatamente affezionato.

Big data e cibo

Tra i grandi temi in cui l’analisi dei dati potrebbe cambiare gli scenari globali, c’è quello del fabbisogno mondiale di risorse alimentari. Resa popolare anche grazie all’Expo, la questione è stata affrontata al Sas Forum da Riccardo Sabatini, laureato in fisica bresciano prestato alla silicon valley. “Attualmente gli investimenti dell’industria mondiale sono concentrati su due fattori, alimentazione e salute, e quello del cibo è diventato un problema incredibilmente complesso”. In questo settore le previsioni fatte nel 2010, che stimavano un andamento del mercato sostanzialmente piatto, sono andate largamente disattese. I bruschi cambiamenti nel prezzo del cibo, che si sono verificati negli ultimi anni, hanno portato a una crisi alimentare drammatica che ha indotto sconvolgimenti di portata globale. Aggiunge Sabatini che perfino la cosiddetta Primavera Araba è stata in parte causata da aumenti nel costo delle materie prime alimentari.

le predictive analytics sono utili solo quando il passato contiene in qualche misura il futuro

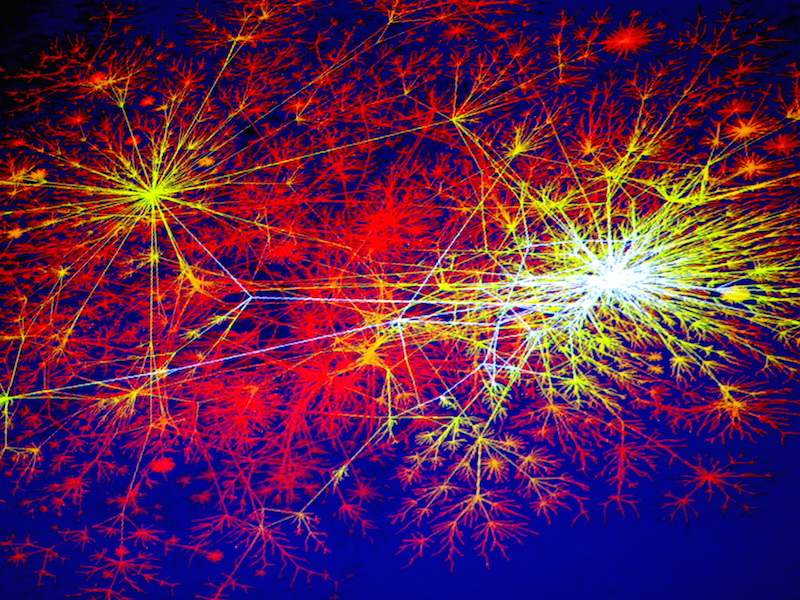

Per tentare di costruire modelli predittivi affidabili in questo ambito, il Ministero per le Politiche Agricole ha commissionato Foodcast, progetto nato dall’unione di imprese pubbliche e private che ha messo insieme esperti di analisi dei dati, fisici e matematici da ambienti universitari, non legati al settore specifico. Il progetto ha dovuto prima di tutto occuparsi di costruire reti predittive inedite, che potessero stimare quantomeno l’andamento futuro nel breve periodo. Il lavoro più lungo è stato reperire e uniformare i dati, poiché quelli legati al cibo seguono regole diversissime tra i vari paesi. Il risultato di un anno e mezzo di questo lavoro è FoodCast DB, che contiene dati di importazione, prezzi e informazioni sulla produzione di qualsiasi alimento. Un archivio simile, interpretato da algoritmi basati su reti neurali specifiche per ciascun prodotto, capaci di considerare l’andamento di tutti i fattori che ne influenzano la produzione, è in grado di prevedere, nel breve periodo ma con con notevole precisione, l’andamento di mercati complessi come quello, ad esempio, del riso.

E con una popolazione mondiale sottoposta a una fortissima crescita demografica, strumenti simili rivestiranno un’importanza sempre più cruciale.

L’inevitabile rivoluzione del Dna

Il secondo ambito in cui l’analisi dei dati porterà progressi tangibili in breve tempo è quello della sanità. La possibilità di raccogliere informazioni da sensori biometrici personali sta già rendendo obsolete le analisi statistiche, che spesso si svolgevano su campioni limitatissimi, e molti studi clinici su cui si basa in larga misura la pratica medica. Presto ciascuno avrà nella sua documentazione sanitaria la madre di tutti i dati, ovvero il proprio codice genetico, sempre più interpretato in profondità e utile per prevenire malattie e correggere tendenze pericolose.

Di questo aspetto ha parlato Massimo Delledonne, docente di genetica e fondatore del Centro di Genomica Funzionale dell’Università di Verona. Delledonne ha paragonato la velocità che nei prossimi anni caratterizzerà la ricerca sui dati genetici a quella di evoluzione dell’informatica, prevedendo un futuro di inevitabile controllo genetico simile a quello paventato nel film Gattaca in cui la conoscenza del Dna condiziona la vita di ciascuno. Inutile aver paura di questa inevitabile rivoluzione, che si è resa in qualche misura necessaria per sostituire la selezione naturale che il progresso della medicina ha alterato. Del resto i vantaggi saranno immensi, anche se per ottenerli è necessario maneggiare quantità enormi di informazioni. “Anche un piccolo gruppo universitario come il mio ha dovuto adeguarsi a gestire big data. Nel giro di quattro anni abbiamo accumulato qualcosa come 130 terabyte di dati, gestiti in raid, quindi con richieste di spazio di archiviazione ancora superiori, più altri 100 terabyte conservati come backup”. Una mole di informazioni a partire dai codici genetici di pazienti che sta raggiungendo una massa critica sufficiente a ottenere risultati significativi. “La ragione per cui interpretiamo il Dna è che prevenire una malattia è meno impattante sulla società che curarla e determina un risparmio di spesa formidabile.”

Dall’alto si analizza meglio

Cos’ha a che fare l’European Space Agency con i big data? Lo ha spiegato Pierre Philippe Mathieu, data scientist specializzato nell’osservazione della terra attraverso i satelliti. Dall’alto non ci sono frontiere e tutto può essere osservato liberamente, raccogliendo quantità di dati incredibili. Il punto di partenza sono gli strumenti meteorologici, che oggi possono guardare attraverso le nuvole, studiare gli effetti del riscaldamento, l’evaporazione e i livelli delle acque. I satelliti attuali possono risolvere dettagli di pochi millimetri e perfino percepire i terremoti. Anche l’Europa ha un programma di monitoraggio spaziale denominato Copernicus, che gestisce rischi potenziali, monitora l’agricoltura, l’innalzamento delle acque e altro ancora. Per intenderci è possibile fotografare una risaia e capire se sulla coltivazione c’è acqua, intuendo così la quantità di riso disponibile e il suo livello di maturazione. In questo ambito ci sono missioni anche finalizzate alla raccolta dati per attività di business, con un orizzonte temporale di quarant’anni, mentre quelle dedicate alla ricerca scientifica sono generalmente programmate per un periodo di attività molto inferiore.

“La nostra sfida è trasformare i dati raccolti in informazioni utili, visto che ormai generiamo un petabyte di dati ogni anno”. Passare da simili quantità di informazioni a pillole della dimensione di un Sms non è un percorso facile, ma i vantaggi per le attività di business possono essere incalcolabili. Come il sistema che oggi può mandare un messaggio quando il riso è pronto per essere raccolto, e in futuro potrà regolare ogni aspetto di un’attività produttiva.

Caccia ai data scientist

Marco Icardi, Vice Presidente di SAS per l’area CEE, si è detto soddisfatto di poter rappresentare, con l’evento milanese, l’eccellenza italiana in un settore così importante. Un settore che ha però ancora bisogno di competenze, che sono un misto tra scienze matematiche e statistiche, informatica, attitudine alla comunicazione e comprensione delle dinamiche aziendali. Sono in molti a considerare quello del data scientist il più interessante mestiere dei prossimi decenni, in cui il ruolo del cercatore di pietre preziose nella massa grezza dei dati farà sempre più la differenza tra un business che galoppa e uno fermo al palo. Per questo, insieme ai partner di SAS, l’evento milanese è stato anche l’occasione per avviare 200 colloqui per nuovi esperti nell’analisi dei dati.