OpenAI Frontier vuole coordinare i tuoi agenti AI. È la risposta a Cowork di Anthropic

OpenAI ha annunciato Frontier, una piattaforma pensata per aiutare le imprese a implementare agenti software in modo più strutturato e “da produzione”. Frontier, che si può considerare come una risposta a Cowork di Anthropic, è un termine che la stessa OpenAI usa da tempo per descrivere i modelli più avanzati, quelli che in teoria rappresentano il confine tecnologico del settore. Qui invece la parola viene utilizzata per un ambiente di esecuzione e orchestrazione per agenti.

Ambiente che nasce per rispondere a un’esigenza sempre più avvertita dalle aziende. I pilot di agenti IA spesso non arrivano mai al valore promesso, funzionano in demo controllate e poi collassano quando devono interagire con sistemi eterogenei, dati incompleti, autorizzazioni granulari, processi non documentati e soprattutto responsabilità. Le organizzazioni più prudenti non sono “lente” per scelta culturale, ma perché ogni automazione che tocca clienti, finanza o compliance è un potenziale incidente operativo.

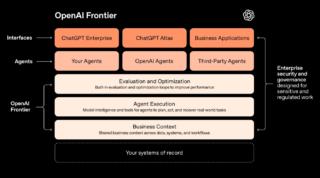

Frontier viene quindi presentato come un livello di coordinamento simile a ciò che Kubernetes è stato per i container, ovvero un’infrastruttura che rende più governabile un ecosistema di agenti, strumenti e dati. L’idea è creare una base comune dove l’agente vive dentro un perimetro tecnico che collega CRM, data warehouse, sistemi di ticketing, calendari, documenti interni e applicazioni proprietarie.

OpenAI insiste molto sul concetto di “business context”. Nel mondo dei modelli linguistici, il contesto è la finestra di token, ovvero testo, istruzioni di sistema, conversazioni precedenti, documenti caricati. In azienda, però, il contesto è un insieme di relazioni tra dati e processi e soprattutto tra permessi. “Contesto business” significa che l’agente può vedere informazioni che normalmente sono distribuite in silos e può usarle per compiere azioni. È qui che la promessa di OpenAI diventa potente, ma anche delicata.

Frontier viene descritto come un “open agent execution environment” capace di abilitare quelli che OpenAI chiama “AI coworkers”. La scelta lessicale suggerisce un passaggio dalla logica dello strumento a quella del sostituto operativo, mentre a livello tecnico il concetto di fondo è la memoria. Secondo OpenAI infatti man mano che gli agenti lavorano, costruiscono ricordi che trasformano interazioni passate in contesto utile, migliorando performance e coerenza nel tempo.

Questa è una delle frontiere più complesse dell’agentic AI in ambito enterprise. La memoria, se gestita male, diventa infatti un vettore di rischio visto che può cristallizzare errori, amplificare bias interni, trascinare dati sensibili in posti dove non dovrebbero stare, o creare dipendenze invisibili. Se gestita bene, invece, è ciò che trasforma un assistente “stateless” in un operatore che impara davvero come funziona un’azienda.

La piattaforma dovrebbe permettere di far convivere fonti come Google Calendar, Salesforce, SAP e documenti di policy, in modo che gli agenti possano eseguire task concreti come rispondere a richieste commerciali, recuperare dati per un account manager, aggiornare ticket, generare report e attivare flussi approvativi. Sembra lineare, ma chiunque abbia visto un ERP in produzione sa che la difficoltà non è “chiamare un’API”, ma è farlo rispettando ruoli, audit trail, eccezioni e processi che non stanno mai in un diagramma.

Non a caso, OpenAI affianca a Frontier una figura tipicamente enterprise come il Forward Deployed Engineer. È una scelta significativa, perché quando un vendor promette ingegneri sul campo, sta implicitamente dicendo che l’implementazione non è plug-and-play. Frontier, insomma, non è una piattaforma “self-service” per sviluppatori curiosi, ma rappresenta un tentativo di entrare nei reparti IT e operations con un’offerta che assomiglia a un programma di trasformazione.

OpenAI, in altre parole, sta cercando di salire di livello, passando dai modelli alle piattaforme operative. Frontier è la traduzione industriale del semplice fatto le aziende non comprano “intelligenza” ma affidabilità, controllo e integrazione. E se l’IA vuole davvero entrare nei processi core, deve smettere di comportarsi come un chatbot brillante e iniziare a somigliare a un sistema enterprise vero, con regole, confini, audit e responsabilità.