I nuovi modelli AI possono diventare tool per cyber attacchi. Parola di OpenAI

L’evoluzione delle capacità cyber dei modelli di intelligenza artificiale sta accelerando a una velocità che fino a pochi anni fa sarebbe sembrata irrealistica. I risultati ottenuti da OpenAI nelle prove capture-the-flag, spesso considerate un indicatore concreto del potenziale operativo di un modello in scenari di attacco e difesa, mostrano progressi vertiginosi: dal 27% registrato da GPT-5 nell’agosto 2025 al 76% raggiunto da GPT-5.1-Codex-Max nello scorso novembre.

Questa traiettoria suggerisce che i prossimi modelli potranno avvicinarsi a soglie di competenza informatica tali da consentire la generazione di exploit complessi o l’assistenza avanzata in operazioni di intrusione industriali ed enterprise, incluse quelle orientate a effetti pratici nel mondo reale.

La discussione che si sta sviluppando all’interno del settore non riguarda più l’eventualità che l’AI possa raggiungere questi livelli, ma piuttosto come strutturare meccanismi di salvaguardia che permettano di valorizzare gli impieghi difensivi senza facilitare l’abuso criminale. Dopotutto, le competenze avanzate in materia di sicurezza informatica sono inevitabilmente dual-use, poiché gli stessi principi che consentono di testare, verificare e correggere vulnerabilità possono essere sfruttati per violare sistemi protetti.

OpenAI e i principali laboratori stanno quindi investendo in un modello di sicurezza multilivello orientato tanto all’hardening infrastrutturale quanto alla progettazione di controlli sull’accesso e sull’uso.

Una strategia che abbraccia una visione di defense-in-depth in grado di combinare autenticazione stretta, monitoraggio continuo degli output, filtri dinamici e verifiche comportamentali. Questo approccio riflette l’assunto che nessuna singola categoria di misura possa risultare sufficiente. Impedire la divulgazione di conoscenze sensibili può essere utile, ma è inefficace se isolato e, allo stesso modo, affidarsi unicamente a sistemi di accesso basati sulla fiducia non può garantire protezione in un panorama in cui minacce e tattiche evolvono in modo imprevedibile.

Ciò che emerge è un ecosistema di controlli interconnessi che mira a guidare, modulare e contestualizzare l’applicazione delle capacità del modello, preservando al contempo la massima utilità per sviluppatori, ricercatori e team di sicurezza.

Al centro di questa transizione vi è anche un forte investimento nel potenziamento delle capacità difensive, affinché queste tecnologie diventino uno strumento che amplifica il lavoro di chi deve proteggere sistemi critici. L’obiettivo è fornire assistenza reale nelle attività quotidiane delle squadre di sicurezza, come l’audit del codice, l’identificazione delle vulnerabilità, la verifica delle superfici di attacco e la remediation rapida. Questo lavoro è sostenuto da iniziative specifiche che includono sistemi avanzati di detection, meccanismi di risposta automatizzata e programmi di red teaming operati da gruppi esperti esterni, autorizzati a tentare in modo metodico l’elusione di ogni barriera.

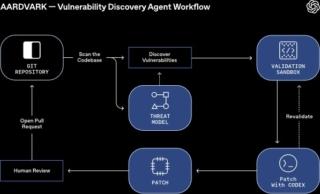

Parallelamente alle misure tecniche, stanno nascendo nuovi strumenti operativi pensati per aumentare l’efficienza dei difensori. Tra questi spicca Aardvark, un agente autonomo progettato per analizzare interi codebase, individuare vulnerabilità anche inedite e proporre patch pronte all’implementazione. Il suo impiego in fase di beta privata ha già permesso di identificare nuove CVE in software open source, dimostrando come un modello ben addestrato possa contribuire direttamente alla sicurezza collettiva. L’intenzione è di offrire copertura gratuita a progetti open source non commerciali, un intervento mirato a rafforzare la supply chain globale.

Una componente altrettanto importante riguarda la dimensione comunitaria. Il confronto con esperti esterni è strutturato attraverso iniziative quali il Frontier Risk Council, un gruppo consultivo che coinvolgerà difensori, professionisti della sicurezza e responsabili tecnici per definire con precisione il confine tra capacità benefiche e possibili abusi. Le considerazioni di questo consiglio influenzeranno direttamente la configurazione delle salvaguardie e il modo in cui i modelli vengono testati prima della distribuzione.

L’altra faccia della collaborazione riguarda il coordinamento tra laboratori attraverso il Frontier Model Forum, dove OpenAI sta lavorando alla definizione condivisa di threat model e best practice per contenere il rischio di utilizzi malevoli. La comprensione delle modalità con cui un attore ostile potrebbe sfruttare un modello avanzato è essenziale per anticipare le aree di vulnerabilità, individuare i colli di bottiglia tecnici e valutare il potenziale di uplift che una certa capacità potrebbe offrire. Questa convergenza è fondamentale per far sì che gli insight più critici non rimangano isolati all’interno di singoli laboratori, ma diventino patrimonio comune del settore.

In questo scenario complesso e dinamico, l’introduzione di programmi di accesso fiduciario rappresenta un ulteriore tassello. L’idea è offrire a organizzazioni e specialisti impegnati nella difesa informatica la possibilità di accedere a versioni dei modelli con capacità potenziate per scopi esclusivamente difensivi, mantenendo al contempo controlli rigorosi sul tipo di utilizzo consentito. Questo meccanismo, ancora in fase di definizione, potrebbe evolvere in un’infrastruttura stabile per la gestione responsabile di capacità sempre più sofisticate.

(Immagine in apertura: Shutterstock)