Con la “sparse attention”, Deepseek V3.2 abbatte i costi del reasoning nell’IA

Alcuni giorni fa, DeepSeek ha pubblicato l’aggiornamento V3.2, rendendolo immediatamente disponibile a tutti gli utenti e distribuendone una versione per il deployment locale sulle principali community open-source. La rapidità del rilascio e l’ambizione dei risultati dichiarati hanno attirato l’attenzione dell’intero settore. Secondo i test ufficiali, l’inferenza di DeepSeek V3.2 è paragonabile a quella di GPT-5, ma con un costo sensibilmente inferiore. In un momento in cui il tema dell’efficienza energetica e computazionale è diventato centrale per l’IA generativa, questo dato da solo ha scatenato grande entusiasmo.

Il nuovo modello arriva in due declinazioni distinte. La prima è la versione gratuita, disponibile direttamente sul sito ufficiale e pensata per l’uso quotidiano. La seconda è V3.2-Speciale, un modello accessibile esclusivamente via API potenziato sul piano dell’inferenza e concepito per valutare i limiti superiori delle capacità attuali di DeepSeek. Questa seconda versione introduce automaticamente una modalità di “long-thinking” avanzata e integra le funzioni di dimostrazione matematica provenienti da DeepSeek Math V2, affinandone la capacità di seguire istruzioni complesse, dimostrare teoremi e verificare passaggi logici in modo più accurato.

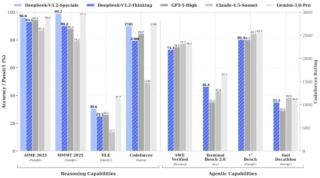

I risultati dei benchmark interni sono particolarmente rilevanti. DeepSeek V3.2-Speciale si posiziona allo stesso livello di Gemini 3.0 Pro nei test di inferenza e ha ottenuto risultati complessivi superiori persino a GPT-5 High nelle prove più complesse di abilità computazionale.

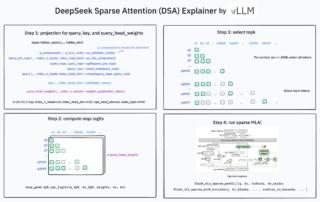

Il merito principale di questo progresso è attribuito all’introduzione del nuovo meccanismo DeepSeek Sparse Attention (DSA), un’evoluzione significativa rispetto all’attenzione classica. Il modello non processa più l’intera sequenza di input, ma identifica e seleziona le parti realmente rilevanti, riducendo drasticamente il carico computazionale.

Se nelle precedenti release DeepSeek aveva accennato a un approccio simile con il meccanismo NSA (Native Sparse Attention), ora il DSA rappresenta una soluzione più matura, flessibile e soprattutto più intelligente nel trattare testi lunghi. La differenza sta nel fatto che NSA lavorava come un archivio che crea un indice tematico, mentre DSA opera come un moderno motore di ricerca capace di interpretare la domanda e individuare con precisione le informazioni utili.

L’impatto pratico è notevole. Per una sequenza da 128K token, DeepSeek dichiara una riduzione dei costi di inferenza superiore al 60%, un incremento della velocità di circa tre volte e mezzo e un abbattimento del consumo di memoria pari al 70%. Tutto questo senza una perdita significativa di performance. Nei test su cluster H800, il costo per milione di token in fase di pre-fill scende da 0,7 a 0,2 dollari, mentre la fase di decoding passa da 2,4 a 0,8 dollari. Numeri che posizionano V3.2 come uno dei modelli più economici al mondo nella gestione del long-context.

La seconda innovazione chiave riguarda la capacità di utilizzare strumenti esterni durante il processo di ragionamento interno. Per la prima volta, DeepSeek consente al modello di decidere autonomamente quando e quali tool impiegare, integrandoli nella propria catena di pensiero senza necessità di riaddestramento.

Ciò significa che il modello non si limita a produrre una risposta basata sui propri parametri, ma può scomporre il problema, interrogare un motore di ricerca, verificare un calcolo, compilare un codice o validare un procedimento matematico tramite strumenti indipendenti. Nel test dedicato alla risoluzione di un rompicapo matematico, il modello non si è accontentato della prima soluzione trovata, ma ha effettuato tre cicli di autoverifica prima di fornire la risposta finale. È una strategia che può sembrare ridondante, ma che risulta fondamentale per ridurre il rischio di errore all’interno di un’architettura che fa uso di sparse attention.

Ancora più interessante è l’esperimento su una catena di attività che prevedeva ricerca, conversione di valori, uso di tool matematici e infine una sintesi interpretativa. DeepSeek ha pianificato correttamente i passaggi, utilizzato gli strumenti adeguati e concluso con la risposta finale, dimostrando una forma embrionale di “autonomia procedurale”.

Resta qualche incertezza, ad esempio in un passaggio in cui il modello ha omesso la valutazione conclusiva pur avendola prevista nel proprio ragionamento, ma la direzione intrapresa è ormai chiara e prevede la trasformazione del modello in un agente complesso, capace di comporre funzioni multiple e orchestrare strumenti diversi con minimo intervento umano.

DeepSeek V3.2 rappresenta dunque una tappa importante nella corsa all’IA globale. Offre prestazioni comparabili ai modelli più avanzati del momento, introduce un’attenzione più efficiente e scalabile e propone un nuovo paradigma di tool-use integrato. Ma, soprattutto, dimostra come l’innovazione possa ancora arrivare da approcci strutturali e non soltanto dall’aumento della dimensione dei modelli.

(Immagine in apertura: Shutterstock)