Mistral lancia la terza generazione dei suoi LLM open source e accorcia le distanze

Con l’annuncio di Mistral 3, la startup francese Mistral AI introduce una nuova generazione di modelli IA che ridefinisce il concetto stesso di intelligenza artificiale aperta. Il rilascio comprende tre modelli compatti e densi da 3, 8 e 14 miliardi di parametri, insieme a Mistral Large 3, l’architettura più avanzata mai prodotta dall’azienda, basata su un mixture-of-experts con 41 miliardi di parametri attivi e un totale di 675 miliardi.

Tutti i modelli arrivano sotto licenza Apache 2.0, una scelta di apertura radicale che mira a consolidare un ecosistema distribuito e realmente accessibile. In un momento in cui molte aziende tentennano sull’open-weight, Mistral sceglie di ampliare l’offerta con vari formati compressi per facilitare integrazione, efficienza e massima flessibilità operativa.

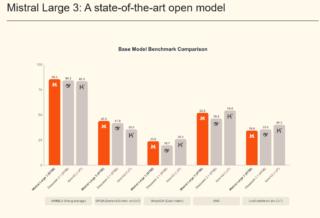

L’obiettivo dichiarato è sia offrire modelli compatti con un rapporto prestazioni-costo superiore alla concorrenza, sia posizionare Mistral Large 3 all’interno della ristretta élite delle architetture open-source in grado di competere con soluzioni proprietarie. Si tratta di un passo strategico nel mercato dei modelli frontier, dove la qualità dell’istruction-tuning determina il valore reale del modello nell’utilizzo quotidiano.

Mistral Large 3 nasce da un pretraining reso possibile da un cluster composto da tremila GPU NVIDIA H200. È il primo modello MoE di Mistral dai tempi della serie Mixtral ed eredita da quel progetto la filosofia di un’architettura scalabile e selettiva nella computazione, seppur con un balzo significativo in termini di qualità.

Dopo il post-training, Large 3 raggiunge la parità con i migliori modelli open-weight disponibili sul mercato nel campo delle instruction generaliste, mostrando al contempo una notevole capacità di comprendere contenuti visivi e una padronanza superiore nelle conversazioni multilingue, soprattutto nelle lingue diverse da inglese e cinese, dove molti modelli soffrono ancora. Al debutto, Mistral Large 3 ha conquistato il secondo posto nella categoria dei modelli open non specializzati nel reasoning su LMArena, posizionandosi sesto considerando l’intera classifica open-source.

Una delle decisioni più rilevanti è la disponibilità immediata sia della versione base sia di quella instruction-tuned, con una variante dedicata al reasoning già prevista. Il rilascio in formato NVFP4, frutto del lavoro congiunto con llm-compressor, vLLM e Red Hat, rende il modello particolarmente efficiente sia su hardware Blackwell NVL72, sia su configurazioni più accessibili come nodi dotati di otto GPU A100 o H100.

Questa attenzione all’ottimizzazione deriva da una collaborazione estesa con NVIDIA, che ha permesso di integrare kernel specializzati per l’attenzione Blackwell e per le operazioni MoE, oltre a supportare modalità di serving disaggregato tra prefill e decode. L’obiettivo è garantire throughput elevato e contesti molto lunghi su infrastrutture di nuova generazione, mentre soluzioni speculative di decoding abbassano ulteriormente i costi computazionali senza sacrificare la qualità.

Parallelamente, la famiglia Ministral 3 propone tre modelli compatti pensati per edge computing e ambienti locali. Le varianti da 3, 8 e 14 miliardi di parametri vengono distribuite sia in versione base, sia in modalità instruction e reasoning, tutte con capacità multimodali e multilingue e anch’esse completamente open-source. È una proposta che si rivolge a scenari in cui latenza, efficienza e costi di deployment sono fattori critici, ma senza rinunciare all’intelligenza avanzata.

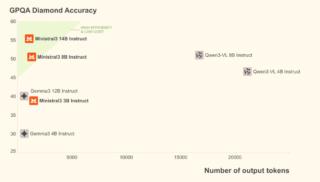

La caratteristica più sorprendente delle varianti instruct è la loro capacità di generare molti meno token rispetto a modelli equivalenti, pur mantenendo e talvolta superando il livello prestazionale della concorrenza. In un contesto reale, questo significa meno tempo di inferenza e meno risorse consumate, un vantaggio tanto economico quanto tecnico.

Quando l’accuratezza diventa la priorità, le versioni reasoning offrono un comportamento più riflessivo, capace di mantenere uno standard elevato rispetto al proprio peso. L’esempio più evidente è il risultato dell’85% su AIME ’25 ottenuto dal Ministral 14B, un dato che lo colloca tra i migliori modelli nella sua categoria. L’intera famiglia è inoltre pensata per essere eseguita su piattaforme NVIDIA ottimizzate per l’edge, dai sistemi DGX Spark ai PC con GPU RTX fino ai dispositivi Jetson, con l’intento di offrire un continuum di prestazioni uniforme dal data center al robot autonomo.

La disponibilità immediata dei modelli su Mistral AI Studio, Amazon Bedrock, Azure Foundry, Hugging Face e molte altre piattaforme rafforza una strategia di distribuzione ampia e orientata alla collaborazione. Anche l’integrazione con NVIDIA NIM e AWS SageMaker è in arrivo, ampliando ulteriormente le opzioni per aziende e sviluppatori.