I “neocloud” per la IA potrebbero durare poco, dice McKinsey

La nascita dei neocloud, provider indipendenti specializzati nella GPU-as-a-service, è una risposta diretta alla scarsità globale di capacità di calcolo ad alte prestazioni e alla volontà dei produttori di chip di diversificare i flussi di ricavi. Le prime implementazioni erano soluzioni provvisorie, create per tamponare la carenza di GPU durante la corsa all’IA generativa, ma col tempo si sono trasformate in un vero segmento infrastrutturale.

Il loro modello, basato sul bare-metal-as-a-service (BMaaS), rimane tuttavia fragile secondo un nuovo report di McKinsey & Company. Sostenibilità e margini non dipendono infatti dalla quantità di hardware acquisito, bensì dalla loro capacità di salire lungo la stack e proporre servizi avanzati, trasformandosi in fornitori di piattaforme software per training, inferenza e orchestrazione. Un salto che li porterebbe inevitabilmente a competere con gli hyperscaler, anche se è probabile che la loro sopravvivenza a lungo termine si giochi su un piano diverso, fatto di nicchie specializzate, compute sovrano e relazioni strette con le startup IA.

Oggi i neocloud risultano particolarmente attraenti perché offrono flessibilità, tempi di provisioning ridotti e configurazioni ottimizzate per workload di IA, mantenendo prezzi fino all’85% più bassi rispetto ai hyperscaler tradizionali. Per molte startup, questa combinazione rappresenta una possibilità di accesso alla capacità computazionale prima impensabile.

Al contempo, la barriera d’ingresso per fondare un neocloud è molto più bassa rispetto a quella richiesta da una piattaforma cloud completa, visto che non serve costruire un’intera stack proprietaria, ma soltanto mettere online cluster GPU ben configurati. Così, in pochi anni, il numero di neocloud è esploso, con oltre 100 realtà nel mondo, 10-15 operatori a piena scala negli Stati Uniti e una diffusione crescente in Europa, Medio Oriente e Asia, spesso sostenute da venture capital o fondi sovrani.

Dietro l’interesse degli investitori ci sono alcune convinzioni chiave che guidano la traiettoria dei neocloud. La prima riguarda il BMaaS stesso: è un punto di partenza, non un punto di arrivo. L’idea è che questi provider riescano col tempo a costruire strumenti software di alto livello, come piattaforme di inferenza distribuita, orchestratori per il training, servizi verticali per settori specifici, strumenti per sviluppatori e MLops gestiti. In questo scenario, i neocloud potrebbero acquisire economie tipiche delle software company, aumentando la fidelizzazione dei clienti e i margini, e arrivando a multipli comparabili al SaaS.

La seconda convinzione è che la domanda di calcolo per l’AI sia troppo grande per essere ignorata. Anche restando confinati al modello BMaaS, la curva del fabbisogno computazionale per training e inferenza sta crescendo a un ritmo senza precedenti (entro il 2030 si stimano fino a 200 gigawatt di capacità necessaria). La limitazione principale resta l’offerta infrastrutturale e chiunque disponga di rack online, pronti e funzionanti, può ragionevolmente aspettarsi una domanda.

La terza idea riguarda il ciclo di vita delle flotte di GPU, che anche quando ammortizzate mantengono un valore residuo significativo. Dopo aver finanziato l’acquisto attraverso grandi contratti a basso margine con gli hyperscaler, i neocloud possono riutilizzare le GPU più datate offrendo servizi a tariffe inferiori a clienti che non necessitano dell’ultima generazione di hardware. Infine, il supporto dei produttori di chip agisce come una forma di derisking, con allocazioni preferenziali, finanziamenti e impegni di acquisto che aumentano la resilienza di questi operatori.

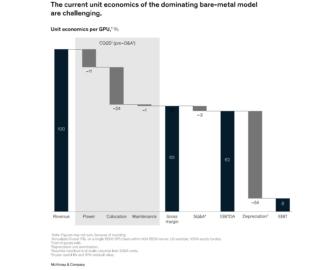

Nonostante questo contesto promettente, l’economia del BMaaS presenta vulnerabilità profonde. I margini lordi, tipicamente tra il 55% e il 65% prima dell’ammortamento, lasciano poco margine d’errore e basta una flessione nei prezzi di noleggio delle GPU (o un tasso di utilizzo sotto l’80%) per azzerare i ritorni.

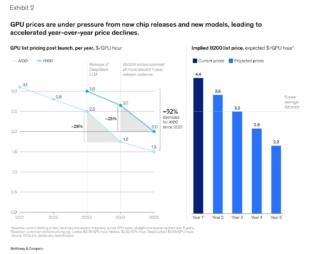

L’aggiunta di debito finanziario amplifica il problema, visto che i costi degli interessi erodono rapidamente qualunque buffer residuo. A complicare ulteriormente lo scenario, interviene il ciclo di rilascio delle GPU (ogni nuova generazione riduce significativamente il valore e il prezzo delle precedenti). In un orizzonte di ammortamento di cinque anni, il costo orario di una GPU può dimezzarsi, imponendo un recupero del capitale accelerato e una continua necessità di reinvestire per restare competitivi.

Neppure i grandi contratti offrono un’ancora di salvezza evidente. Nonostante garantiscano un uso quasi completo delle flotte e un’importante credibilità per il fundraising, i margini effettivi dopo costi operativi ed energia risultano bassi, spesso tra il 14% e il 16%. Per molti neocloud, la dipendenza eccessiva da pochi clienti rappresenta inoltre un rischio sistemico (in alcuni casi, oltre metà del fatturato arriva da una o due realtà hyperscale).

Alla luce di questo complesso equilibrio, i prossimi passi per i neocloud devono affrontare un paradosso strutturale, per il quale gli investitori chiedono di salire nella stack, ma farlo li porta a competere con gli stessi hyperscaler che oggi garantiscono loro il minimo utilizzo necessario a sopravvivere. E sviluppare software robusto, insieme a una strategia commerciale capace di penetrare nel mercato enterprise, richiede capitali, tempo e risorse difficilmente disponibili per la maggior parte dei neocloud.

Tre percorsi appaiono quindi realistici nel medio-lungo periodo.

- Sviluppo di posizioni difendibili in nicchie dove gli hyperscaler non sono ideali, come il calcolo sovrano o i workload iperlocalizzati, spesso sostenuti da governi o fondi strategici

- Continuare a puntare sulle startup IA, costruendo relazioni di lungo periodo che possano evolvere man mano che diventano piattaforme da miliardi

- Alcune realtà verranno acquisite da hyperscaler, telco o fondi sovrani, mentre altre usciranno dal mercato quando l’offerta di capacità tornerà a inseguire la domanda

In definitiva, i neocloud sembrano destinati a sopravvivere non tanto come rivali degli hyperscaler quanto come tasselli complementari dell’ecosistema IA, sfruttando la loro capacità di colmare divari, sostenere innovatori e occupare spazi strategici dove flessibilità e specializzazione contano più della scala.