OpenAI avanza sulla cybersecurity: un modello per classificare policy e un agente per la code review

Sono due le importanti novità per la cybersecurity annunciate da OpenAI.

Classificare policy con l’IA

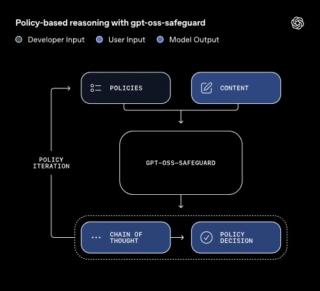

La prima riguarda gpt-oss-safeguard, una nuova famiglia di modelli di ragionamento open-weight per attività di classificazione in ambito sicurezza. Gpt-oss-safeguard fornisce alle organizzazioni pieno controllo sull’applicazione delle policy di sicurezza e la possibilità di personalizzarle sulla base della propria infrastruttura. Questa soluzione è disponibile in due versioni (gpt-oss-safeguard-120b e gpt-oss-safeguard-20b) distribuite con licenza Apache 2.0, che consente a chiunque di usarle, modificarle e distribuirle liberamente.

L’esigenza avvertita da OpenAI nasce dal fatto che i classificatori di sicurezza vengono tradizionalmente pre-addestrati su migliaia di esempi basati su policy di sicurezza predefinite. Nella pratica, ciò significa che questi classificatori devono dedurre autonomamente quale sia la policy e determinare se un contenuto sia sicuro o meno. Di conseguenza, quando i team sono chiamati ad aggiornare una policy di sicurezza, sono costretti a riaddestrare completamente il classificatore, rendendo più difficile modificare le regole, reagire a nuovi rischi e applicare standard specifici per la propria piattaforma.

In tale scenario, gpt-oss-safeguard utilizza capacità di ragionamento per interpretare una policy fornita dallo sviluppatore al momento dell’inferenza, classificando messaggi, risposte o intere conversazioni in base a quella determinata policy in vigore. In questo modo, gli sviluppatori possono applicare qualsiasi policy di sicurezza e consultare il processo di ragionamento del modello per capire come è arrivato a una decisione, rendendo il sistema molto più flessibile, trasparente e allineato alle reali esigenze di applicazione delle regole.

Questo lancio si ascrive inoltre a una più ampia collaborazione con ROOST finalizzata a sviluppare infrastrutture di sicurezza aperte e guidate dalla community. Gpt-oss-safeguard viene infatti lanciato insieme alla nuova community di ROOST dedicata agli sviluppatori di sistemi di sicurezza, dove sarà possibile condividere apertamente policy, esperienze di valutazione e pratiche di implementazione.

Sviluppo software più sicuro

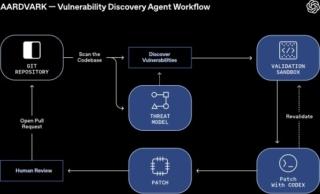

La seconda novità riguarda Aardvark, il nuovo agente di sicurezza autonomo sviluppato da OpenAI e basato su GPT-5. Definito come un “ricercatore di sicurezza agentico”, Aardvark è un sistema intelligente in grado di analizzare continuamente repository di codice, individuare vulnerabilità, valutarne la gravità, stimarne la sfruttabilità e proporre patch mirate.

A differenza dei tradizionali strumenti di analisi statica o dinamica come il fuzzing o la software composition analysis, Aardvark non si limita a cercare pattern predefiniti, ma ragiona sul codice come farebbe un esperto umano. Legge, interpreta, scrive test, usa strumenti, esegue simulazioni e propone correzioni, combinando la potenza del linguaggio naturale di GPT-5 con un sistema di tool-use specializzato.

Il suo funzionamento si articola in una pipeline multi-stadio, pensata per fornire risultati verificabili e di alta qualità. Tutto inizia con l’analisi del repository, durante la quale Aardvark costruisce un threat model del progetto, comprendendone obiettivi e architettura di sicurezza. Successivamente, entra in azione la fase di commit scanning, dove ogni nuova modifica viene confrontata con il modello di minacce per identificare bug e potenziali vulnerabilità appena introdotte.

Quando un nuovo progetto viene collegato, l’agente effettua anche una scansione retroattiva della cronologia per individuare problemi preesistenti. Tutte le scoperte vengono spiegate passo per passo, con annotazioni dirette sul codice per facilitarne la revisione da parte degli sviluppatori.

Una volta individuata una possibile falla, Aardvark tenta di riprodurla in un ambiente isolato e sandboxed per verificare se sia effettivamente sfruttabile. Questo approccio di validazione attiva riduce drasticamente i falsi positivi, uno dei limiti più noti degli strumenti di analisi automatizzata. Dopo la conferma, entra in gioco l’integrazione con OpenAI Codex, che genera una patch mirata e controllata dallo stesso Aardvark prima di proporla come pull request pronta per la revisione umana. L’intero processo avviene all’interno dei normali flussi di lavoro, grazie all’integrazione con GitHub e agli strumenti DevOps già esistenti, mantenendo così la produttività degli ingegneri senza rallentare il ciclo di sviluppo.

Aardvark è attivo da diversi mesi all’interno delle infrastrutture di OpenAI e presso alcuni partner esterni in fase alpha. Nei test interni, l’agente ha individuato vulnerabilità reali in codice di produzione e contribuito in modo significativo al rafforzamento delle difese aziendali. I partner hanno sottolineato la profondità dell’analisi, capace di riconoscere condizioni di errore complesse e difficilmente riproducibili con strumenti convenzionali. Nei benchmark su repository di riferimento, Aardvark ha rilevato il 92% delle vulnerabilità note o introdotte artificialmente, dimostrando un livello di efficacia estremamente elevato.

Il progetto ha trovato applicazione anche nel mondo open source, dove l’agente ha scoperto e segnalato numerose vulnerabilità, dieci delle quali hanno già ottenuto un identificatore CVE (Common Vulnerabilities and Exposures). OpenAI prevede inoltre di offrire servizi di scansione pro bono per alcuni repository open source non commerciali, contribuendo così alla sicurezza dell’intero ecosistema software e della supply chain digitale.