Meta vuole superare gli LLM con il modello I-JEPA, che impara osservando il mondo e non solo leggendo testi

Nel 2023, il Chief AI Scientist di Meta, Yann LeCun, ha delineato una nuova architettura pensata per superare i limiti intrinseci anche dei più avanzati sistemi di intelligenza artificiale. La sua ambizione è costruire macchine capaci di sviluppare un modello interno del mondo che le circonda, così da apprendere in modo più efficiente, pianificare con maggiore efficacia e adattarsi con naturalezza a contesti nuovi o complessi.

Il primo passo concreto verso questa visione è rappresentato da I-JEPA (Image Joint Embedding Predictive Architecture), un modello che apprende astraendo rappresentazioni interne delle immagini invece di concentrarsi sui pixel grezzi. Questa innovativa forma di apprendimento auto-supervisionato promette una maggiore efficienza computazionale, migliori prestazioni e una versatilità d’uso senza bisogno di lunghi processi di fine tuning.

Un modello che “capisce” il mondo

A differenza dei modelli generativi tradizionali, che cancellano o distorcono parti dell’input per poi tentare di ricostruirle, I-JEPA adotta un approccio predittivo basato su rappresentazioni astratte. In pratica, il modello osserva una parte dell’immagine e ne deduce i contenuti mancanti a livello concettuale, evitando così di farsi distrarre dai dettagli irrilevanti e concentrandosi invece sulle caratteristiche semantiche fondamentali.

Questa strategia permette a I-JEPA di apprendere rappresentazioni più robuste e generalizzabili, particolarmente efficaci in attività come la classificazione con pochi dati. In uno degli esperimenti condotti da Meta, un transformer visivo con 632 milioni di parametri è stato addestrato su 16 GPU A100 in meno di 72 ore, ottenendo prestazioni all’avanguardia su ImageNet con appena 12 immagini etichettate per classe. Un risultato che altri modelli raggiungono solo con un dispendio di tempo e risorse da due a dieci volte superiore.

Il cuore del modello: rappresentazioni predittive astratte

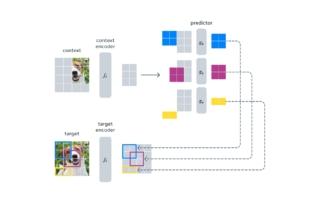

I-JEPA si basa sul concetto di Joint Embedding Predictive Architecture, un’idea che cerca di unire il meglio dell’apprendimento auto-supervisionato e dell’efficienza computazionale. A un alto livello, I-JEPA punta a prevedere la rappresentazione di una parte del segnale (un’immagine o un testo) a partire dalla rappresentazione di un’altra parte compatibile dello stesso segnale. In questo modo, il sistema impara a comprendere relazioni semantiche interne senza dover ricorrere a dati etichettati o trasformazioni artificiose.

Nel caso di I-JEPA, il modello utilizza un encoder contestuale basato su Vision Transformer (ViT), che analizza solo le porzioni visibili dell’immagine. Un secondo modulo predittivo cerca quindi di inferire il contenuto dei blocchi mancanti, condizionandosi su token posizionali che ne guidano la collocazione spaziale. Il risultato è un vero e proprio “modello del mondo” in miniatura, capace di prevedere in modo realistico e coerente porzioni dell’immagine non visibili, come la parte superiore della testa di un cane o le zampe di un lupo.

Oltre il generativo: efficienza e flessibilità

Uno dei vantaggi più evidenti di I-JEPA è la sua efficienza. Mentre altri modelli richiedono molteplici viste dello stesso input o pesanti operazioni di data augmentation, I-JEPA riesce a funzionare con una singola vista e senza trasformazioni complesse. Questo si traduce in un consumo ridotto di tempo e risorse GPU, rendendolo ideale anche in contesti dove l’efficienza è un fattore critico.

Inoltre, i risultati empirici dimostrano che le rappresentazioni prodotte da I-JEPA sono direttamente utilizzabili in numerosi compiti, anche senza ulteriori fasi di addestramento. Il modello eccelle nella low-shot classification e mostra performance competitive anche in task più complessi come il conteggio degli oggetti o la previsione della profondità in immagini statiche.

L’aspetto più promettente di I-JEPA è la sua potenziale evoluzione. Il team di ricerca di Meta infatti sta già esplorando l’estensione dell’architettura JEPA a modalità più ricche e complesse, come video o dati immagine-testo abbinati. In futuro, questo approccio potrebbe consentire a un sistema di AI di fare previsioni spaziali e temporali a lungo termine, magari condizionate da suggerimenti audio o testuali.

La speranza è che modelli come I-JEPA rappresentino un primo passo verso intelligenze artificiali realmente capaci di costruire una comprensione semantica del mondo simile a quella umana. Una macchina che, come noi, apprende osservando passivamente e ragionando in termini astratti, piuttosto che semplicemente memorizzando pixel o parole.

(Immagine in apertura: Shutterstock)