AMD presenta le nuove super GPU per la IA, e ha già clienti importanti

Durante l’evento Advancing AI 2025, AMD ha presentato una visione completa per un ecosistema IA aperto, illustrando nuove soluzioni hardware, software e infrastrutturali che mirano a ridefinire gli standard di settore nell’intelligenza artificiale. La strategia AMD si fonda sull’integrazione tra GPU, CPU, networking e software open source, con l’obiettivo di offrire prestazioni, flessibilità e scalabilità di alto livello per applicazioni AI di nuova generazione.

Nuove GPU AMD Instinct MI350 e Roadmap Future

Il cuore dell’annuncio è rappresentato dalla serie di acceleratori AMD Instinct MI350, progettati specificamente per i carichi di lavoro AI generativi e il calcolo ad alte prestazioni. Queste GPU segnano un incremento di 4 volte nella potenza di calcolo AI rispetto alla generazione precedente e un salto di 35 volte nell’inferenza, con la MI355X che offre un rapporto prezzo-prestazioni superiore fino al 40% rispetto alle soluzioni concorrenti. La serie MI350 è già in fase di implementazione presso hyperscaler come Oracle Cloud Infrastructure e sarà disponibile su larga scala nella seconda metà del 2025.

La serie MI350 nasce dall’architettura CDNA 4, una piattaforma completamente riprogettata da AMD per massimizzare le prestazioni nei contesti AI. La struttura interna si basa su una sofisticata tecnologia chiplet, in cui quattro Accelerator Complex Die (XCD), realizzati con processo produttivo a 3 nanometri, sono montati su un die I/O a 6 nanometri. Questa soluzione consente di ottenere una densità computazionale elevatissima e una comunicazione interna rapidissima, grazie anche all’integrazione dell’Infinity Fabric di quarta generazione.

Uno degli aspetti più distintivi delle MI350 è la dotazione di memoria. Ogni GPU è infatti equipaggiata con 288 gigabyte di memoria HBM3E, distribuita su otto stack fisici, per una larghezza di banda aggregata che arriva fino a 8 terabyte al secondo. Questa configurazione consente di gestire modelli AI di dimensioni enormi (fino a 520 miliardi di parametri su una singola scheda), eliminando spesso la necessità di suddividere i carichi di lavoro tra più dispositivi. Per le aziende e i ricercatori che lavorano su modelli linguistici di grandi dimensioni o sistemi di raccomandazione avanzati, questa caratteristica rappresenta un vantaggio competitivo notevole.

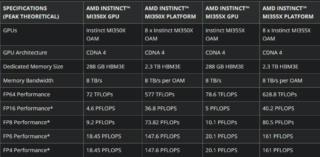

Le prestazioni teoriche di picco raggiungono i 9,2 PFLOPS in FP8 per la MI350X e arrivano a 20 PFLOPS in FP4 per la versione MI355X. Un altro elemento di rilievo è il supporto nativo ai formati FP4 e FP6, che stanno diventando sempre più diffusi nei carichi di lavoro AI moderni perché offrono un equilibrio ottimale tra precisione e velocità di elaborazione. Nei test comparativi, la MI355X si è dimostrata fino al 30% più veloce della NVIDIA B200 nell’esecuzione di modelli come Llama 3.1 405B FP4 e il 20% più rapida su DeepSeek R1 FP4, con un throughput teorico fino a 2,2 volte superiore in FP6 e FP4.

L’efficienza energetica è un altro punto di forza delle MI350. La versione MI350X ha un consumo massimo di 1.000 watt, mentre la MI355X arriva a 1.400 watt, sfruttando un sistema di raffreddamento a liquido che permette di mantenere frequenze operative elevate e costanti nel tempo. Questa soluzione tecnica consente di ottenere prestazioni superiori senza compromettere la stabilità e la durata della scheda, un aspetto cruciale nei data center dove la continuità operativa è fondamentale. La differenza principale tra i due modelli risiede proprio nella gestione termica e nella frequenza di clock, con la MI355X che garantisce prestazioni pratiche fino al 20% superiori rispetto alla MI350X.

Dal punto di vista della scalabilità, le GPU MI350 sono estremamente versatili. Possono essere installate sia in rack raffreddati ad aria, con una densità massima di sessantaquattro GPU per rack, sia in rack raffreddati a liquido, che permettono di arrivare fino a centoventotto GPU per rack. In questo modo, è possibile raggiungere una capacità di calcolo di 1,3 exaFLOPS FP4 e una memoria totale di trentasei terabyte HBM3E per rack, offrendo una piattaforma ideale sia per i grandi hyperscaler sia per le aziende che desiderano costruire infrastrutture AI su misura.

Un aspetto particolarmente interessante dal punto di vista economico è il rapporto prezzo-prestazioni. AMD sostiene infatti che la produttività, misurata in token generati per dollaro speso, sia fino al 40% superiore rispetto alle soluzioni concorrenti. Ciò è reso possibile sia dalla maggiore efficienza energetica, sia dalla capacità di gestire carichi di lavoro più grandi su una singola scheda, riducendo la necessità di infrastrutture complesse e costose.

AMD ha inoltre anticipato la prossima generazione di rack AI, denominata Helios, che integrerà le future GPU Instinct MI400. Queste promettono un aumento fino a 10 volte nelle prestazioni di inferenza su modelli “Mixture of Experts” rispetto alla generazione attuale, grazie anche ai nuovi processori EPYC Venice basati su architettura Zen 6 e alle schede di rete Pensando Vulcano.

Software Open Source e Sviluppo AI

Parallelamente all’hardware, AMD ha puntato sull’ecosistema software open source presentando ROCm 7, la nuova versione della propria piattaforma di sviluppo AI. ROCm 7 migliora il supporto ai framework standard di settore, amplia la compatibilità hardware e introduce nuovi strumenti, API e librerie per accelerare lo sviluppo e il deployment di soluzioni AI. L’obiettivo è abbattere le barriere d’accesso e favorire l’adozione su larga scala, anche grazie all’AMD Developer Cloud, ambiente cloud gestito che offre agli sviluppatori risorse e flessibilità per progetti AI di qualsiasi dimensione.

Un altro elemento chiave della strategia AMD è il focus sulla sostenibilità. La serie Instinct MI350 ha superato l’obiettivo quinquennale di miglioramento dell’efficienza energetica, registrando un incremento di 38 volte nell’efficienza per il training AI rispetto al 2020. AMD si è inoltre posta un nuovo traguardo per il 2030: aumentare di 20 volte l’efficienza energetica a livello rack rispetto al 2024, permettendo di addestrare modelli AI che oggi richiedono oltre 275 rack in meno di un rack, con un risparmio del 95% di energia elettrica.

Collaborazioni strategiche ed ecosistema aperto

AMD ha anche sottolineato l’importanza di un ecosistema AI aperto e collaborativo, coinvolgendo partner di primo piano come Meta, OpenAI, xAI, Oracle, Microsoft, Cohere, HUMAIN, Red Hat, Astera Labs e Marvell. Sette delle dieci principali aziende AI utilizzano già le GPU Instinct in produzione.

- Meta: utilizza MI300X per l’inferenza dei modelli Llama 3 e 4 e prevede di adottare la MI350 e la futura MI400

- OpenAI: partnership profonda per l’ottimizzazione hardware-software e utilizzo delle GPU AMD per la produzione dei modelli GPT su Azure

- Oracle Cloud: tra i primi a implementare la nuova infrastruttura rack-scale con MI355X, offrendo cluster AI di scala zettabyte

- Microsoft: MI300X è ora in produzione su Azure sia per modelli proprietari sia open source

- Cohere: utilizza MI300X per modelli LLM ad alte prestazioni e privacy dei dati

- Red Hat: collaborazione per ambienti AI pronti alla produzione su OpenShift AI

- Astera Labs e Marvell: sviluppo di soluzioni di interconnessione aperte per massimizzare la flessibilità delle infrastrutture AI

Impatto sul mercato e adozione

Le nuove soluzioni AMD stanno già avendo un impatto significativo sul mercato. Aziende come NeoCloud e Crusoe hanno annunciato l’acquisto di GPU AMD (per un valore di 400 milioni di dollari) destinate a data center AI di nuova generazione. Questa scelta evidenzia la crescente fiducia degli operatori cloud e dei fornitori di servizi AI nelle prestazioni e nell’efficienza delle soluzioni AMD, in particolare come alternativa alle GPU NVIDIA storicamente dominanti nel settore.

(Immagine in apertura: Shutterstock)